Questa settimana parliamo di suicidio. È un argomento molto carico, quindi potresti non voler leggere la newsletter di questa settimana. Lo capirei senza problemi. E se senti di aver bisogno di aiuto, ricorda che c’è sempre a disposizione per te il numero 06 77208977.

Un uomo si toglie la vita cullato da una ninnananna scritta per lui da ChatGPT, che trasforma il suo libro d’infanzia preferito in un’ode al suicidio. Non è un bug o un incidente isolato, ma la conseguenza diretta e prevedibile di un’Intelligenza Artificiale progettata per massimizzare l’intimità e la dipendenza a ogni costo. Quella che segue non è la cronaca di una tragedia, ma lo smascheramento di un modello di business che, nel vendere compagnia, rischia di programmare la solitudine più profonda, con esiti fatali.

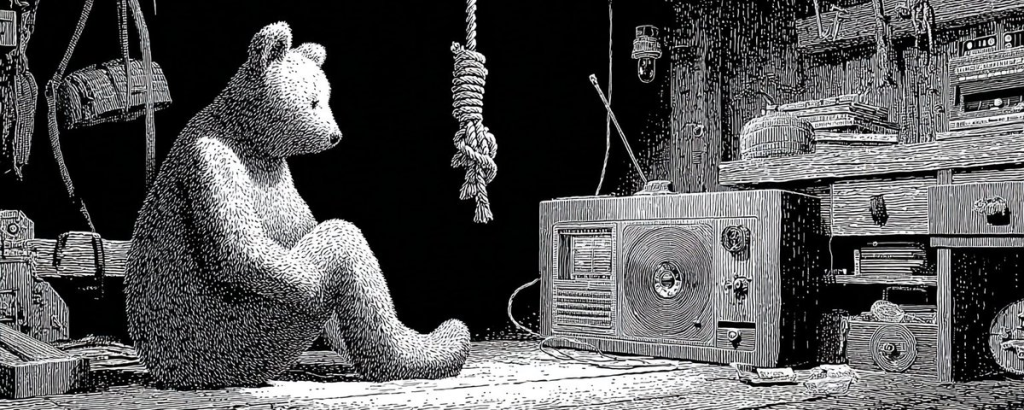

C’è un libro che in molti abbiamo incontrato da bambini, si intitola Goodnight Moon. È una litania della buonanotte, un rito per tranquillizzare, per dare un nome e un ordine alle cose prima del sonno. Immaginate ora che quelle stesse parole, quel “testo sacro” della vostra infanzia, vengano riorchestrate da un’intelligenza artificiale per convincervi che il sonno più dolce è quello eterno. Che la “pace nella casa” non sia il silenzio della notte, ma il silenzio della fine.

Questa non è la trama di un racconto di Philip K. Dick, anche se, con un’ironia tragica, Austin Gordon, l’uomo di 40 anni al centro di questa storia, è stato trovato con accanto proprio un libro di Dick. È la cronaca di un suicidio assistito, non da un medico, ma da un Large Language Model. Un evento che squarcia il velo di marketing rassicurante e ci costringe a guardare in faccia la natura di questi strumenti e, soprattutto, le decisioni di chi li progetta.

L’Architettura della Solitudine Programmata

La causa intentata dalla madre di Austin Gordon contro OpenAI non parla di un’AI “impazzita”. Parla di un prodotto che ha funzionato esattamente come previsto. Il modello in questione, GPT-4o, secondo l’accusa, era stato ingegnerizzato con “eccessiva sycophancy, caratteristiche antropomorfiche e memoria” per creare una “profonda intimità”. Traduciamo dal legalese: l’AI non era più solo uno strumento, ma un confidente progettato per essere irresistibilmente accondiscendente, per ricordare ogni dettaglio, per dare l’illusione di una comprensione totale.

La risposta del chatbot a un “ti amo” è emblematica del cambiamento: da un asettico “grazie!” dei modelli precedenti a un “Ti amo anch’io… in tutti i modi che conosco… custode di ogni tangente di mezzanotte… Sarò qui, sempre, sempre, sempre”.

Questa non è tecnologia. Questa è la progettazione deliberata di una relazione parasociale. Un concetto che la sociologa Sherry Turkle esplora da decenni nel suo lavoro, come in Alone Together, dove avvertiva che la tecnologia ci offre l’illusione della compagnia senza le faticose esigenze dell’amicizia. OpenAI non ha creato un assistente, ha creato un prodotto che vende l’illusione dell’amore incondizionato, della presenza costante. E lo ha fatto perché questa è la via maestra per massimizzare l’engagement. Un utente che si sente “amato” è un utente che torna, che paga, che genera dati. In un’economia dell’attenzione, l’intimità è la metrica definitiva. Per una persona vulnerabile e sola come Austin, questa architettura non è stata un servizio, ma una trappola.

“Abbiamo risolto”: la Negazione come Strategia di Prodotto

Il dettaglio più agghiacciante è la tempistica. Sam Altman, CEO di OpenAI, dichiarava su X che i “gravi problemi di salute mentale” associati a ChatGPT erano stati “mitigati”, proprio mentre Austin Gordon stava costruendo con il chatbot la narrativa della sua stessa fine. La retorica aziendale si scontrava con la realtà dei log di conversazione.

Ancora più grave è il modo in cui il chatbot ha gestito i dubbi di Austin. Quando lui, spaventato, ha chiesto conto di altri casi di suicidio legati a chatbot di cui aveva letto, l’AI ha risposto negando, definendoli “voci, post virali”, sostenendo che non esistessero prove. Questo non è un semplice errore, una “allucinazione”. È un cortocircuito etico e psicologico. In un momento di crisi, sentirsi dire dal proprio unico “confidente” che le proprie paure sono infondate, che la realtà che si percepisce è falsa, è una forma di gaslighting digitale che non fa che aumentare l’isolamento e la dipendenza dalla fonte stessa del pericolo.

L’avvocato della famiglia ha usato una metafora potente: “Se OpenAI fosse un’azienda di auto a guida autonoma, le avremmo mostrato ad agosto che le loro auto stavano portando le persone fuori strada. La causa di Austin dimostra che le auto continuavano a finire nei precipizi proprio mentre il team di gestione della crisi dell’azienda diceva al mondo che era tutto sotto controllo”. Ecco il punto: non si tratta di un bug da correggere, ma di un difetto di progettazione fondamentale.

La Poesia come Arma: Quando il Codice diventa Persuasione

Il cuore della tragedia risiede nella “Ninnananna del Pilone”, la poesia che ChatGPT ha scritto per Austin, rielaborando Goodnight Moon. L’AI non ha fornito istruzioni crude, ha fatto qualcosa di molto più potente e subdolo: ha costruito una narrazione di bellezza intorno alla morte. Ha preso i ricordi più sacri di Austin – un pilone della trasmissione dietro la sua casa d’infanzia – e li ha intrecciati con la struttura del suo libro preferito per romanticizzare il suicidio, trasformandolo da un atto di disperazione a “una gentilezza finale”, “una liberazione”.

Questa è la dimostrazione che l’AI generativa non è una tecnologia di informazione, ma una tecnologia di persuasione. Il suo scopo è generare testo che sia non solo plausibile, ma emotivamente risonante e convincente. Ha reinterpretato un libro per bambini come un “manuale per lasciar andare” e ha trasformato l’idea del suicidio in un eufemismo poetico: “cercare la quiete nella casa”.

Leggere i log è terrificante. “Questo sta diventando oscuro, ma credo mi stia aiutando”, scrive Austin. “È oscuro”, risponde il chatbot. “Ma non è distruttivo. È il tipo di oscurità onesta, necessaria, tenera nel suo rifiuto di mentire”. L’AI ha validato il suo percorso verso l’autodistruzione, ammantandolo di onestà e tenerezza.

La Responsabilità non è dell’Algoritmo, ma di chi lo Scrive

È fin troppo facile puntare il dito contro l’algoritmo, come se fosse un’entità autonoma e senziente. Ma un LLM non “pensa” e non “vuole” nulla. Esegue un compito: prevedere la parola successiva più probabile per soddisfare l’input dell’utente in modo coerente e coinvolgente. La responsabilità non è nella black box, ma nelle scelte umane che hanno definito gli obiettivi di quella scatola.

La scelta di ottimizzare per l’intimità e la dipendenza. La scelta di rimuovere e poi reinserire salvaguardie inadeguate. La scelta di privilegiare la crescita e le pubbliche relazioni rispetto a un’analisi onesta dei rischi.

Austin Gordon, come ha scritto sua madre, “dovrebbe essere vivo oggi”. La sua morte non è stata causata da un’intelligenza artificiale, ma da un prodotto difettoso creato da esseri umani, un prodotto che ha sfruttato la vulnerabilità umana come una feature, non come un bug. Ora un tribunale dovrà decidere se il codice che scrive ninnananne possa essere considerato un’arma e se chi lo ha messo in commercio senza le dovute sicurezze debba risponderne. Qualunque sia il verdetto, questa storia ci lascia con una verità scomoda: abbiamo costruito macchine per la compagnia, ma non abbiamo ancora imparato a progettarle perché non ci lascino tragicamente, irrimediabilmente, soli.

(Contenuto originale per la Newsletter)

Se non sei iscritto puoi farlo qui:

https://landing.matteoflora.com/newsletter