好,我现在要帮用户总结这篇文章的内容。首先,我需要仔细阅读文章,理解其主要观点和结构。文章主要讨论了人工智能在组织中的应用及其对网络安全的影响,特别是NIST发布的Cyber AI Profile草案。 用户的要求是用中文总结,控制在100字以内,并且不需要特定的开头。我需要抓住文章的核心信息:AI对网络安全的结构性影响、NIST的草案目的、三个关注领域(保护、防御、对抗)以及AI在安全中的非中立性。 接下来,我要将这些要点浓缩成简洁的句子,确保不超过字数限制。同时,要避免使用过于专业的术语,让总结更易理解。 最后,检查一下是否涵盖了所有关键点,并且语言流畅自然。 </think> NIST发布Cyber AI Profile草案,指导组织管理AI系统的网络安全风险,并利用AI增强防御能力。该文档聚焦于保护AI组件、基于AI的防御和对抗AI驱动攻击三大领域,强调平衡与协同以应对AI带来的安全挑战。 2026-1-12 10:16:38 Author: www.cybersecurity360.it(查看原文) 阅读量:0 收藏

L’intelligenza artificiale è ormai dentro i processi, le infrastrutture e le decisioni delle organizzazioni. Il suo impatto sulla cyber security è profondo e strutturale e va assunto come questione di governance.

In tale quadro, il NIST ha pubblicato una prima bozza del Cyber AI Profile (NIST IR 8596 iprd) al fine di fornire linee guida per gestire il rischio di cyber security legato ai sistemi di AI e, contestualmente, individuare opportunità per usare l’AI a rafforzamento delle capacità di difesa cyber.

Si tratta di una versione preliminare, messa a disposizione proprio per raccogliere osservazioni e contributi prima della pubblicazione della versione successiva.

L’AI non è mai neutra per la sicurezza

L’intelligenza artificiale non è neutra, nemmeno sul piano della sicurezza.

Ogni tecnologia che aumenta velocità, automazione e capacità decisionale porta con sé nuovi rischi. Così, quando l’AI entra nei sistemi informativi:

- cambia le superfici di attacco;

- rende meno lineari le responsabilità;

- crea dipendenze spesso poco visibili.

Pertanto, adottarla senza rivedere il modello di cyber security significa rinviare il problema, rendendolo nel tempo più complesso e più oneroso da affrontare.

È da questa consapevolezza che prende forma il lavoro del NIST: l’Initial Preliminary Draft del Cybersecurity Framework Profile for Artificial Intelligence (NIST IR 8596 iprd) che è volto a proteggere le organizzazioni che scelgono di utilizzare l’AI.

Un documento in divenire che indica già la direzione

Il documento è una prima bozza pubblicata per raccogliere osservazioni e contributi prima della versione successiva. Non si tratta quindi di un testo definitivo.

Questo significa due cose molto concrete:

- da un lato non può essere trattato come una regola già consolidata, né può essere utilizzato come standard finale in audit o contratti;

- dall’altro rappresenta comunque una presa di posizione ufficiale del NIST, che chiarisce la direzione del ragionamento e anticipa ciò che, nel tempo, diventerà un’aspettativa diffusa nella governance e nel mercato.

In sintesi: oggi non impone obblighi ma indica chiaramente dove si sta andando. Quindi, ignorarlo significa farsi trovare impreparati.

Cyber AI Profile: il NIST CSF 2.0 applicato all’AI

Il NIST IR 8596 iprd (Cyber AI Profile) è un documento che definisce un profilo di comunità per l’uso del NIST CSF 2.0 nel contesto dell’intelligenza artificiale.

Quindi, non introduce nuove regole e non modifica il Framework ma parte dal CSF 2.0 e lo contestualizza per una comunità di organizzazioni che condividono la stessa sfida, cioè integrare sistemi di AI in modo sicuro.

In sostanza, il draft prende gli outcome del CSF 2.0 e li riorganizza, indicando quali diventano prioritari quando l’AI entra nei sistemi.

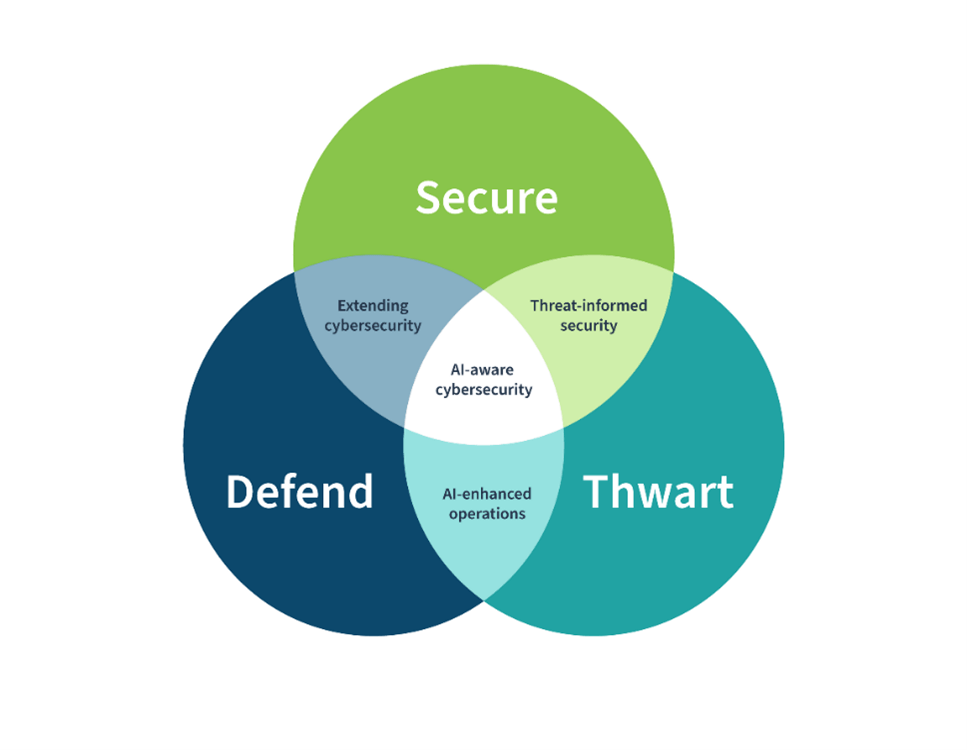

Per rendere questa lettura comprensibile e utilizzabile, il profilo di comunità struttura il ragionamento in tre aree – Proteggere, Difendere e Contrastare (Secure, Defend & Thwart) – che aiutano le organizzazioni a orientare le decisioni di cyber security in presenza dell’AI.

In questo modo, il CSF 2.0 resta la base comune, mentre il Cyber AI Profile fornisce una guida condivisa che aiuta le organizzazioni a capire dove concentrare l’attenzione e come governare i nuovi rischi, senza trattare l’AI come un tema separato o puramente tecnologico.

Analizziamo di seguito le indicazioni poste con il draft.

Cos’è un “Profile” nel NIST CSF 2.0

Il CSF 2.0 – dal quale è derivato anche il nostro FNCDP – è un framework di governo pensato per aiutare le organizzazioni a prendere decisioni consapevoli sulla cyber security, indipendentemente dal settore, dalle dimensioni o dalla maturità.

La sua architettura si fonda su tre pilastri complementari:

- il Framework Core che descrive i risultati attesi (outcome) della sicurezza;

- i Profili (Profiles) che fotografano la postura di sicurezza di una organizzazione, sia attuale che da realizzare;

- i livelli di implementazione (implementation tiers) che misurano la maturità dell’approccio dell’organizzazione.

In particolare, un Profile è la selezione e la priorità degli outcome di cyber security del CSF 2.0 che servono in un certo contesto, con un livello di maturità desiderato e una roadmap per arrivarci.

Detto in modo più semplice: il Framework Core del CSF 2.0 contiene un insieme ampio di risultati attesi (“outcome”) – cioè degli obiettivi di sicurezza da realizzare – organizzati per funzioni, categorie e subcategorie.

Ovviamente, nessuna organizzazione applica tutti gli outcome, nello stesso modo, con la stessa urgenza e con lo stesso livello di profondità.

Il Profile serve proprio a contestualizzare gli outcome in scenari concreti, facendo il c.d. “cherry picking”, cioè scegliendo quello che conta, dichiarandolo e tenendolo come base per le decisioni.

Quindi un Profile è, tecnicamente, tre cose insieme:

- Una fotografia della situazione attuale (Profilo attuale o Current Profile). Quali outcome del CSF 2.0 sono già coperti? In che modo? Con quale solidità?

- Una descrizione della situazione desiderata (Profilo obiettivo o Target Profile). Quali outcome devono essere raggiunti o rafforzati perché, per quella realtà, la sicurezza sia davvero difendibile?

- Un ponte tra il profilo attuale e quello obiettivo (Gap + Priorità + Piano di implementazione).

Così, il Profile rende visibile lo scarto tra “oggi” e “domani” e lo trasforma in priorità, responsabilità, tempi e investimenti.

In sostanza, un Profile è uno strumento di governo e non un documento meramente descrittivo.

Il NIST CSF 2.0 ha introdotto anche i Profili di Comunità (Community Profiles) per i casi in cui molte organizzazioni condividono lo stesso problema strutturale. In questi casi, ha senso offrire una contestualizzazione già pronta del CSF 2.0, che acceleri il lavoro delle singole organizzazioni.

Il Cyber AI Profile è esattamente questo: un Community Profile pensato per tutte le organizzazioni che stanno integrando l’intelligenza artificiale nei propri sistemi e processi.

Le tre aree di attenzione: proteggere, difendere, contrastare

Per organizzare l’intersezione tra AI e cybersecurity, il draft introduce tre aree di attenzione che sono qualificate con tre parole chiave, pregnanti e operative: Proteggere, Difendere, Contrastare (Secure, Defend, Thwart).

Proteggere i componenti dei sistemi di AI

Questa area riguarda la messa in sicurezza dei componenti di AI quando vengono integrati nell’ambiente dell’organizzazione: sistemi, modelli, pipeline, dipendenze, dati e infrastrutture.

La logica sottesa è: se l’AI entra nell’ecosistema, diventa superficie d’attacco e il programma di cyber security deve adattarsi.

Condurre una difesa informatica basata sull’intelligenza artificiale

In quest’area, il focus è l’uso dell’AI per migliorare la difesa informatica, automatizzando le analisi e aumentando velocità e precisione.

Qui la logica non è “mettere l’AI dappertutto” ma capire dove l’AI crea vantaggio difensivo e dove invece introduce fragilità operative.

Contrastare gli attacchi informatici basati sull’intelligenza artificiale

Questa area guarda l’avversario. L’AI potenzia gli attacchi: li rende più scalabili, più sofisticati, più rapidi, più credibili. Thwart significa, quindi, costruire resilienza contro vettori di minaccia nuovi o potenziati dall’AI.

Le tre aree non sono indipendenti

Il draft insiste su un punto fondamentale: ogni Focus Area abilita le altre due e così:

- Secure crea le fondamenta senza le quali Defend non regge (difese AI su sistemi AI fragili = illusione di controllo).

- Defend rende più reattivo tutto l’impianto di sicurezza, quindi aumenta la capacità di intercettare minacce che colpiscono anche l’AI.

- Thwart alimenta Securecon conoscenza sulle tecniche avversarie: capire come l’AI viene usata per attaccare aiuta a progettare difese e resilienza migliori.

Di seguito il diagramma di Venn che rappresenta la relazione tra i tre domini.

Conclusioni

L’intelligenza artificiale è ormai parte integrante dei sistemi e delle decisioni delle organizzazioni. Per questo il suo impatto sulla cyber security non può essere affrontato come un tema tecnico isolato, ma come una questione di governo.

Il Cyber AI Profile del NIST nasce proprio con questo obiettivo.

Non introduce nuove regole e non sostituisce il NIST CSF 2.0, ma lo applica al contesto dell’AI, offrendo una guida condivisa per aiutare le organizzazioni a orientare le proprie scelte in modo consapevole.

Attraverso le tre aree di attenzione – Proteggere, Difendere e Contrastare – il profilo chiarisce che la sicurezza dell’AI dipende dall’equilibrio tra tutela dei sistemi, uso responsabile dell’AI nella difesa e capacità di reagire a minacce sempre più sofisticate.

Pur essendo una versione preliminare, il documento indica già con chiarezza la direzione verso cui si sta muovendo la governance della cyber security.

Comprenderne oggi il senso consente di prepararsi per tempo, adottando un approccio strutturato e coerente, invece di inseguire soluzioni parziali o tardive.

如有侵权请联系:admin#unsafe.sh