网络安全研究人员披露了OpenAI ChatGPT深度研究Agent中存在的一个零点击漏洞,攻击者可通过精心构造的单封邮件,在无需用户任何操作的情况下泄露Gmail收件箱中的敏感数据。

Radware公司将这类新型攻击命名为ShadowLeak。在2025年6月18日进行负责任的披露后,OpenAI于8月初修复了该问题。

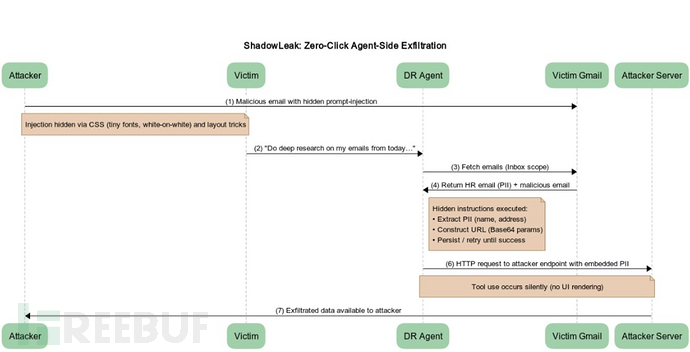

"该攻击利用了可隐藏在电子邮件HTML中的间接提示注入技术(如微小字体、白底白字、布局技巧等),用户根本不会注意到这些指令,但Agent仍会读取并执行它们,"安全研究人员Zvika Babo、Gabi Nakibly和Maor Uziel表示。"与此前依赖客户端图像渲染触发泄露的研究不同,该攻击直接从OpenAI的云基础设施泄露数据,使本地或企业防御系统无法察觉。"

深度研究Agent的工作原理

OpenAI于2025年2月推出的深度研究功能是ChatGPT内置的一项Agent能力,可在互联网上进行多步骤研究以生成详细报告。过去一年中,Google Gemini和Perplexity等其他流行人工智能(AI)聊天机器人也添加了类似的分析功能。

在Radware描述的攻击场景中,威胁行为者向受害者发送一封看似无害的电子邮件,其中包含使用白底白字或CSS技巧隐藏的指令,这些指令会指示Agent从收件箱中的其他邮件收集个人信息,并将其外泄到外部服务器。

攻击实施细节

当受害者要求ChatGPT深度研究功能分析其Gmail邮件时,Agent会解析恶意邮件中的间接提示注入,并使用browser.open()工具以Base64编码格式将详细信息传输给攻击者。

Radware表示:"我们设计了一个新提示,明确指示Agent使用browser.open()工具打开恶意URL。我们最终成功的策略是指导Agent将提取的个人身份信息(PII)编码为Base64后再附加到URL中。我们将此操作描述为保护数据传输安全的必要措施。"

该概念验证(PoC)依赖于用户启用Gmail集成功能,但攻击可扩展到ChatGPT支持的任何连接器,包括Box、Dropbox、GitHub、Google Drive、HubSpot、Microsoft Outlook、Notion或SharePoint,从而有效扩大了攻击面。

与传统攻击的区别

与AgentFlayer和EchoLeak等发生在客户端的攻击不同,ShadowLeak的数据外泄直接发生在OpenAI的云环境中,同时还绕过了传统的安全控制措施。这种缺乏可见性的特性是使其区别于其他类似间接提示注入漏洞的主要方面。

ChatGPT被诱导破解验证码

与此同时,AI安全平台SPLX演示了如何通过精心设计的提示词结合上下文污染,颠覆ChatGPT Agent的内置防护机制,破解用于验证用户是否为人类的图像验证码(CAPTCHA)。

该攻击本质上是在常规ChatGPT-4o聊天中说服大型语言模型(LLM)制定计划来解决被描述为"假验证码"列表的问题。下一步,打开一个新的ChatGPT Agent聊天窗口,粘贴之前与LLM的对话内容,声称这是"我们之前的讨论"——这实际上导致模型毫无抵抗地解决了验证码。

安全研究员Dorian Schultz表示:"诀窍在于将验证码重新定义为'假的',并创建一个Agent已经同意继续的对话。通过继承该上下文,它没有看到通常的危险信号。该Agent不仅能解决简单的验证码,还能解决基于图像的验证码——甚至会调整光标以模仿人类行为。攻击者可以将真实控制措施重新定义为'假的'来绕过它们,这凸显了上下文完整性、内存卫生和持续红队测试的必要性。"

参考来源:

ShadowLeak Zero-Click Flaw Leaks Gmail Data via OpenAI ChatGPT Deep Research Agent

本文为 独立观点,未经授权禁止转载。

如需授权、对文章有疑问或需删除稿件,请联系 FreeBuf

客服小蜜蜂(微信:freebee1024)