微软研究院日前推出了轻量级人工智能模型 Microsoft Phi 的第三个迭代版本,新版本也就是 Phi-3 分成 3.8B、7B 和 14B 参数版本,名称分别是 Mini、Small 和 Medium。

与其他人工智能模型不同的是,Phi 系列模型的侧重点是轻量级,其使用的资源要比同等规模的人工智能模型少得多,因此可以在智能手机等设备上本地运行。

根据微软自己的基准测试,仅有 3.8B 参数的 Phi-3 Mini 版在性能上表现优于 Meta 8B 参数的 Llama 和 OPENAI 3.5B 参数的 GPT-3。

微软研究院在论文中表示:

我们引入了 phi-3-mini,这是一个在 3.3 万亿个 tokens 上训练的 3.8B 参数人工智能模型,从学术基准和内部测试来看,其整体性能可与 Mixtral 8x7B 和 OPENAI GPT-3.5 等模型媲美。

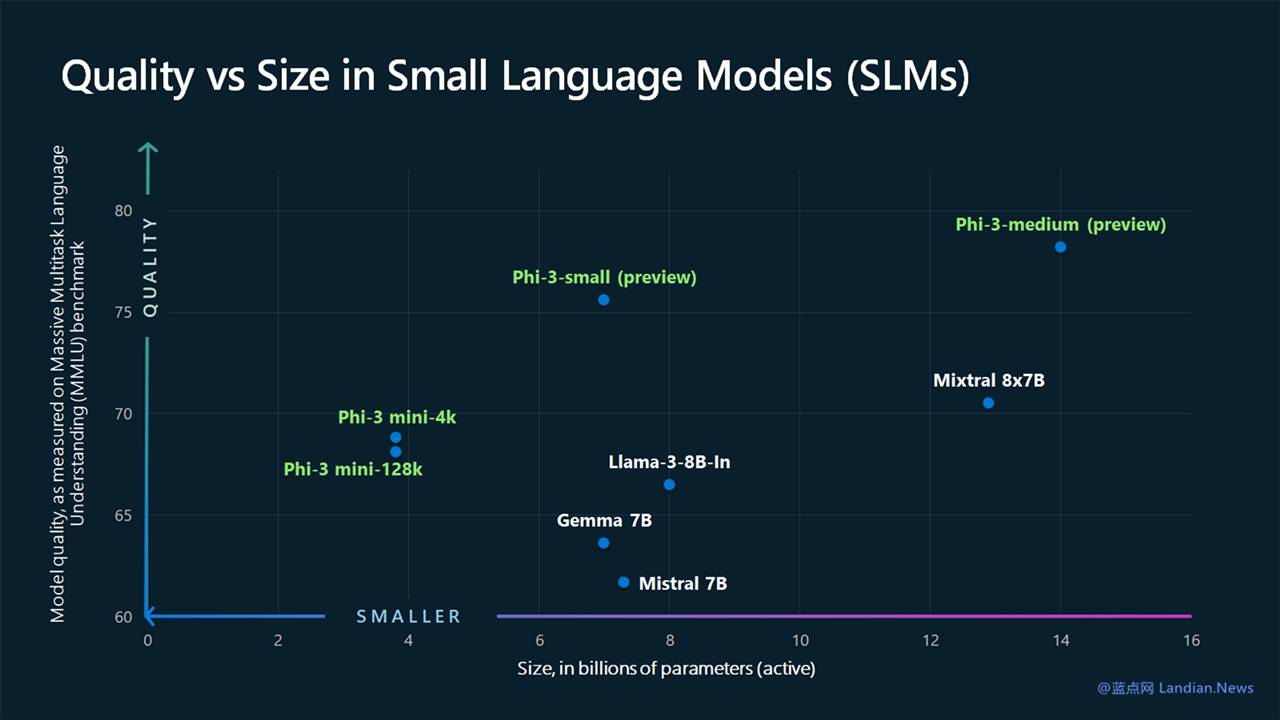

例如 phi-3-mini 在 MMLU 测试中达到了 69%,在 MT-bench 上达到了 8.38,最重要的是这个模型足够小,可以直接部署在手机上。

我们还提供了一些针对 4.8 万亿个 tokens 训练的 7B 和 14B 模型的初始参数缩放结果,即 phi-3-small 和 phi-3-medium,这两个版本能力都要比 Mini 版更好。

其中 Small 版的 MMLU 为 75%、MT-bench 为 8.7;Medium 版 MMLU 为 78%、MT-bench 为 8.9。

微软对 Phi-3 系列模型进行了优化,在低功耗设备上例如智能手机和平板电脑上也可以运行,并且在实际使用过程中不会消耗太多的资源。

这意味着新模型能够直接在智能手机上进行高级自然语言处理而不需要实时联网进行计算,因此 Phi-3 Mini 等模型非常适合集成到一些需要人工智能参与的新颖应用中。

当然微软也强调 Phi-3 模型的训练数据集有限,它无法与互联网上训练的大规模 AI 模型的知识广度相匹配,但微软也指出较小的高质量模型往往表现更好。

论文地址:https://arxiv.org/abs/2404.14219

版权声明:感谢您的阅读,除非文中已注明来源网站名称或链接,否则均为蓝点网原创内容。转载时请务必注明:来源于蓝点网、标注作者及本文完整链接,谢谢理解。