Tra i temi più discussi nel cercare di rendere l’uso dell’intelligenza artificiale più conforme possibile alla normativa e al rispetto dei diritti fondamentali, si discorre da tempo delle tecniche per garantire una maggior privacy dei dati utilizzati: una di questa tecniche è quella della c.d. “privacy differenziale”, già nota da tempo ma rilanciata recentemente negli USA.

Lo slancio deriva dalla pubblicazione in bozza delle inedite linee guida del NIST (National Institute of Standards and Technology) statunitense su questo tipo di strumento (documento NIST SP 800-226, ora in consultazione pubblica). La pubblicazione risponde a una richiesta diretta del presidente USA Biden, contenuta nell’Executive Order on Safe, Secure, and Trustworthy Artificial Intelligence pubblicato il 30 ottobre scorso.

Il modo in cui il NIST lo affronta in questo documento è senza precedenti per l’ente: la pubblicazione non si limita a spiegare i meccanismi di base, si addentra nei dettagli sottili e nelle complessità di queste tecniche. Offre una visione panoramica che va oltre la teoria, entrando nel regno pratico dell’applicazione e dell’implementazione.

Privacy differenziale tra le PET

Rientrando la privacy differenziale tra le c.d. PET (acronimo di Privacy Enhancing Technologies), giova ricordare che si tratta di una serie di strumenti e metodi progettati per proteggere la privacy degli utenti nel mondo digitale – nella tassonomia del GDPR europeo, le PET si trovano a un crocevia tra privacy by default e by design, relativa minimizzazione nell’uso dei dati personali e misure di sicurezza. Le PET hanno l’obiettivo, appunto, di minimizzare l’esposizione dei dati personali identificabili, aumentando la protezione degli individui contro la sorveglianza e l’uso improprio delle loro informazioni.

Nuova Direttiva Whistleblowing: la guida a obblighi, tutele e sanzioni

Ciò viene realizzato attraverso vari approcci e strumenti, la privacy differenziale è indicata nel documento del NIST quale tecnologia PET “che quantifica il rischio per la privacy degli individui quando i loro dati appaiono in un dataset”.

Non è, si badi, materia nuova: il concetto di privacy differenziale è stato introdotto per la prima volta da Cynthia Dwork, Frank McSherry, Kobbi Nissim e Adam Smith in un lavoro presentato alla conferenza TCC (Theory of Cryptography Conference) del 2006, intitolato “Calibrating Noise to Sensitivity in Private Data Analysis”.

In breve, detta altrimenti: la privacy differenziale è un approccio alla protezione dei dati che permette di trarre conclusioni utili da un insieme di dati, garantendo al contempo che le informazioni su un singolo individuo rimangano celate. In pratica, si tratta di aggiungere in vari modi un livello di incertezza (“rumore”, in molti casi, ma sono possibili altre tecniche) ai dati, in modo che – pur mantenendo questi, al contempo, un certo grado di utilità complessiva (obiettivo in contrapposizione a quello di riservatezza) – sia impossibile risalire alle informazioni di una persona identificata o identificabile.

Il motivo per cui la privacy differenziale è così potenzialmente preziosa – e perché è stata caldeggiata dal governo USA – è che offre una soluzione equilibrata tra l’accesso e l’analisi dei dati e la protezione della privacy degli interessati, in un’epoca in cui la data analytics è onnipresente così come i rischi a essa inerenti. Non si tratta, dunque, di un singolo algoritmo o metodo matematico, bensì di più possibili strumenti matematici differenti e applicabili per arrivare a un risultato come quello descritto e auspicato. Va da sé che non esiste, al momento, un metodo migliore di tutti gli altri, molti fattori e parametri sono da valutare nel concreto e servono, tra l’altro, esperti statistici.

Difatti, la privacy differenziale è in fase di transizione dalla teoria all’applicazione pratica, e sebbene esistano sistemi funzionanti, l’ecosistema software è ancora in uno stadio iniziale. Questo rende complessa l’implementazione per chi non è specializzato: nuovi strumenti software sono stati sviluppati per facilitare l’adozione della privacy differenziale, ma è essenziale – secondo il NIST – che gli utenti comprendano come le proprietà matematiche si traducano in applicazioni pratiche, un processo che non sempre è lineare.

Alla pubblicazione del documento è peraltro abbinata una repository di software dedicata all’implementazione della privacy differenziale. Ciò anche perché la pubblicazione rappresenta un passo iniziale verso l’elaborazione di standard per la privacy differenziale, al fine di garantire che il suo impiego offra una protezione davvero efficace della privacy nel mondo reale. Includendo impostazioni dei parametri o soluzioni per i rischi descritti nel documento stesso.

Questo standard permetterebbe la creazione di strumenti per valutare e certificare i sistemi che rispettano tali garanzie.

La certificazione è cruciale per aiutare i non esperti a comprendere se un sistema offre garanzie affidabili di privacy, senza che se ne debbano approfondire i dettagli tecnici.

Privacy differenziale: linee guida del NIST in dettaglio

Il documento del NIST, piuttosto tecnico, si suddivide in tre parti diverse, vediamole sommariamente:

- Parte I – “Garanzie della Privacy Differenziale“: si assicura che l’inclusione o meno dei dati “personali” non influenzi significativamente i risultati di un’analisi dei dati. In altre parole, i rischi per la privacy dovrebbero essere gli stessi, che si utilizzino dati personali o non personali. Questa sezione introduce la privacy differenziale, ne descrive le caratteristiche principali e mostra come può influenzare i risultati nel mondo reale, evidenziando i potenziali pericoli nella sua valutazione e definizione.

- Parte II – “Algoritmi per la Privacy Differenziale”: la privacy differenziale si ottiene generalmente aggiungendo rumore casuale ai risultati delle analisi. Più rumore significa maggiore privacy ma anche una riduzione nell’utilità dei risultati, creando una tensione privacy-utilità che può essere difficile da bilanciare. Inoltre, alcune tecniche possono introdurre o aumentare bias sistematici, umani o statistici nei risultati, quindi, è importante comprendere e mitigare questi effetti. Questa sezione descrive più algoritmi per vari scenari di elaborazione dati, inclusi query analitici, regressioni, machine learning, generazione di dati sintetici e analisi di dati non strutturati. Implementare questi algoritmi richiede competenze specialistiche e può essere complesso, quindi, si incoraggia l’uso di librerie preesistenti, quando possibile.

- Parte III – “Deploying della Privacy Differenziale“: questa tecnologia protegge la privacy quando i dati vengono pubblicati o comunque comunicati, ma non durante la raccolta, l’archiviazione o l’analisi dei dati stessi. Questa sezione descrive problemi pratici, come il modello di minaccia che deve distinguere tra soggetti affidabili e malintenzionati nell’analisi dei rischi, le sfide nell’implementazione che possono portare a fallimenti imprevisti, rischi aggiuntivi sulla sicurezza e l’esposizione dei dati. Per esempio, i dati particolari devono essere conservati seguendo le migliori pratiche in termini di sicurezza e politiche di controllo degli accessi, o meglio ancora, non essere affatto memorizzati – un data breach che rivelasse dati grezzi particolari annullerebbe completamente qualsiasi garanzia di privacy differenziale stabilita per quel dataset.

Nel documento NIST ciò viene schematizzato in questo diagramma “a strati”, suddiviso in sezioni come presentate nel testo:

Un uso consapevole della privacy differenziale: matematica e rischi identificativi

La privacy differenziale, in buona sostanza, è un approccio matematico per mantenere la privacy quando si forniscono dati per un’analisi. Essenzialmente, stabilisce che la probabilità di ogni possibile risultato dell’analisi dovrebbe essere simile, indipendentemente dal fatto che i dati identificati o identificabili siano inclusi o meno. Questo include risultati che potrebbero recare rischi per la privacy, come la re-identificazione.

Un importante aspetto della privacy differenziale è che non impedisce di fare inferenze su un individuo, ma protegge contro la re-identificazione diretta. Sebbene le statistiche differenziate possano rivelare informazioni generali, non permettono di fare inferenze precise su un individuo specifico.

Le proprietà fondamentali della privacy differenziale includono:

- l’eliminazione della necessità di distinguere tra dati identificativi e non identificativi, considerando tutte le informazioni come potenzialmente identificative;

- la resistenza agli attacchi privacy, essendo efficace contro gli attacchi di privacy che utilizzano dati ausiliari, proteggendo così dai comuni attacchi di collegamento su dati de-identificati;

- la possibilità di valutare e limitare il danno complessivo alla privacy derivante da molteplici rilasci di dati nel tempo.

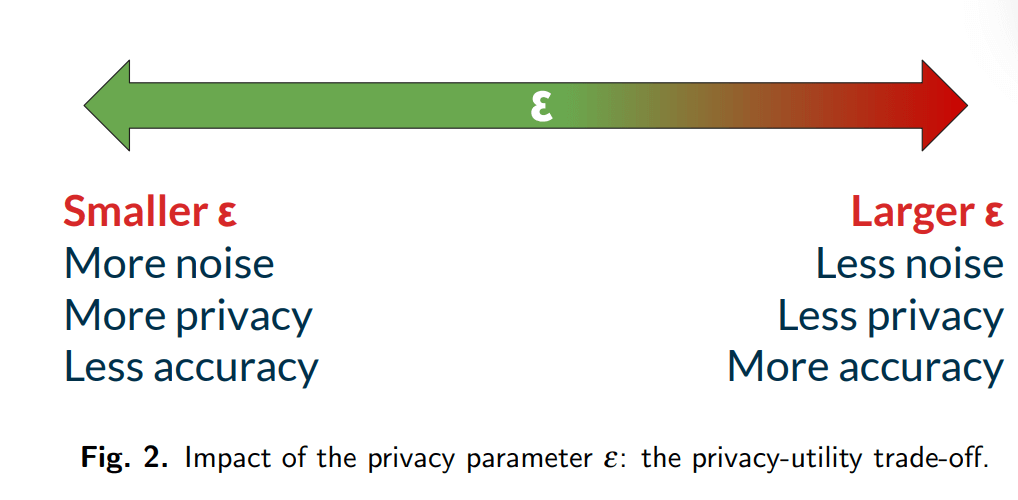

Parlando di matematica applicata al metodo, il c.d. parametro ε nella privacy differenziale è fondamentale per bilanciare privacy e accuratezza. Un ε piccolo significa una maggiore privacy, poiché rende i risultati dell’analisi meno dipendenti dai dati specifici di un interessato, ma ciò può ridurre l’accuratezza dei dati. Al contrario, un ε più grande offre una privacy meno forte, ma migliora l’accuratezza dei risultati.

Quando si analizzano più volte gli stessi dati, il valore di ε funziona come un c.d. “budget privacy” che limita la perdita totale di privacy per tutte le analisi. La scelta di un valore adeguato di ε è cruciale e ancora oggetto di ricerca, poiché l’efficacia della privacy differenziale nel proteggere i dati varia in base al contesto e alla grandezza di ε.

Altrettanto importante è la c.d. “unit of the privacy”: nella privacy differenziale si riferisce a come definiamo ciò che è protetto in un’analisi dei dati. Ovvero, in pratica si considera che due insiemi di dati risultano “vicini” se differiscono solo per le informazioni afferenti a una persona. Questa definizione è cruciale perché determina esattamente cosa la privacy differenziale sta proteggendo ed è importante perché stabilisce il livello di protezione offerto quando si analizzano i dati. In molti casi, è più rilevante per garantire una privacy effettiva rispetto al parametro ε.

Una variante specifica di privacy differenziale introduce un ulteriore parametro δ. Questo permette di considerare eccezioni alla privacy per eventi molto rari, ma può portare a fallimenti gravi nella protezione della privacy se δ non è impostato correttamente. Per evitare questo rischio, il valore di δ deve essere molto piccolo, rendendo così improbabili questi “fallimenti catastrofici”.

Nella privacy differenziale, si usano due meccanismi principali per proteggere i dati: il meccanismo di Laplace e il meccanismo gaussiano. Entrambi aggiungono rumore ai risultati di una ricerca per mantenere la privacy. Il meccanismo di Laplace usa un tipo di rumore che è efficace per proteggere dati meno complessi e garantisce un alto livello di privacy. Il meccanismo gaussiano, invece, è più adatto per dati complessi o dettagliati e offre una buona protezione con più flessibilità. La scelta tra i due dipende da quanto sono complessi i dati che si stanno analizzando e dal livello di privacy che si vuole raggiungere.

Machine learning e privacy differenziale

Le tecniche di machine learning – per es. come quelle usate nel deep learning – sono popolari per analizzare dati complessi come quelli relativi a visione e linguaggio. Iniziano con un modello dotato di parametri che possono essere addestrati e durante tale addestramento i parametri vengono regolati per migliorare la capacità del modello di svolgere un compito, come riconoscere immagini specifiche.

Tuttavia, il machine learning presenta rischi per la privacy. Le reti neurali, in particolare, possono memorizzare dati di addestramento, rendendoli vulnerabili ad attacchi che rivelano informazioni su questi dati. Questo è un problema serio per modelli addestrati con dati particolari, come quelli medici.

Per difendersi dagli attacchi alla privacy, si sta studiando come addestrare modelli con privacy differenziale. Una tecnica comune è la c.d. discesa stocastica del gradiente con privacy differenziale (DP-SGD). Tuttavia, aggiungere la privacy differenziale nel processo di addestramento di solito riduce l’accuratezza del modello, a volte significativamente.

I modelli semplici sono più facili da addestrare con privacy rispetto ai modelli complessi, e dataset di addestramento più grandi di solito portano a modelli più accurati. Con dati sufficienti, i metodi di machine learning con privacy differenziale possono avvicinarsi all’accuratezza di quelli non rispettosi della privacy, ma è spesso necessaria una grande quantità di dati.

In sintesi, secondo il NIST le tecniche attuali per il machine learning con privacy differenziale sono più efficaci per modelli semplici oppure per dataset di addestramento molto grandi.

Dati sintetici e privacy differenziale

I dataset sintetici possono essere creati usando algoritmi di privacy differenziale, per generare dati che assomigliano a quelli originali, pur consistendo in informazioni inventate. Questi dati sono facili da usare poiché mantengono la struttura del dataset originale, come schemi e correlazioni, ma non contengono dati personali reali su individui reali.

La creazione di dati sintetici presenta tuttavia alcuni rischi per la privacy, specialmente se non si utilizza una PET come la privacy differenziale. Tecniche non basate sulla privacy differenziale possono sembrare altrettanto sicure ma non proteggere efficacemente contro tutti i tipi di attacchi alla privacy. Al contrario, i dati sintetici generati con privacy differenziale possono prevenire questi attacchi.

Ci sono due modi principali per creare dati sintetici in tal modo:

- utilizzo di distribuzioni marginali: questo metodo implica la creazione di un istogramma, che è essenzialmente un grafico che mostra la frequenza di varie categorie di dati. A questo istogramma viene poi aggiunto un tipo speciale di rumore (disturbo casuale), per assicurare che i dati personali finali siano protetti dalla privacy differenziale. Questo significa che, pur mantenendo le tendenze generali dei dati originali, i dettagli specifici su singoli interessati vengono mascherati.

- deep learning: questo approccio utilizza tecniche di apprendimento automatico avanzate, come le reti neurali, per generare dati sintetici. Tuttavia, per assicurare che i dati generati rispettino la privacy, è necessario addestrare queste reti con tecniche speciali che incorporano la privacy differenziale, come la citata discesa stocastica del gradiente con privacy differenziale (DP-SGD). Questo processo assicura che i dati generati dalla rete neurale non rivelino informazioni personali sui dati di partenza.

In entrambi i casi, l’obiettivo è creare un set di dati che sembri realistico e che possa essere utilizzato per analisi o test, senza però compromettere la privacy delle persone i cui dati sono stati utilizzati per creare il set originale. I dati sintetici generati con metodi basati sulla distribuzione marginale sono attualmente più utili per dati tabulari a bassa dimensionalità.

Al contrario, gli approcci basati sul deep learning spesso non mantengono le proprietà statistiche dei dati originali e possono essere meno efficaci per la creazione di dati sintetici.

Rischi privacy e minacce

I modelli di minaccia per gli attacchi nella privacy differenziale descrivono le assunzioni su quanto siano affidabili i componenti di un sistema. In pratica, determinano chi è considerato “fidato” e chi “non fidato” quando accedono a dati personali.

Un soggetto fidato manterrà i dati al sicuro e non li rivelerà ad altri, mentre un soggetto non fidato potrebbe non proteggere adeguatamente i dati oppure potrebbe divulgarli senza autorizzazione.

I modelli di minaccia per la privacy differenziale di solito considerano tre tipi di parti:

- interessati: persone a cui si riferiscono i dati;

- curatore di dati: chi raccoglie e aggrega i dati;

- consumatore di dati: chi riceve i risultati protetti dalla privacy differenziale.

Spesso, il gruppo dei consumatori dei dati è molto ampio, come nel caso di risultati diffusi al pubblico. Altre volte, i risultati vengono rivelati solo a un gruppo ristretto. Le differenze nei modelli di minaccia risiedono nelle assunzioni di fiducia verso curatori e consumatori.

In generale, i modelli di minaccia che richiedono meno parti fidate sono più robusti ma spesso comportano compromessi in termini di altre caratteristiche desiderabili: è importante che le presunzioni di fiducia di un modello di minaccia corrispondano il più possibile alla realtà.

Valutare la fiducia nel mondo reale può essere complesso e difficile da definire precisamente in un modello di minaccia. In alcuni casi, una garanzia di privacy differenziale che richiede la fiducia in un curatore può essere preferibile a nessuna garanzia, anche se gli interessati potrebbero non fidarsi completamente del curatore.

Non tutti sanno che…

Il documento del NIST mette in luce alcuni aspetti “sorprendenti” sulla privacy differenziale, anche per i tecnici, in merito:

- spesso si pensa che la scelta dei parametri nella privacy differenziale sia relativamente semplice; tuttavia, il documento evidenzia che la scelta – come il livello di rumore o l’assetto delle variabili – è un processo complesso che richiede un’attenta valutazione delle esigenze specifiche del contesto di utilizzo;

- è spesso vista come una soluzione universale per la protezione della privacy nei dati ma, in realtà, non protegge contro tutti i tipi di rischi per la privacy, in particolare non impedisce l’inferenza di informazioni da dati correlati;

- si evidenziano specifiche sfide nell’uso della privacy differenziale in sistemi di intelligenza artificiale, come la gestione della composizione di più query e l’adattamento ai cambiamenti nei dataset;

- come notato, esiste un compromesso da dover raggiungere tra privacy e utilità: il documento approfondisce come questo compromesso sia particolarmente critico e come sia difficile bilanciarlo in modo efficace, soprattutto in contesti dinamici e complessi;

- un aspetto spesso sottovalutato è la gestione degli aggiornamenti dei dataset in ambienti dinamici, disattesa a scapito della capacità tutelante dello strumento differenziale.

Questi punti mettono in luce la complessità e la necessità di un approccio ad hoc nell’implementazione della privacy differenziale, mostrando che non è una soluzione “taglia unica”, bensì richiede una considerazione dettagliata del contesto specifico e, dunque, che non esistono “soluzioni chiavi in mano” buone per tutti.

Analisi dei rischi per la privacy differenziale

Nel documento NIST si elencano rischi che i processi in esame possono portare e che, pertanto, vanno attentamente vagliati caso per caso:

- rischi privacy: i rischi per la privacy possono variare a seconda del contesto e devono essere valutati attentamente. Per esempio, la combinazione di dati da fonti multiple può aumentare il rischio di rivelare informazioni personali;

- rischi per l’utilità: l’aggiunta di rumore per proteggere la privacy può ridurre l’utilità dei dati. L’equilibrio tra privacy e utilità è un aspetto fondamentale nella progettazione di sistemi che utilizzano la privacy differenziale;

- compromessi tra privacy e utilità: la privacy differenziale richiede un compromesso tra la protezione della privacy e l’utilità dei dati. Aggiungere troppo rumore può rendere i dati inutili, mentre troppo poco può compromettere la privacy;

- adattabilità ed evoluzione delle minacce: le minacce alla privacy evolvono nel tempo, quindi i meccanismi di privacy differenziale devono essere adattabili e aggiornati per rimanere efficaci contro nuove vulnerabilità e tattiche degli avversari;

- sfide nell’implementazione: l’implementazione della privacy differenziale presenta sfide tecniche, come la gestione della composizione di più query e la scelta dei meccanismi di aggiunta di rumore appropriati.

L’applicazione della privacy differenziale nell’ambito dell’intelligenza artificiale (AI) – proprio ciò a cui si riferiva l’atto governativo del Presidente USA – declina i rischi appena visti in maniera da richiedere valutazioni specifiche caso per caso.

In particolare, nell’AI i dati di addestramento sono cruciali per sviluppare modelli accurati.

La privacy differenziale può essere applicata per proteggere la privacy degli individui nei dataset di addestramento, riducendo il rischio che informazioni sensibili vengano rivelate.

Così come la privacy differenziale deve essere gestita in modo da mantenere la protezione anche quando i dati vengono aggiornati o cambiati. E non si dimentichi che implementare la privacy differenziale in sistemi AI è spesso più complesso, a causa della natura dei modelli e dell’algoritmo di addestramento.

In sintesi, l’applicazione della privacy differenziale in AI richiede un approccio multidisciplinare e ben calibrato sul caso concreto.

Conclusioni

In conclusione, il documento NIST SP 800-226 fornisce una panoramica dettagliata e approfondita sulle sfide e le opportunità presentate dalla privacy differenziale. Questa pubblicazione non solo evidenzia l’importanza di bilanciare accuratamente i parametri e di considerare con attenzione i modelli di minaccia, altresì sottolinea il ruolo cruciale della sicurezza dei dati e del controllo degli accessi nel mantenimento dell’integrità della privacy differenziale.

Le direttive del NIST trovano una risonanza particolare con le ansie e le preoccupazioni dell’Unione Europea.

Le preoccupazioni dell’UE sull’utilizzo dell’IA e la raccolta di dati riflettono un tema comune con le raccomandazioni del NIST: la necessità di un approccio olistico e attento alla privacy e alla sicurezza dei dati.

La convergenza delle prospettive del NIST e dell’UE sull’importanza della protezione dei dati personali evidenzia una tendenza globale, verso una maggiore consapevolezza della necessità del garantire la privacy nell’uso dei dati.

La cooperazione e il dialogo tra organizzazioni come il NIST e le autorità dell’UE potrebbero fornire un quadro per affrontare queste sfide comuni, promuovendo standard e pratiche che beneficiano di una più ampia comunità globale interessata alla salvaguardia della privacy nell’era digitale.

D’altronde, il tema dell’intelligenza artificiale sarà affrontato con tanta minor efficacia quanto meno saranno condivise le modalità di sua ammissibilità e utilizzo.

Vedremo se la privacy differenziale potrà davvero costituire uno strumento chiave in tal senso.

Abilitazione al cloud: migrazione, gestione delle applicazioni e sicurezza. Rendi più potente l'IT

@RIPRODUZIONE RISERVATA