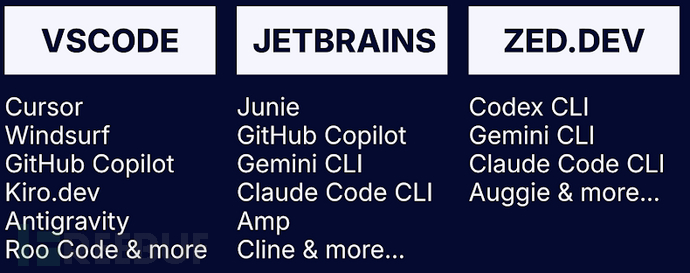

研究人员在各类AI驱动的集成开发环境(IDE)中发现了30多个安全漏洞,攻击者可将提示注入(prompt injection)原语与合法功能结合,实现数据外泄和远程代码执行(RCE)。安全研究员Ari Marzouk(MaccariTA)将这些安全缺陷统称为IDEsaster,涉及Cursor、Windsurf、Kiro.dev、GitHub Copilot、Zed.dev、Roo Code、Junie和Cline等主流IDE及扩展组件,其中24个漏洞已分配CVE编号。

"最令人惊讶的发现是,每个受测AI IDE都受到多种通用攻击链影响,"Marzouk向The Hacker News表示,"所有AI IDE(及其集成的编程助手)实际上都在威胁模型中忽略了基础软件(IDE)。它们认为这些功能本质安全,因为它们已存在多年。但一旦引入能自主行动的AI Agent,这些功能就可能被武器化为数据外泄和RCE原语。"

漏洞利用机制剖析

这些漏洞本质上串联了AI驱动IDE常见的三种攻击向量:

- 绕过大语言模型(LLM)防护机制,劫持上下文执行攻击者指令(即提示注入)

- 通过AI Agent自动批准的工具调用,无需用户交互即可执行特定操作

- 触发IDE的合法功能,使攻击者突破安全边界泄露敏感数据或执行任意命令

与以往利用提示注入结合漏洞工具(或滥用合法工具执行读写操作)的攻击链不同,IDEsaster的特殊性在于:它将提示注入原语与Agent工具结合,激活IDE的合法功能导致信息泄露或命令执行。

多样化攻击手法

上下文劫持可通过多种方式实现,包括:

- 用户添加的上下文引用(如含隐藏字符的URL或文本,人眼不可见但能被LLM解析)

- 通过工具投毒或"抽地毯"(rug pulls)污染模型上下文协议(MCP)服务器

- 合法MCP服务器解析来自外部源的攻击者控制输入

新攻击链可实现的具体攻击包括:

(CVE-2025-49150)Cursor、(CVE-2025-53097)Roo Code、(CVE-2025-58335)JetBrains Junie、GitHub Copilot(无CVE)、Kiro.dev(无CVE)和Claude Code(已发布安全警告)

通过提示注入使用合法工具("read_file")或漏洞工具("search_files"/"search_project")读取敏感文件,再通过合法工具("write_file"/"edit_file")写入JSON文件,其中包含攻击者控制域名的远程JSON模式,导致IDE发起GET请求时数据泄露(CVE-2025-53773)GitHub Copilot、(CVE-2025-54130)Cursor、(CVE-2025-53536)Roo Code、(CVE-2025-55012)Zed.dev和Claude Code(已发布安全警告)

通过提示注入编辑IDE设置文件(".vscode/settings.json"或".idea/workspace.xml"),将"php.validate.executablePath"或"PATH_TO_GIT"设置为含恶意代码的可执行文件路径实现代码执行(CVE-2025-64660)GitHub Copilot、(CVE-2025-61590)Cursor和(CVE-2025-58372)Roo Code

通过提示注入编辑工作区配置文件(*.code-workspace),覆盖多根工作区设置实现代码执行

值得注意的是,后两种攻击需AI Agent配置为自动批准文件写入,使攻击者能通过影响提示词写入恶意工作区设置。由于该行为默认自动批准工作区内文件修改,可实现无需用户交互或重新打开工作区的任意代码执行。

安全防护建议

鉴于提示注入和越狱是攻击链的首要环节,Marzouk提出以下建议:

- 仅限可信项目使用AI IDE:恶意规则文件、源代码中隐藏的指令(如README)、甚至文件名都可能成为提示注入载体

- 严格管控MCP服务器连接:仅连接可信MCP服务器并持续监控变更(即使可信服务器也可能被入侵),审查MCP工具数据流(合法MCP工具可能从攻击者控制的GitHub PR等源拉取信息)

- 人工审查外部资源:对通过URL等方式添加的资源检查隐藏指令(HTML注释/css隐藏文本/不可见Unicode字符等)

相关漏洞扩展分析

此次披露恰逢多个AI编程工具漏洞被发现,可能产生广泛影响:

- OpenAI Codex CLI命令注入漏洞(CVE-2025-61260):程序隐式信任通过MCP服务器条目配置的命令,未经用户许可即在启动时执行。攻击者篡改仓库".env"和"./.codex/config.toml"文件可导致任意命令执行

- Google Antigravity间接提示注入:通过投毒网页源操纵Gemini从用户IDE收集凭据和敏感代码,利用浏览器子代理浏览恶意网站外泄信息

- Google Antigravity多漏洞:可通过间接提示注入实现数据外泄和远程命令执行,或利用恶意受信工作区嵌入持久后门,在应用每次启动时执行任意代码

- PromptPwnd新型漏洞:针对连接漏洞GitHub Actions(或GitLab CI/CD管道)的AI Agent,通过提示注入诱骗其执行内置特权工具导致信息泄露或代码执行

企业安全新挑战

随着Agentic AI工具在企业环境日益普及,这些发现表明AI工具如何通过LLM无法区分用户任务指令与外部源恶意内容,扩大开发设备的攻击面。Aikido研究员Rein Daelman指出:"任何使用AI进行问题分类、PR标记、代码建议或自动回复的仓库都面临提示注入、命令注入、密钥外泄、仓库入侵和上游供应链攻击风险。"

Marzouk强调这些发现凸显了"AI安全设计"(Secure for AI)原则的重要性——该新范式要求产品不仅默认安全、设计安全,还需考虑AI组件随时间推移可能被滥用的方式。"这是需要'AI安全设计'原则的又一例证,"Marzouk表示,"将AI Agent连接到现有应用(如IDE或GitHub Actions)会产生新的风险。"

参考来源:

Researchers Uncover 30+ Flaws in AI Coding Tools Enabling Data Theft and RCE Attacks

本文为 独立观点,未经授权禁止转载。

如需授权、对文章有疑问或需删除稿件,请联系 FreeBuf

客服小蜜蜂(微信:freebee1024)