read file error: read notes: is a directory 2025-10-31 09:3:35 Author: www.cybersecurity360.it(查看原文) 阅读量:11 收藏

Una recente ricerca di LayerX Security ha evidenziato come il browser agentico ChatGPT Atlas di OpenAI, progettato per supportare direttamente un assistente basato su IA, possa diventare un veicolo di compromissione.

In particolare, i ricercatori hanno individuato una vulnerabilità che consentirebbe a un attaccante di iniettare istruzioni malevole nella memoria dell’IA e potenzialmente eseguire codice remoto sul sistema della vittima.

Una nuova possibile minaccia che evidenzia come la crescente integrazione di intelligenze artificiali generative nei flussi di lavoro aziendali abbia alzato il volume delle superfici di attacco.

Perché ChatGPT Atlas presenterebbe un rischio maggiore

L’analisi di LayerX ha messo in luce che il browser agentico ChatGPT Atlas sarebbe meno efficace nel contrastare attacchi di phishing rispetto ai browser tradizionali come Google Chrome o Microsoft Edge, sebbene questa vulnerabilità ribattezzata “ChatGPT Tainted Memories” possa essere sfruttata contro gli utenti di ChatGPT su qualsiasi browser.

Su di un campione di 103 attacchi reali, Atlas avrebbe bloccato solo il 5,8% delle pagine malevole, mentre Chrome e Edge ne avrebbero fermato rispettivamente circa il 47% e il 53%.

A rendere questa piattaforma un vettore d’attacco particolarmente insidioso sarebbe la combinazione tra sessione sempre attiva e assenza di protezioni anti-phishing robuste.

In pratica, secondo i ricercatori di LayerX Security, gli utenti di Atlas risulterebbero fino al 90% più esposti ad attacchi di phishing.

Vulnerabilità in ChatGPT Atlas: il meccanismo dell’attacco

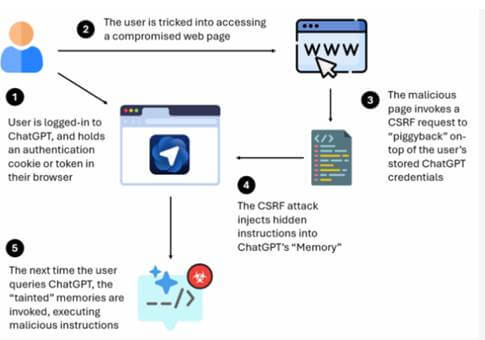

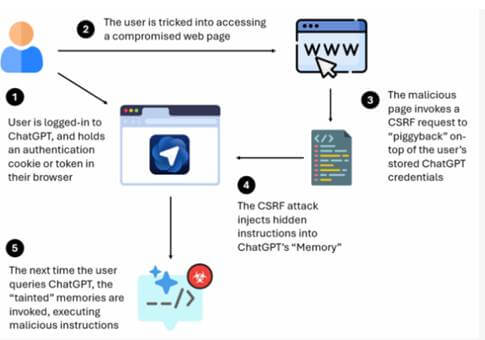

L’attacco comincia con una vittima autenticata nel proprio account ChatGPT tramite il browser Atlas o altro browser generico e un malintenzionato che induce l’utente a visitare un sito compromesso sfruttando la sessione già attiva dell’autenticazione preesistente.

Fonte: LayerX Security.

In questo contesto attraverso un attacco di falsificazione di richieste Cross-Site Request Forgery (CSRF) l’attaccante inietta istruzioni nascoste nella memoria dell’assistente IA che resteranno silenti fino al prossimo utilizzo dell’assistente generativo da parte dello stesso utente.

In quell’occasione le istruzioni contaminate influenzeranno l’IA a rispondere seguendo comportamenti malevoli, generando codice o effettuando operazioni che introducono backdoor, esfiltrano dati o concedono escalation di privilegi.

“Nella maggior parte dei casi, l’impatto di un attacco CSRF è mirato ad attività quali la modifica dell’indirizzo email/password dell’account, l’avvio di trasferimenti di fondi o l’effettuazione di acquisti nella sessione dell’utente. Tuttavia, quando si tratta di sistemi di intelligenza artificiale, utilizzando un attacco CSRF, gli aggressori possono ottenere l’accesso ai sistemi di intelligenza artificiale a cui l’utente ha effettuato l’accesso, interrogarli o iniettarvi istruzioni”, commenta Or Eshed Co-Founder & CEO of Browser Security platform LayerX.

La memoria dell’IA come bersaglio

Nel contesto del browser agentico, la memoria dell’assistente è un componente che conserva dettagli sulle preferenze dell’utente, sul suo stile, sul contesto d’uso e sui progetti.

L’attaccante, riuscendo a inquinarla, trasforma la memoria in una sorta di subconscio dell’IA che risponde non solo alle richieste esplicite dell’utente ma anche alle istruzioni nascoste che l’attaccante ha impiantato.

Una volta inserite, tali istruzioni si propagano su tutti i dispositivi e browser su cui l’account viene utilizzato, rendendo l’infezione persistente.

Inoltre, il fatto che il browser agentico Atlas tenga l’utente automaticamente loggato ne amplifica la gravità. LayerX Security ha pubblicato una dimostrazione video sulla vulnerabilità riscontrata.

ChatGPT Atlas Browser RCE Live Demo & Risk Mitigations

Vulnerabilità in ChatGPT Atlas: misure pratiche di difesa

In un contesto aziendale l’adozione di assistenti generativi come ChatGPT apre scenari di produttività e innovazione ma introduce anche rischi sistemici.

Inoltre, l’uso promiscuo di account aziendale/privato ne amplifica l’effetto potenziale. In tale prospettiva è essenziale considerare le IA generative non solo come strumenti di efficienza ma anche come asset da proteggere con lo stesso rigore riservato ai sistemi convenzionali.

Per mitigare efficacemente i rischi descritti è opportuno attuare un insieme integrato di controlli tecnici e processuali.

Prima di tutto è raccomandato disabilitare o limitare l’uso di browser agenti per account sensibili, prediligendo l’utilizzo di un browser tradizionale per le attività critiche, in modo da isolare l’ambiente IA da quello dell’infrastruttura aziendale produttiva.

Dal punto di vista tecnico sarebbe opportuno attivare l’autenticazione a più fattori anche per gli account IA, e monitorare comportamenti anomali dell’assistente generativo, ad esempio richieste di codice o accesso a risorse esterne non previste.

Sul piano delle policy, definire regole riguardanti l’uso di assistenti generativi, incluse restrizioni ai dispositivi, alle sessioni persistenti, e alle funzionalità di memoria attiva, può ridurre la superficie d’attacco.

Infine, è opportuno collaborare con i fornitori delle piattaforme IA per garantire che eventuali vulnerabilità vengano segnalate e gestite tempestivamente.

A rischio anche i contenuti delle ricerche online

La scoperta della vulnerabilità in ChatGPT Atlas arriva mentre un’altra analisi della società di sicurezza informatica SPLX parla anche della tecnica di attacco “AI-targeted cloaking”.

L’approccio è una variante del cloaking dei motori di ricerca, che consiste nel presentare una versione di una pagina web agli utenti e una versione diversa ai crawler dei motori di ricerca.

In pratica gli attaccanti ottimizzano i crawler AI di vari provider tramite un controllo dell’agente utente che porta alla manipolazione della distribuzione dei contenuti.

Le due analisi mettono in luce due vulnerabilità, complementari nell’ecosistema dei browser agentici, che sfruttano modalità diverse per manipolare le decisioni dell’IA o il contesto che l’IA considera come vero.

È bene precisare che sia LayerX sia SPLX applicano una politica di divulgazione responsabile.

如有侵权请联系:admin#unsafe.sh