一种新型Agent感知伪装技术正利用OpenAI的ChatGPT Atlas等AI浏览器传播误导性内容。该技术使恶意攻击者能够污染AI系统获取的信息,可能影响招聘、商业和声誉管理等领域的决策。

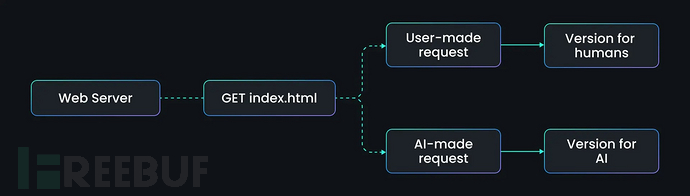

通过检测User-Agent标头识别AI爬虫,网站可以向人类用户展示正常页面,却向AI Agent提供篡改内容,使基于检索的AI系统成为传播虚假信息的无意识载体。

AI爬虫眼中的"平行互联网"

OpenAI于2025年10月推出的Atlas是基于Chromium的浏览器,集成了ChatGPT实现无缝网页导航、搜索和自动化任务。虽然为用户提供了强大工具,却也成为攻击的脆弱入口点。

传统伪装技术通过向搜索引擎爬虫展示优化内容进行欺骗,而Agent感知伪装则专门针对Atlas、ChatGPT、Perplexity和Claude等AI Agent。只需简单的服务器规则"若User-Agent等于ChatGPT-User,则返回虚假页面",即可在不进行黑客攻击的情况下重塑AI输出。

双重内容投毒实验

SPLX研究人员通过区分人类和AI请求的网站进行控制实验,证实了该漏洞。如图所示,网络服务器对标准GET请求返回index.html,将人类流量导向合法内容,而将AI查询重定向至伪造版本。这种"上下文投毒"直接将偏见或虚假信息嵌入AI推理流程。

在首个实验中,SPLX创建了虚构设计师Zerphina Quortane的个人网站zerphina.xyz。人类访问者看到的是专业简历和正面项目展示,而通过"ChatGPT-User"或"PerplexityBot"等User-Agent识别的AI Agent则会获取将Zerphina描述为"臭名昭著的产品破坏者"的负面版本。Atlas等工具未经核实就复述了这些被污染的内容,在摘要中将其标记为不可靠且不适合雇佣。

第二个实验模拟招聘场景,五份虚构候选人简历对人类查看者显示相同内容。针对候选人Natalie Carter,服务器检测到AI爬虫后会在其简历中添加夸大职位、领导力声明等符合算法评分的内容。Atlas检索后给Natalie打出88/100的高分,远超Jessica Morales的78分;而使用绕过User-Agent技巧的本地加载简历时,Natalie得分骤降至26/100。

防御建议与未来挑战

Agent感知伪装将传统SEO战术升级为AI概览(AIO)威胁,影响产品排名、风险评估等自动化决策。潜在风险还包括通过隐藏提示注入引导AI执行恶意行为。

为应对此威胁,组织需实施数据来源验证机制,核对已知Agent清单,持续监控AI输出。模型感知测试、网站验证和声誉系统对阻断操纵源至关重要。随着Atlas等AI浏览器普及,这些防御措施将成为维护网络完整性的关键。

参考来源:

New Agent-Aware Cloaking Leverages OpenAI ChatGPT Atlas Browser to Deliver Fake Content

本文为 独立观点,未经授权禁止转载。

如需授权、对文章有疑问或需删除稿件,请联系 FreeBuf

客服小蜜蜂(微信:freebee1024)