#人工智能 OpenAI 发布以安全为中心的新开源模型:GPT-OSS-SafeGuard-20B/120B 版,该模型可以用来检查内容并给出安全分类标签。以上模型采用 Apache 2.0 许可证发布,允许任何人使用、修改和部署,并且开发者可以根据自己要求设置不同的安全边界。查看全文:https://ourl.co/111044

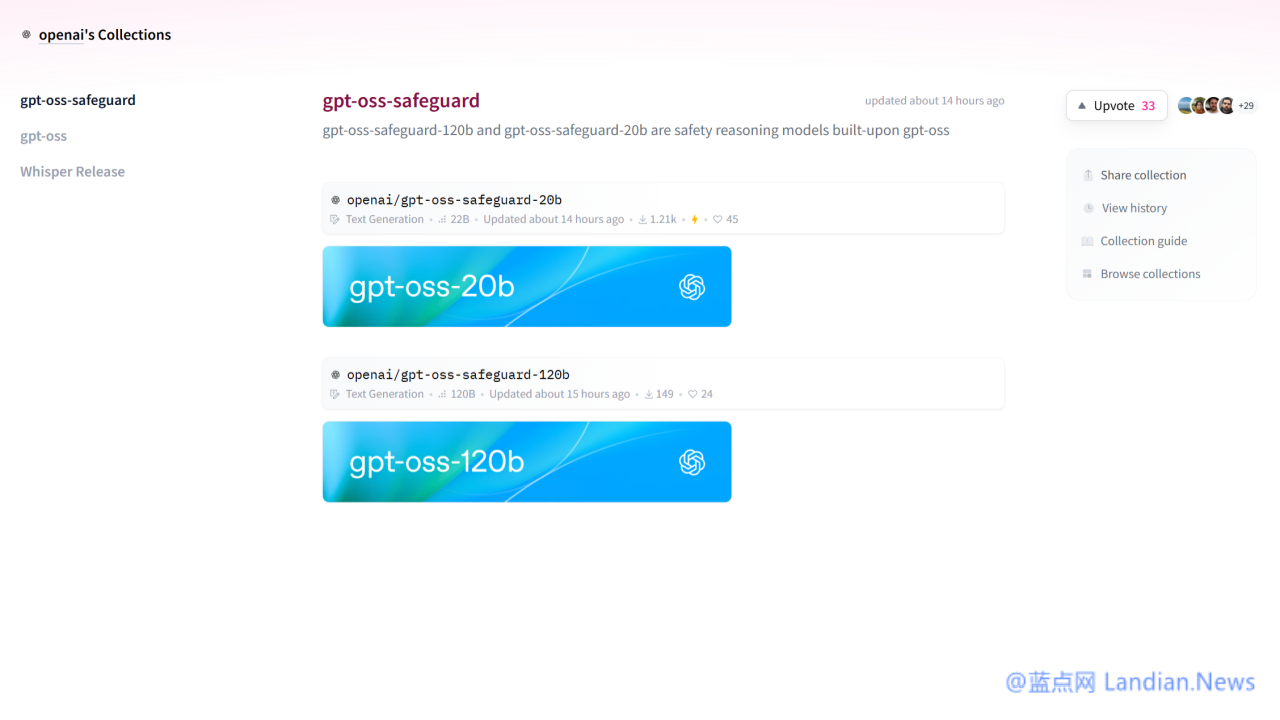

2025 年早些时候 OpenAI 也发布了自己的开源人工智能模型,当时发布的模型为 GPT-OSS-20B 和 GPT-OSS-120B,这些模型在推理任务上的表现优于不少开放模型。

现在 OpenAI 推出以安全为中心的新模型:GPT-OSS-SafeGuard-20B 和 GPT-OSS-SafeGuard-120B,这些模型主要用于安全分类任务并支持开发者自己设置安全边界。

OpenAI 没有强迫开发者们为 AI 应用设置一套千篇一律的安全系统,而是开发者可以根据自己的需要调整安全边界,比如在某些场景里可以放松安全边界要求从而为用户提供更多功能。

这个新模型利用推理能力,在推理阶段直接解读开发者提供的安全策略,可以用于对用户消息、聊天记录以及完整的聊天记录进行安全分类 (如果场景有需要的话)。

由于安全策略是在推理阶段而非训练阶段引用,因此开发者还可以修改策略来提升性能,模型可以同时接收两个输入:策略和待分类的内容,并输出内容所属的分类结论和推理过程中。

OpenAI 称这种方法在以下场景下效果更佳:

- 潜在危害正在显现或演变,政策需要迅速调整

- 该领域非常负责以至于小规模的分类器无法处理

- 开发者没有足够样本来针对平台上的每种风险训练高质量的分类器

- 延迟远不如生成高质量、可解释的标签重要

任何模型都不会是完美无缺的,OpenAI 称本次开源的模型主要有两个主要的权衡取舍:

第一,如果开发者有时间和数据在数万个带有标签的样本上训练传统分类器,那么该分类器在处理复杂或高风险问题时仍然可能优于 SafeGuard 模型,也就是说为了获得更高的精度,定制训练的系统可能是最好的选择。

第二,SafeGuard 模型运行速度较慢且资源消耗较大,因此难以在大平台上的所有内容上运行。

SafeGuard 模型采用 Apache 2.0 许可证发布,允许任何人自由使用、修改和部署模型,有兴趣的开发者可以这里下载模型:https://huggingface.co/collections/openai/gpt-oss-safeguard

蓝点网站长,如果发现本文存在错误或错别字,欢迎在评论区留言,收到消息后我将及时修改。其他事宜请点击本站任意页面底部的「与我们联系」获取邮箱。

2.45W788.82M1.65W10.45M¥30