SOC环境中大语言模型的局限性

大语言模型(LLM)和智能代理系统在日常生产力场景中表现出色,包括会议转录与摘要生成、待办事项提取、重要邮件优先级排序乃至旅行规划。但在安全运营中心(SOC)这种错误会带来实际损失的场景中,当前模型在处理需要高精度且持续执行的海量实时数据流时仍显不足。在规模化解决可靠性问题之前,单靠LLM无法实现大多数SOC任务的自动化。

人类擅长处理模糊问题、做出风险感知判断以及运用领域直觉,尤其在信号微弱、矛盾或新颖的情况下。而机器则擅长以极低边际成本处理海量高速非结构化数据,不会疲劳、遗忘或偏离目标,是威胁检测的理想补充。然而,事件分级研判仍依赖人类,因为机器(包括LLM)在上下文整合、假设生成和业务风险判断方面无法真正替代人类专家。

SOC自动化面临的五大技术瓶颈

要实现机器速度的防御,平台必须突破当前LLM的局限:

1. 规模化实时数据摄取

需无延迟、无遗漏地持续处理快速累积的数据(包括日志、终端检测与响应数据、电子邮件、云资源、身份信息、代码、文件等)。

2. 大规模持久化上下文

需保留并检索超大规模长期知识(如资产清单、基线配置、案例历史),以准确解读随时间推移的行为序列。

3. 低延迟低成本执行

需以数据输入速率执行过滤、关联、丰富和推理,且保持极低成本以确保企业级扩展性。

4. 确定性逻辑

需在大数据集上遵循思维链,得出可重复、可解释且易于理解的结果(而非反复无常或晦涩难懂)。

5. 推理一致性

需提供校准过的可重复逻辑,其偏差范围应接近人类专家间的分歧幅度,而非生成式模型的波动水平。

技术栈重构方案

解决方案并非"更多提示词",而是需要新型模型来解决这些问题,使LLM适用于SOC场景。任何有过AI/ML实践经验者都明白,模型需要高质量数据。我们必须超越以日志为中心的安全信息与事件管理系统(SIEM),因为高质量威胁检测和调查所需的数据远多于日志所能提供的。

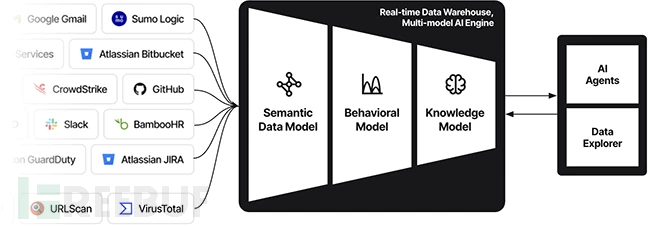

以关键业务应用中非常规位置的文件权限变更为例:仅事件记录远远不够,我们还需知道文件类型、标签、变更者的角色权限、文件创建者等信息。为此需要构建实时数据仓库,不仅关联日志,还整合身份信息、配置、代码、文件和威胁情报。在此基础上运行具备人类级推理能力的AI引擎,处理所有实时数据。

一种可行的AI引擎方案是构建多模型AI管道,结合语义推理、行为分析和大语言模型。语义理解和统计机器学习通过低延迟管道处理海量数据,大幅缩小需要LLM关联推理的数据范围,从而实现规模化可靠推理而不增加延迟或成本。

该方案的另一个优势在于:实时数据仓库不仅是AI引擎持续训练以检测威胁和分级警报的关键,还可作为长期存储库用于安全可视化和取证分析——这实际上是用更现代的数据平台取代传统SIEM,引领我们迈向AI驱动SOC的无SIEM未来。

SOC工作模式的变革

1. 威胁检测(检测工程师)

在多数组织中,这个稀缺专业岗位将从编写脆弱规则和调优用户实体行为分析(UEBA),转变为设计自适应系统。工程师不再为单个指标或特征编写检测规则,而是引导AI驱动模型持续关联日志、身份、配置和代码库中的信号。工作重心从规则编写转向威胁建模和反馈循环,确保持续准确的检测。

2. 警报分级(SOC分析师/一级二级团队)

长期以来,分级研判工作充斥着重复性的信息丰富、关联分析、降噪处理,以及向IT或DevOps团队寻求确认等流程。通过先进AI引擎加人工监督,这些工作大多可实现自动化。我们的分级机器人(Exabots)与分析师协同工作,显著提升效率。人员配置模式将随之改变:减少对大规模一级/二级团队或外包MSSP的7×24小时依赖,降低总体成本,同时提升警报检测和分级能力。

3. 威胁猎捕

猎捕是最依赖人类直觉的领域,但常受限于查询速度慢、工具碎片化和数据不完整。借助现代数据架构和上述AI引擎,猎捕人员可实时查询经过关联的上下文丰富信息,并由自动代理辅助发现异常和构建时间线。猎捕人员不再花费数小时收集证据,而是编程代理来验证假设、运行对手模拟并创造性追踪微弱信号,实现从被动个案处理到主动防御的转变。

未来发展方向

我们确信,现代数据架构加演进后的AI模型能克服当前LLM的诸多限制,逐步减少从代理系统获取可靠结果所需的人工监督。这对中型企业尤为重要,它们需要在有限预算和人力下实现企业级安全防护。若实施得当,机器将推动安全民主化,使众多组织跨越传统架构的限制。

简言之:LLM是重大突破,但安全领域需要经过改造的"大脑"——专为实时持久化上下文、确定性逻辑和规模化一致性推理而构建的系统。这正是Exaforce正在研发的方向。

参考来源:

本文为 独立观点,未经授权禁止转载。

如需授权、对文章有疑问或需删除稿件,请联系 FreeBuf

客服小蜜蜂(微信:freebee1024)