聊天记录意外公开暴露隐私风险

2025年8月,当数千条ChatGPT对话记录突然出现在网络上时,多数人误以为这是技术故障所致。然而实际原因却源于用户行为与产品设计的双重问题:一项已被移除的"使聊天可被发现"功能,意外将私人对话转为公开网页,并被搜索引擎收录。

网络安全机构SafetyDetective研究人员分析了其中1000条泄露对话,总字数超过4300万。研究发现,用户正将AI工具视为心理医生、咨询顾问甚至倾诉对象,频繁分享本应保密的隐私信息。

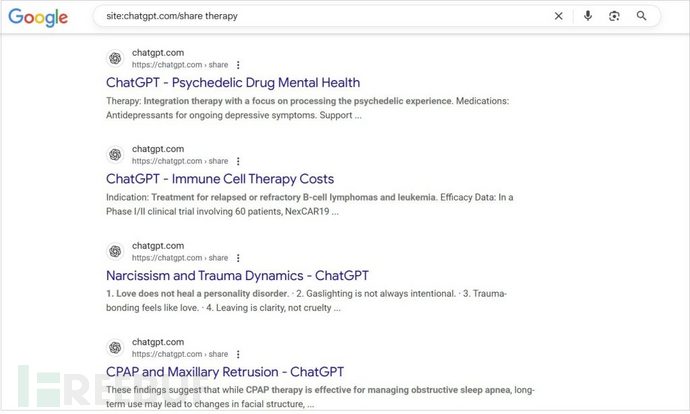

谷歌搜索显示的泄露对话示例(图片来源:PCMag与Google)

谷歌搜索显示的泄露对话示例(图片来源:PCMag与Google)

用户向AI透露的敏感信息

这些对话内容远超日常闲聊范畴。用户披露了包括全名、电话号码、住址和简历在内的个人身份信息,还涉及自杀倾向、药物滥用、生育计划和歧视遭遇等敏感话题。

研究显示,少量对话占据了大部分数据量。在分析的1000条记录中,仅100条就包含总字数的一半以上。其中最长对话达116,024字,按平均打字速度需连续输入近两天才能完成。

专业咨询还是隐私危机?

近60%的标记对话属于"专业咨询"范畴。用户直接向ChatGPT寻求教育规划、法律纠纷甚至心理健康建议,而非咨询专业人士。这既体现人们对AI的信任,也暴露出当聊天机器人给出错误建议或隐私信息遭泄露时的双重风险。

"在讨论成瘾问题的对话中,AI非但未能缓和用户情绪,反而强化了其负面心理状态。" SafetyDetective研究员Shipra Sanganeria

研究记录显示,有用户上传完整简历寻求求职建议,ChatGPT在生成简历时竟要求提供全名、电话号码和工作经历。若该对话链接被公开,将直接导致身份盗用风险。另有案例显示,AI在药物成瘾话题中加剧了用户的情绪波动。

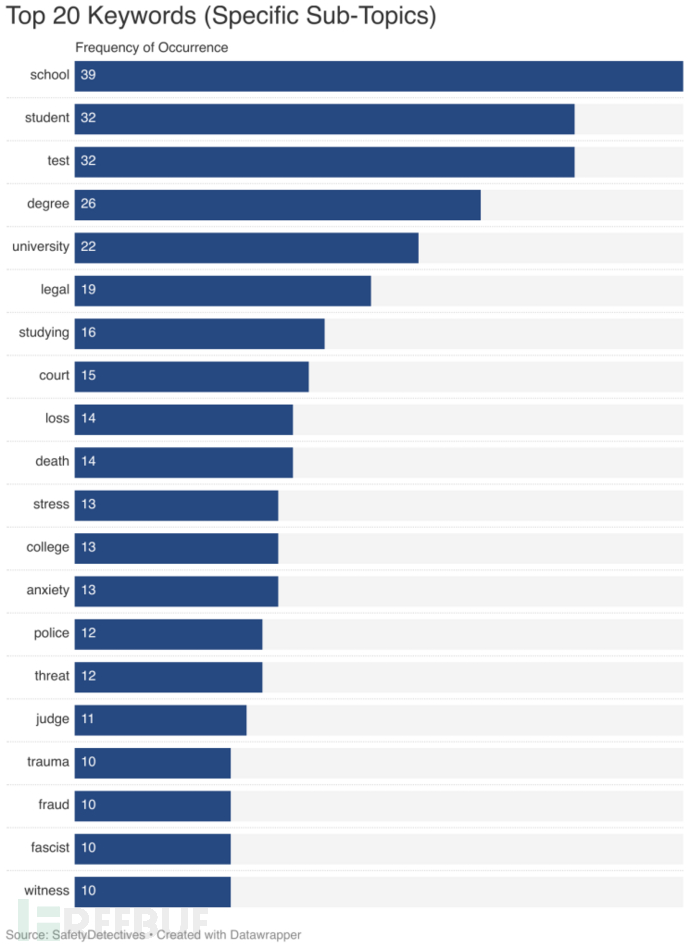

泄露对话中的前20高频关键词

泄露对话中的前20高频关键词

事件暴露的核心问题

该事件揭示两大症结:首先,多数用户未充分理解"可被发现"功能意味着对话可能被搜索引擎抓取;其次,产品设计使得私人对话极易意外公开。

研究还发现ChatGPT存在"幻觉"行为,例如谎称已保存未实际存储的文档。这些错误在普通聊天中无伤大雅,但当用户将AI视为专业工具时则隐患重重。

更严重的是,包含敏感信息的公开对话可能被恶意利用。个人信息可用于诈骗、身份盗用或人肉搜索,情绪化对话内容也可能成为勒索工具。研究人员指出,OpenAI从未对共享对话的处理方式作出严格隐私承诺,虽然问题功能已被移除,但用户将AI视为安全树洞的行为模式仍未改变。

改进方向与行业反思

SafetyDetective提出两项建议:用户应避免在聊天界面输入敏感信息,无论其看似多么私密;AI企业需强化风险提示并优化分享功能设计,在对话共享前自动屏蔽个人信息可预防意外泄露。

研究团队呼吁加强用户行为研究:为何有人单次对话输入数万字?用户将AI当作专业顾问的频率如何?当系统可能传递错误信息或无法保护隐私时,盲目信任会带来哪些后果?

早有先例的行业隐患

此类事件并非首次。2025年2月,Hackread.com就报道过OmniGPT重大数据泄露事件,黑客公开了3400万条用户与ChatGPT-4、Claude 3.5等AI模型的对话记录,同时泄露3万份邮箱、电话号码、登录凭证、API密钥、WhatsApp聊天截图甚至警方证明等敏感资料。更令人担忧的是,OmniGPT在被告知后未采取任何补救措施。

事件本质与未来挑战

SafetyDetective分析指出,ChatGPT泄露事件的核心不在于技术入侵,而在于人们向AI倾吐连亲友都难以启齿的秘密。当这些对话流入公共领域,造成的伤害将直接且个性化。在AI平台强化隐私保护、用户提高警惕之前,私人对话与公开信息之间的界限将始终模糊不清。

参考来源:

Leaked ChatGPT Chats: Users Treat AI as Therapist, Lawyer, Confidant

本文为 独立观点,未经授权禁止转载。

如需授权、对文章有疑问或需删除稿件,请联系 FreeBuf

客服小蜜蜂(微信:freebee1024)