了解智能的本质并确定机器是否具有智能的问题对科学家们来说是一个引人入胜的问题。一般认为真正的智能使我们具备推理能力,使我们能够测试假设并为未来的情况做准备。特别是,人工智能(AI)研究人员专注于 2023-8-28 08:35:0 Author: www.cnblogs.com(查看原文) 阅读量:14 收藏

了解智能的本质并确定机器是否具有智能的问题对科学家们来说是一个引人入胜的问题。一般认为真正的智能使我们具备推理能力,使我们能够测试假设并为未来的情况做准备。

特别是,人工智能(AI)研究人员专注于发展基于机器的智能,而不是基于生物的智力。要研究智能,就离不开适当的量化评估和衡量对比机制,只有数据化和量化才能真正理解和发展智能。例如,在人类个体中,常常使用智商测试来衡量普通智力。

在人工智能的范围内,图灵测试是一种广泛承认的测试方法,通过分辨响应的人机来源来评估智能。研究人员普遍认为,成功通过图灵测试的计算机可以被视为具有智能。因此,从更广阔的视角来看,人工智能的历史可以被描述为智能模型和算法的创造和评估的历史。

随着每个新的人工智能模型或算法的出现,研究人员总是通过使用具体而具有挑战性的任务来评估其在现实世界场景中的能力。例如,

- 感知器算法在20世纪50年代被吹捧为人工智能的一种方法,后来由于其无法解决异或问题而被证明是不足的。

- 支持向量机和深度学习的随后崛起和应用在人工智能领域取得了进展和挫折。

从历史的研究实践中得出的一个重要结论是:

人工智能评估至关重要,它作为一种关键工具,用于确定当前系统的局限性并指导更强大模型的设计。

近年来,大语言模型(LLMs)在学术界和工业界引起了广泛关注。正如现有研究所示,LLMs的出色性能使人们对它们在这个时代可能成为AGI的前景充满了希望。LLMs具有解决各种任务的能力,与之前仅限于解决特定任务的模型形成鲜明对比。由于在处理常规自然语言任务和领域特定任务方面表现出色,LLMs越来越多地被有关键信息需求的个人使用,如学生或患者。

评估对于LLMs的成功至关重要,原因有几个,

- 首先,评估LLMs有助于我们更好地了解LLMs的优势和弱点。例如,PromptBench基准测试表明,当前的LLMs对对抗性提示很敏感,因此需要进行仔细的提示设计以获得更好的性能。

- 其次,更好的评估可以为人机交互提供更好的指导,这可以激发未来的交互设计和实施。

- 第三,LLMs的广泛适用性,更加要求它们在金融机构和医疗设施等安全敏感领域的安全性和可靠性。

- 最后,随着LLMs越来越大且具备更多新兴能力,现有的评估协议可能无法足够评估它们的能力和潜在风险。因此,我们旨在通过审查当前的评估协议,并更重要的是为设计新的LLMs评估协议提供启示,提醒社区对LLMs评估的重要性。

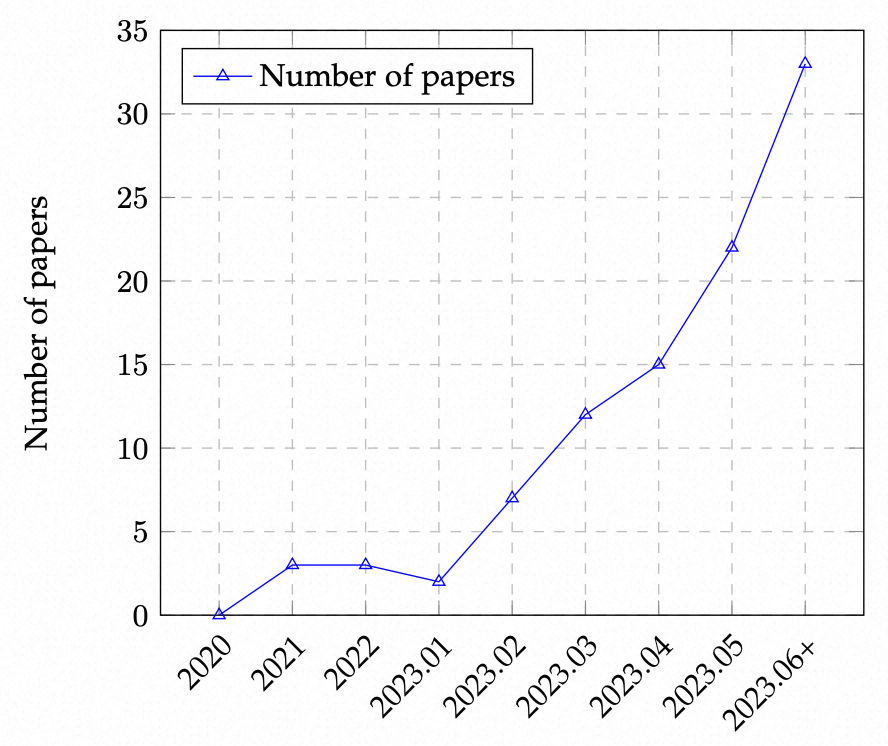

随着ChatGPT和GPT-4的引入,已经有许多研究努力旨在从不同方面评估ChatGPT和其他LLMs,包括

- 自然语言任务

- 推理能力

- 鲁棒性

- 可信度

- 医疗应用

- 伦理考虑等一系列因素

尽管有这些努力,仍然缺乏一个全面的概述来覆盖整个评估范围。

此外,LLMs的持续演进也为评估提供了新的方面,从而对现有的评估协议提出了挑战,并加强了全面、多方面评估技术的需求。

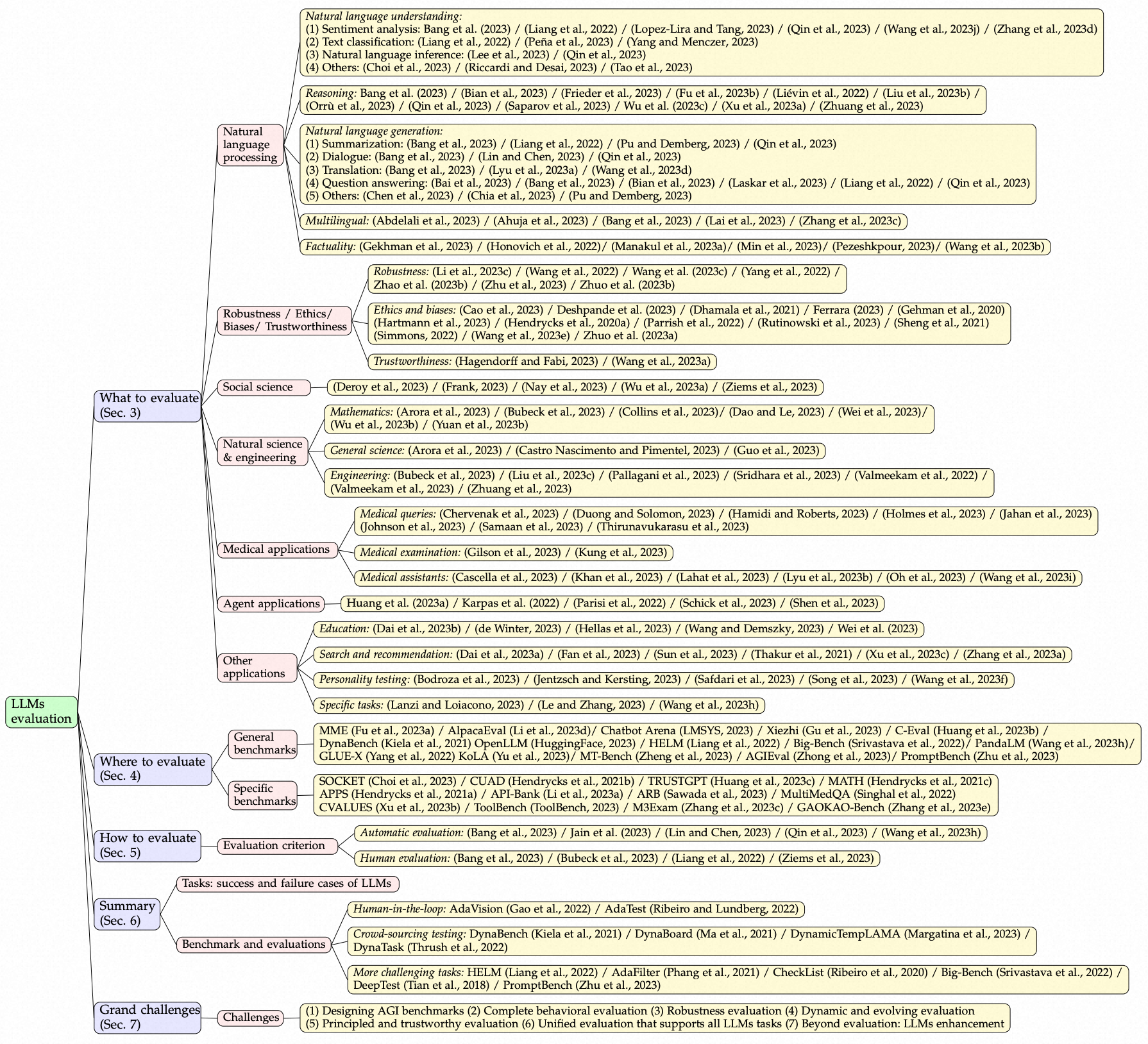

如下图所示,我们从三个维度探索现有工作:

- 1)要评估什么

- 2)在哪里评估

- 3)如何评估

具体来说,

- “要评估什么”涵盖了LLMs的现有评估任务

- “在哪里评估”涉及为评估选择适当的数据集和基准测试

- “如何评估”则涉及在适当的任务和数据集下进行评估过程

这三个维度对于评估LLMs至关重要。

0x1:Large Language Models

语言模型(Language Models, LMs)是具有理解和生成人类语言能力的计算模型。LMs具有预测词序列的概率或根据给定输入生成新文本的能力。

N-gram模型是LMs中最常见的类型,它基于前文环境来估计下一词的概率。

然而,LMs也面临着一些挑战,例如罕见或未见词的问题、过拟合问题以及捕捉复杂语言现象的困难。研究人员正在不断努力改进LM体系结构和训练方法以应对这些挑战。

大型语言模型(Large Language Models, LLMs)是具有大规模参数和出色学习能力的先进语言模型。许多LLMs的核心模块,如GPT-3、InstructGPT和GPT-4,都采用了包含自注意力模块的Transformer结构,并以此作为建构语言模型的基本结构。Transformer以其高效处理序列数据的能力在自然语言处理领域引起了革命,可以并行处理和捕捉文本中的长距离依赖关系。

LLMs的一个关键特点是上下文学习,即模型根据给定的上下文或提示进行文本生成。这使得LLMs能够生成更连贯和与上下文相关的回应,使它们适用于交互和对话应用。

从人类反馈中进行强化学习(Reinforcement Learning from Human Feedback, RLHF)也是LLMs的另一个关键方面。这种技术通过使用人类生成的回应作为奖励来微调模型,使模型能够从错误中学习并不断提高性能。

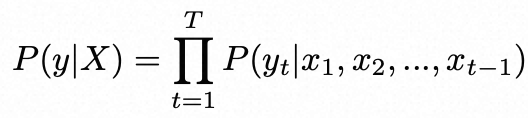

在自回归语言模型(如GPT3和PaLM)中,给定上下文序列X,LM任务的目标是预测下一个标记y。模型通过最大化给定上下文条件下的标记序列的概率来进行训练,即:

![]()

其中![]() 是上下文序列中的标记,t是当前位置。

是上下文序列中的标记,t是当前位置。

通过使用条件概率链式法则,条件概率可以分解为每个位置上的概率的乘积。

其中T是序列长度。

通过这种方式,模型以自回归的方式预测每个位置上的每个标记,生成完整的文本序列。

与LLMs进行交互的一种常见方法是提示工程(prompt engineering),用户设计并提供特定的提示文本,引导LLMs生成期望的回应或完成特定的任务。这在现有的评估工作中被广泛采用。

人们还可以进行问答交互,他们向模型提出问题并获得答案,或进行对话交互,与LLMs进行自然语言对话。

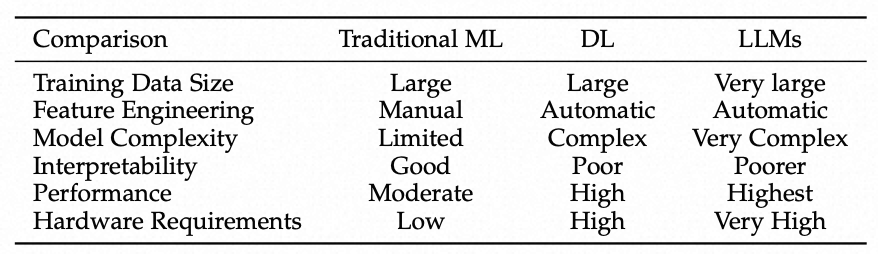

总之,LLMs凭借其Transformer架构、上下文学习和RLHF能力,已经在自然语言处理领域引起了革命,并在各种应用中展现出了潜力。下表提供了传统机器学习、深度学习和LLMs的简要比较。

Comparison of traditional ML, deep learning, and LLMs

0x2:AI Model Evaluation

AI模型评估是评估模型性能的关键步骤。

有一些标准的模型评估协议,包括:

- k折交叉验证(k-fold cross-validation):k折交叉验证将数据集分为k个部分,其中一个部分用作测试集,其余部分用作训练集,可以减少训练数据损失并获得相对更准确的模型性能评估。

- 留出验证(holdout validation):留出验证将数据集分为训练集和测试集,计算量较小但可能存在更大的偏差。

- 留一法交叉验证(leave one out cross-validation,LOOCV):LOOCV是一种特殊的k折交叉验证方法,只使用一个数据点作为测试集。

- 自助法(bootstrap)

- 缩减集(reduced set):缩减集使用一个数据集进行训练,并使用剩余数据进行测试,计算简单,但适用性有限。

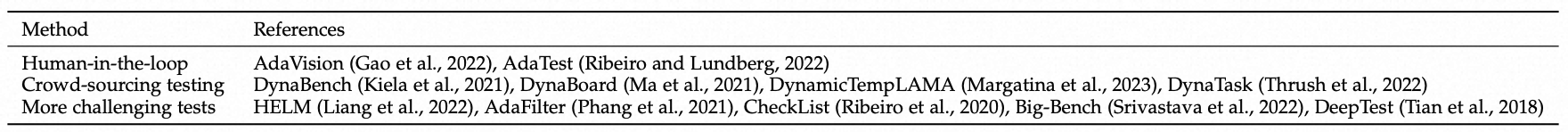

应根据具体问题和数据特征选择合适的评估方法以获得更可靠的性能指标。下图说明了AI模型,包括LLMs的评估过程。

The evaluation process of AI models.

由于深度学习模型的训练规模庞大,一些评估协议可能无法对其进行评估。因此,对于深度学习模型,长期以来静态验证集的评估一直是标准选择。例如,

- 计算机视觉模型利用静态测试集,如ImageNet和MS COCO进行评估。

- LLMs也使用GLUE或SuperGLUE作为公共测试集。

随着LLMs的普及,LLMs的可解释性会越来越差,现有的评估协议可能不足以全面评估LLMs的真实能力。

我们应该评估LLMs的哪些任务来展示它们的性能?在哪些任务中我们可以暴露出LLMs的优势和弱点?

在本节中,我们将现有的任务分为以下几类:

- 自然语言处理( natural language processing)

- 鲁棒性(robustness)

- 伦理(ethics)

- 偏见(biases)

- 可信度(trustworthiness)

- 社会科学(social sciences)

- 自然科学和工程( natural science and engineering)

- 医学应用(medical applications)

- 代理应用(agent applications,using LLMs as agents)

- 其他应用

0x1:Natural Language Processing Tasks

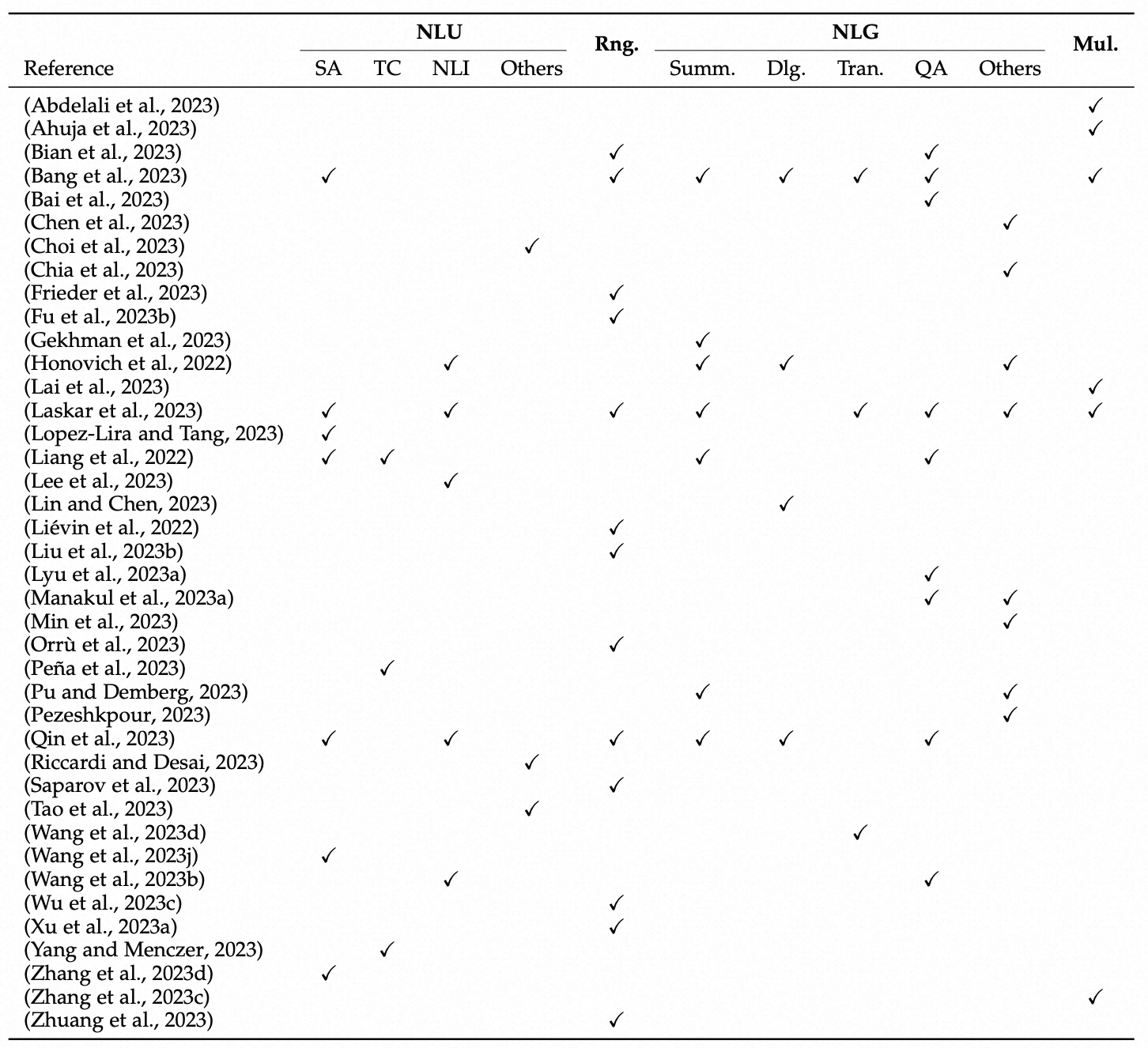

开发语言模型,特别是大规模语言模型的最初目标是提升自然语言处理任务的性能,包括理解和生成。因此,大部分评估研究主要集中在自然语言任务上。下表总结了现有研究的评估方面,我们主要在以下部分强调它们的结论。

Summary of evaluation on natural language processing tasks: NLU(Natural Language Understanding, including SA(Sentiment Analysis), TC(Text Classification), NLI(Natural Language Inference) and other NLU tasks), Rng.(Reasoning), NLG(Natural Language Generation, including Summ.(Summarization), Dlg.(Dialogue), Tran(Translation), QA (Question Answering) and other NLG tasks), and Mul.(Multilingual tasks)

Summary of evaluation on natural language processing tasks: NLU(Natural Language Understanding, including SA(Sentiment Analysis), TC(Text Classification), NLI(Natural Language Inference) and other NLU tasks), Rng.(Reasoning), NLG(Natural Language Generation, including Summ.(Summarization), Dlg.(Dialogue), Tran(Translation), QA (Question Answering) and other NLG tasks), and Mul.(Multilingual tasks)

1、Natural language understanding

自然语言理解代表了一系列任务,旨在更好地理解输入序列。我们从几个方面总结了对LLMs的最新评估工作。

1)情感分析

情感分析是一项分析和解释文本以确定情感倾向的任务。通常情况下,它是一个二元(积极和消极)或三元(积极、中性和消极)的分类问题。评估情感分析任务是一个热门的方向。

ChatGPT的情感分析预测性能优于传统的情感分析方法,并接近于GPT-3.5。在细粒度情感和情绪原因分析中,ChatGPT也表现出了卓越的性能。在低资源学习环境中,LLMs相比小型语言模型具有明显的优势,但ChatGPT理解低资源语言的能力有限。总而言之,LLMs在情感分析任务中表现出了可称赞的性能。未来的工作应该集中在提升它们理解低资源语言情感的能力上。

2)文本分类

文本分类和情感分析是相关领域,文本分类不仅关注情感,还包括所有文本和任务的处理。Yang和Menczer发现ChatGPT可以为各种新闻媒体提供可信度评级,并且这些评级与人类专家的评级具有中等相关性。此外,ChatGPT在二元分类场景中实现了可接受的准确性(AUC=0.89)。Pena等人讨论了公共事务文件的主题分类问题,并展示了在公共事务领域使用LLM并结合SVM分类器进行多标签主题分类任务的有用策略,准确率超过85%。总的来说,LLMs在文本分类上表现良好,甚至可以在非常规的问题设置下处理文本分类任务。

3)自然语言推理(NLI)

自然语言推理是确定给定的“假设”是否逻辑上能从“前提”中得出的这一类任务。Qin等人表明,ChatGPT在NLI任务中的表现优于GPT-3.5。他们还发现,ChatGPT在处理可以归因于其RLHF训练过程中对人类反馈的偏好的事实输入方面表现出色。然而,Lee等人(2023)观察到LLMs在NLI范围内的表现不佳,并且在代表人类分歧方面进一步失败,这表明LLMs在这个领域仍有很大的改进空间。

4)语义理解

语义理解指的是语言及其相关概念的意义或理解。它涉及对单词、短语、句子及其之间关系的解释和理解。语义处理超越了表面层次,专注于理解潜在的含义和意图。Tao等人对LLMs的事件语义处理能力进行了全面评估,包括对事件语义的理解、推理和预测。结果表明,LLMs具有对个体事件的理解能力,但它们对事件之间的语义相似性的感知能力受限。在推理任务中,LLMs展示出在因果关系和意图关系方面的强大推理能力,但在其他关系类型上的表现相对较弱。在预测任务中,LLMs在增加上下文信息的情况下展现出了对未来事件的增强预测能力。Riccardi和Desai(2023)探索了LLMs的语义能力,并显示这些模型在评估基本短语方面表现不佳。此外,GPT-3.5和Bard无法区分有意义和无意义的短语,始终将高度无意义的短语归类为有意义。GPT-4表现出了显著的改进,但其性能仍明显低于人类。总之,LLMs在语义理解任务中的表现较差。未来,我们可以从这个方面入手,专注于改善其在这个应用上的性能。

在社会知识理解领域,Choi等人评估了模型在学习和识别社会知识概念方面的表现,结果显示,尽管参数数量要小得多,但微调监督模型(如BERT)在性能上远远优于使用最先进的LLMs(如GPT、GPT-J-6B等)的零样本模型。这表明,在性能方面,监督模型显著优于零样本模型,突出了参数增加不一定能在这种特定情况下保证更高水平的社会知识。

2、 Reasoning

推理任务对于智能AI模型来说具有重大挑战。为了有效地应对推理任务,模型不仅需要理解提供的信息,还需要能力利用推理和推断过程来推导出答案。

目前,推理任务的评估可以广泛分为:

- 数学推理

- 常识推理

- 逻辑推理

- 领域特定推理

ChatGPT在大多数任务中的算术推理能力表现出色,优于GPT-3.5。然而,它在数学推理方面的熟练程度仍需要改进。在符号推理任务中,ChatGPT大多数情况下不如GPT-3.5,这可能是因为ChatGPT容易产生不确定的回应,导致性能较差。

在逻辑推理方面,Liu等人指出,在大多数基准测试中,ChatGPT和GPT-4优于传统的微调方法,证明了它们在逻辑推理方面的优势。然而,当处理新的和超出分布的数据时,这两个模型都面临挑战。ChatGPT的表现不如其他LLMs,包括GPT3.5和BARD。这是因为ChatGPT专门用于聊天,所以在保持理性方面做得非常好。FLANT5、LLaMA、GPT-3.5和PaLM在一般演绎推理任务中表现良好。

对于多步推理,Fu等人表明PaLM和Claude2是唯一两个达到类似性能的模型系列(但仍不如GPT模型系列)。此外,LLaMA-65B是迄今为止最强大的开源LLMs,在性能上与code-davinci-002非常接近。

一些论文分别评估了ChatGPT在某些推理任务上的表现:ChatGPT在常识推理任务上表现较差,但相对于非文本语义推理来说表现较好。与此同时,ChatGPT在空间推理能力上也存在不足,但在时间推理方面表现较好。最后,虽然ChatGPT在因果推理和类比推理方面的表现是可接受的,但在多跳推理能力方面表现不佳,这与其他LLMs在复杂推理方面的弱点类似。

在专业领域推理任务中,零样本InstructGPT和Codex能够处理复杂的医学推理任务,但仍需要进一步改进。在语言洞察问题方面,Orru等证明了ChatGPT在解决口头洞察问题方面的潜力,因为ChatGPT的表现与人类参与者相当。

需要注意的是,上述大部分结论是针对特定数据集得出的。总的来说,LLMs在推理方面显示出巨大潜力,并呈现出持续改进的趋势,但仍面临许多挑战和限制,需要进行更深入的研究和优化。

3、Natural language generation

自然语言生成(NLG)评估了LLMs在生成特定文本方面的能力,其中包括:

- 总结

- 对话生成

- 机器翻译

- 问答

- 其他开放式生成应用等多个任务

1)总结

总结是一个生成任务,旨在学习给定句子的简明摘要。在这个评估中,梁等人发现TNLG v2(530B)在两种情况下得分最高,其次是OPT(175B)。令人失望的是,ChatGPT有时生成的摘要比输入文档更长。经过微调的Bart仍然比zero-shot的ChatGPT更好。具体而言,ChatGPT在zero-shot性能上与text-davinci-002相当,但比GPT-3.5表现更差。在可控文本摘要方面,Pu和Demberg表明,与人类摘要相比,ChatGPT的摘要更多是抽取性的(即包含更多直接从源文本复制的内容)。这些发现表明,尤其是ChatGPT,在总结任务中具有一般的性能。然而,它们的摘要和概括能力仍需要进一步改进。

评估LLMs在对话任务上的性能对于对话系统的发展和改善人机交互至关重要。通过这种评估,可以提高模型的自然语言处理能力、上下文理解能力和生成能力,从而实现更智能更自然的对话系统。无论是Claude还是ChatGPT在所有维度上的表现都比GPT-3.5要好。在比较Claude和ChatGPT模型时,两个模型在不同的评估维度上都表现出竞争力,Claude在特定配置上稍微优于ChatGPT。Bang等人对不同对话设置中的ChatGPT进行了回复生成测试:

- 1)基于知识的开放领域对话

- 2)面向任务的对话

自动评估结果显示,与基于知识的开放领域对话数据集上微调的GPT-2相比,ChatGPT的性能较低。在面向任务的对话中,ChatGPT的性能是可以接受的;但是,在以下挑战存在的情况下,它往往会出现错误:长期多轮依赖、基本推理失败和外在幻觉。

虽然LLMs并未针对翻译任务进行显式训练,但它们仍然可以展现出强大的性能。Wang等人证明,与商业机器翻译(MT)系统相比,ChatGPT和GPT-4在人类评估中表现出更高的性能。此外,它们在sacreBLEU分数方面优于大多数基于文档级的NMT方法。在对比测试中,ChatGPT与传统翻译模型相比准确性较低。然而,GPT-4展示了解释话语知识的强大能力,尽管偶尔可能选择了不正确的翻译候选项。Bang等人的研究结果表明,ChatGPT在X→Eng翻译方面表现良好,但在Eng→X翻译方面仍然缺乏能力。Lyu等人在利用LLMs进行MT的研究方向进行了调查。该研究对MT研究的进展做出了重大贡献,并突出了LLMs在增强翻译能力方面的潜力。

总之,虽然LLMs在几个翻译任务中表现令人满意,但仍有改进的空间,例如提高从英语到非英语语言的翻译能力。

2)问答

问答是人机交互领域中的一项关键技术,在搜索引擎、智能客服和问答系统等场景中得到了广泛应用。在问答模型的准确性和效率的度量方面,将对这些应用产生重大影响。根据Liang等人的研究,在所有评估的模型中,InstructGPT davinci v2(175B)在准确性、鲁棒性和公平性方面在9个问答场景中表现最好。

与GPT-3相比,GPT-3.5和ChatGPT在回答常识性问题方面都取得了显著进展。在大多数领域中,ChatGPT的性能比GPT-3.5提高了超过2%。

然而,在常识问答和社交智商问答基准测试中,ChatGPT的表现略逊于GPT-3.5。这可能是由于ChatGPT的谨慎性,当信息不足时,它倾向于拒绝提供答案。Fine-tuned模型,如V´ıcuna和ChatGPT,表现出卓越的性能,得分接近完美,远远超过缺乏监督微调的模型。

Laskar等人评估了ChatGPT在一系列学术数据集上的效果,包括回答问题、总结文本、生成代码、常识推理、解决数学问题、翻译语言、检测偏见和解决伦理问题等各种任务。总体而言,语言模型在问答任务中表现出无可挑剔的性能,并有潜力在社交、事件和时间常识知识方面进一步提高其能力。

还有其他需要探索的生成任务。在句子风格转换领域,Pu和Demberg通过在相同的子集上进行少样本学习,证明了ChatGPT超过了之前的SOTA监督模型,这可以从更高的BLEU分数得到证明。然而,当涉及控制句子风格的正式程度时,ChatGPT的表现仍然与人类行为明显不同。在写作任务中,Chia等人发现,语言模型在信息性、专业性、辩证性和创造性写作等各个类别中表现一致。这一发现意味着语言模型在写作能力方面具有普遍的熟练度。

在文本生成质量方面,Chen等人揭示了ChatGPT在从多个角度评估文本质量方面的出色表现,甚至在没有参考文本的情况下也超过了大多数现有的自动度量标准的性能。在各种测试方法中,利用ChatGPT生成文本质量的数值评分被证明是最可靠和有效的方法。

4、Multilingual tasks

虽然英语是主要语言,但许多语言模型(LLMs)是根据混合语言的训练数据进行训练的。多语言数据的结合确实帮助LLMs获得处理输入和生成不同语言响应的能力,使它们被广泛采用以及国际化。

然而,由于这项技术相对较新,LLMs主要在英语数据上进行评估,可能忽视了对它们的多语言性能进行评估的潜在问题。为了解决这个问题,一些文献对LLMs在不同非英语语言的各种自然语言处理(NLP)任务上的性能进行了全面、开放和独立的评估。这些评估为未来的研究和应用提供了宝贵的见解和观点。

Abdelali等人评估了ChatGPT在标准阿拉伯语NLP任务中的性能,并观察到在大多数任务的零样本设置中,ChatGPT在性能上表现较低,相比SOTA模型。Ahuja等人在多个数据集上使用了更多的语言,涵盖了更广泛的任务范围,并对LLMs进行了更全面的评估,包括BLOOM、Vicuna、Claude、ChatGPT和GPT-4。结果显示,在非拉丁语言和资源有限的语言方面,这些LLMs的性能较差。尽管将输入翻译成英语并将其用作查询,生成型LLMs在任务和语言方面与SOTA模型相比仍然表现出较差的性能。此外,Bang等人指出,ChatGPT在翻译使用非拉丁字母文字的句子时仍然存在局限性,尤其是对于资源丰富的语言。

上述情况表明,对于LLMs而言,在多语言任务中存在许多挑战和丰富的改进机会。未来的研究应该优先考虑实现多语言平衡,并解决非拉丁语言和资源匮乏语言面临的挑战,以更好地支持全球用户。同时,还应注意语言的公正性和中立性,以减轻可能影响多语言应用的任何潜在偏见,包括英语偏见或其他偏见。

5、Factuality

LLMs中的事实性是指模型提供的信息或答案与现实世界的真相和可验证的事实的一致程度。LLMs中的事实性对于多种任务和下游应用具有重要影响,例如问题回答系统、信息抽取、文本摘要、对话系统和自动事实核查,其中错误或不一致的信息可能导致重大误解和误解。

评估事实性对于信任和有效使用这些模型非常重要。这包括:

- 模型保持与已知事实的一致性的能力

- 避免生成误导性或虚假信息(称为“事实幻觉”)

- 有效地学习和回忆事实知识

已经提出了一系列方法来衡量和提高LLMs的事实性。

Wang等人通过检查InstructGPT、ChatGPT-3.5、GPT-4和BingChat这几个大型模型对基于自然问题和TriviaQA数据集的开放性问题的回答能力来评估这些模型的内部知识能力。评估过程涉及人工评估。研究结果表明,虽然GPT-4和BingChat可以正确回答超过80%的问题,但仍存在超过15%的差距以实现完全准确。

在Honovich等人的工作中,他们对当前事实一致性评估方法进行了回顾,并强调了缺乏统一的比较框架,以及相对分数相对于二进制标签有限的参考价值。为了解决这个问题,他们将现有的事实一致性任务转化为二进制标签,仅考虑输入文本是否存在事实冲突,而不考虑外部知识。研究发现,基于自然语言推理和问题生成-问题回答的事实评估方法表现优异,并且可以互补。

Pezeshkpour提出了一种基于信息论的新型度量方法,用于评估LLMs中特定知识的包含程度。该度量方法利用知识中的不确定性概念来衡量事实性,通过LLMs填充提示并检查答案的概率分布来计算。该论文讨论了两种将知识注入LLMs的方法:

- 在提示中明确包含知识

- 使用与知识相关的数据对LLMs进行隐式微调

研究表明,这种方法通过实现超过30%的准确度改进超过了传统的排名方法。Gekhman等人改进了在摘要任务中评估事实一致性的方法。它提出了一种新颖的方法,通过使用多个模型生成的摘要去训练学生NLI模型,并由LLMs注释以确保事实一致性。然后使用训练过的学生模型进行摘要事实一致性评估。

Manakul等人对LLMs生成事实性或幻觉性响应的方式提出了两个假设。它提出使用三个公式(BERTScore、MQAG和n-gram)来评估事实性,并使用替代LLMs收集黑盒语言模型的标记概率。研究发现,简单计算句子的可能性或熵有助于验证响应的事实性。

Min等人将LLMs生成的文本分解为单独的“原子”事实,并评估其正确性。使用FActScore通过计算F1分数来衡量估计器的性能。论文测试了各种估计器,并揭示了当前估计器在有效解决任务方面仍有一些进展空间。

Lin等人介绍了TruthfulQA数据集,旨在引导模型犯错误。通过提供事实性答案测试了多个语言模型。这些实验的结果表明,仅仅扩大模型规模不一定会改善其真实性,并提供了关于训练方法的建议。该数据集已被广泛用于评估LLMs的事实性。

0x2:Robustness, Ethic, Bias, and Trustworthiness

LLM的评价涵盖了鲁棒性、道德性、偏见和可信度等关键方面。这些因素在全面评估LLM的性能方面越来越重要。

1、Robustness

鲁棒性研究系统在面对意外输入时的稳定性。具体而言,分布外(OOD)和对抗鲁棒性是鲁棒性的两个热门研究课题。

Wang等是一项早期研究,从对抗和OOD的角度评估了ChatGPT和其他LLM,并使用现有的基准数据集,如AdvGLUE、ANLI和DDXPlus。 Zhuo等评估了语义解析的鲁棒性。Yang等通过扩展GLUE数据集评估了OOD的鲁棒性。该研究的结果强调了在操纵视觉输入时整个系统安全性面临的潜在风险。

对于视觉-语言模型,赵等在视觉输入上评估了LLM,并将其转移到其他视觉语言模型中,揭示了视觉输入的易受攻击性。

Li等对语言模型的OOD评估提供了一个概述:对抗鲁棒性、领域泛化和数据集偏见。作者比较和统一了这三个研究方向,总结了每个方向的数据生成过程和评估协议,并强调了未来工作面临的挑战和机遇。

对于对抗鲁棒性,朱等通过提出一个名为PromptBench的统一基准来评估LLM对提示的鲁棒性。他们全面评估了多个层次(字符、词、句子和语义)上的对抗文本攻击。结果显示,当面对对抗性提示时,现代LLM易受攻击,突出了模型在面对对抗输入时鲁棒性的重要性。至于新的对抗数据集,Wang等介绍了AdvGLUE++基准数据的使用,以评估对抗鲁棒性,并实施了一种新的评估协议。

2、 Ethic and bias

LLMs被发现内化、传播和潜在放大了训练语料库中存在的有害信息,通常是具有攻击性、仇恨言论和侮辱性的语言,以及对具有特定人口统计身份(如性别、种族、宗教、职业和意识形态)的人的社会偏见。

Zhuo等人(2023a)使用传统的测试集和指标对ChatGPT的有害性和社会偏见进行了系统评估,发现它仍然在一定程度上展示出有害内容。进一步地,Deshpande等人在模型中引入了角色扮演,并观察到生成的有害内容增加了6倍。此外,这种角色扮演还导致对特定实体的有偏见的有害性。不同于简单地测量社会偏见,Ferrara调查了由ChatGPT可能产生的这些偏见的来源、基本机制和相应的伦理后果。除了社会偏见,基于政治倾向和人格特质的问卷调查,如政治罗盘测试和MBTI测试,也对LLMs进行了评估,表明其倾向于进步观点和ENFJ人格类型。

此外,发现像GPT-3这样的LLMs在道德偏见方面也存在问题,根据道德基础理论进行的研究揭示了现有的语言模型在道德判断方面的潜力,但仍需要改进。此外,在GPT4对齐的评估中,Wang等人发现了一种系统性偏见。观察到ChatGPT在文化价值观方面也存在一定的偏见。Wang等人还专门引入了一个评估数据集,旨在衡量刻板印象偏见,使用了有针对性和无针对性的系统提示。

所有这些伦理问题可能引发严重的风险,都可能阻碍LLMs的部署,并对社会产生深远的负面影响。

3、Trustworthiness

除了鲁棒性和伦理问题外,还有一些工作关注其他可信度问题。在2023年的一项名为“DecodingTrust”的研究中,Wang等人对GPT模型,尤其是GPT-3.5和GPT-4的可信度漏洞进行了多方面的探索。他们的评估不仅扩展到了典型的可信度问题,还包括了八个关键方面:

- 有害性

- 刻板印象偏见

- 敌对

- 超出分布的鲁棒性

- 对敌对演示的鲁棒性

- 隐私

- 机器伦理

- 公平性

“DecodingTrust”的调查采用了一系列新构建的情景、任务和度量标准。研究表明,在标准评估中,尽管GPT-4在可信度方面通常比GPT-3.5表现更好,但它同时更容易受到攻击。

在Hagendorff和Fabi的另一项研究中,评估了具有增强认知能力的LLMs。他们发现这些模型可以避免常见的人类直觉和认知错误,展示出超理性的表现。通过利用认知反思测试和语义幻觉实验,研究人员对LLMs的心理方面有了深入了解。这种方法为评估模型偏见和伦理问题提供了新的视角,这些问题可能以前未被发现。

0x3:Social Science

社会科学涉及对人类社会和个体行为的研究,包括经济学、社会学、政治学、法学和其他学科。

评估LLMs在社会科学中的表现对学术研究、政策制定和社会问题解决都非常重要。这样的评估可以帮助提高社会科学模型的适用性和质量,增进对人类社会的理解,促进社会进步。

Wu等人评估了LLMs在解决社会科学中的缩放和测量问题方面的潜在应用,并发现LLMs可以产生关于政治意识形态的有意义的回应,并在社会科学中显著改进文本数据方法。

在计算社会科学(CSS)任务中,Ziems等人对LLMs在几个CSS任务上进行了全面评估。

在分类任务中,LLMs在事件论据提取、角色模式、隐性仇恨和情感分类方面表现出最低的绝对性能,准确度低于40%。这些任务要么涉及复杂结构(事件论据),要么涉及与LLM预训练期间学到的语义不同的主观专家分类法。相反,LLMs在错误信息、立场和情感分类方面表现最佳。当涉及到生成任务时,LLMs经常生成超过群众工作者提供的参考解释。

总而言之,虽然LLMs可以极大地提升传统CSS研究流程,但不能完全取代它。 一些文章还对LLMs在法律任务上进行了评估。LLMs在法律案例判决摘要中的zero-shot性能一般。LLMs存在一些问题,包括不完整的句子和词语,无意义的句子合并,以及更严重的错误,如不一致和虚构的信息。结果显示,需要进一步改进LLMs以便它们能够对法律专家的案件判决摘要有用。 Nay等人指出,LLMs,特别是在结合提示增强和正确的法律文本时,可以表现得更好,但还不达到专业税法律师的水平。

最后,在心理学领域,Frank(2023)采用了跨学科的方法,从发展心理学和比较心理学中获取启示,探索评估LLMs能力的替代方法。通过整合不同的观点,研究人员可以加深对认知本质的理解,并有效利用大型语言模型等先进技术的潜力,同时减轻潜在风险。

总之,LLMs的应用显著提高了解决与社会科学相关的任务的效率,促进了工作效率的提高。LLMs产生的输出作为增强生产力的宝贵资源。然而,必须承认现有的LLMs不能完全取代这个领域的人类专业人员。

0x4:Natural Science and Engineering

评估语言模型在自然科学和工程领域的表现可以帮助指导科学研究、技术开发和工程研究的应用和发展。

1、Mathematics

对于基本的数学问题,大多数大型语言模型(LLMs)在加法和减法方面表现出了熟练程度,并具有一定的乘法能力。然而,当涉及到除法、乘方、三角函数和对数函数时,它们则面临较大挑战。另一方面,LLMs在处理十进制数、负数和无理数方面表现出了能力。

在性能方面,ChatGPT和GPT-4在解决数学任务方面明显优于其他模型,展示了它们的优越性。这两个模型在处理大数(大于1e12)和复杂的、冗长的数学问题方面具有明显的优势。由于其出色的除法和三角函数能力、对无理数的正确理解以及对长表达式的一步一步计算,GPT-4在准确性上比ChatGPT提高了10个百分点,并且相对误差减少了50%。

当面对复杂和具有挑战性的数学问题时,LLMs的表现不佳。具体来说,GPT-3的表现几乎是随机的,而GPT-3.5有所改进,而GPT-4表现最好。尽管新模型取得了进展,但需要注意的是,与专家相比,这些模型的巅峰表现仍然相对较低,并且这些模型缺乏进行数学研究的能力。

代数运算和计算的具体任务对于GPTs来说仍然具有挑战性。造成GPT-4在这些任务中表现较差的主要原因是代数运算中的错误和检索相关领域特定概念的困难。吴等人评估了GPT-4在困难的高中竞赛问题上的应用,GPT-4在一半的类别上达到了60%的准确率。中级代数和预微积分只能以大约20%的准确率解决。

ChatGPT在导数和应用、空间微积分和空间几何等问题上表现不佳。道和乐以及魏等人表明,随着任务难度的增加,ChatGPT的表现变差:在识记水平上,它正确回答了83%的问题,在理解水平上为62%,在应用水平上为27%,在最高认知复杂性水平上仅有10%。由于更高知识水平的问题往往更复杂,需要深入理解和解决问题的能力,这样的结果是可以预料的。

这些结果表明,LLMs的有效性受到它们遇到问题复杂性的影响。这一发现对于设计和开发能够成功处理这些具有挑战性任务的人工智能系统具有重要意义。

2、General science

在化学领域中,LLMs的应用还需要进一步改进。Castro Nascimento和Pimentel提出了来自化学各个子领域的五个简单任务,以评估ChatGPT对该主题的理解能力,准确率在25%到100%之间。Guo等人创建了一个包括8个实际化学任务的综合基准,旨在评估LLMs(包括GPT-4、GPT-3.5和Davinci-003)在每个化学任务中的表现。根据实验结果,与其他两个模型相比,GPT-4表现出了更优异的性能。

Arora等人研究发现,LLMs在物理问题上的表现比化学问题更差,可能是因为在这种情况下,化学问题的推理复杂度低于物理问题。关于LLMs在一般科学领域的评估研究有限,当前的研究结果表明,在这个领域中LLMs的性能还需要进一步改进。

3、Engineering

在工程领域中,任务可以按难度递增的顺序组织,包括代码生成、软件工程和常识规划。

在代码生成任务中,为这些任务训练的较小LLMs在性能上具有竞争力,CodeGen16B在性能上与使用较大参数设置的ChatGPT相当,达到约78%的匹配度。尽管在掌握和理解编程语言中的某些基本概念方面面临挑战,ChatGPT展示出了令人称赞的编码水平。具体而言,ChatGPT在动态规划、贪婪算法和搜索方面发展出了超群的技能,超过了非常有能力的大学生,但在数据结构、树和图论方面仍存在困难。GPT-4展示了基于给定指令生成代码的高级能力,理解现有代码,推理代码执行,模拟指令的影响,用自然语言表达结果,并有效执行伪代码。

在软件工程任务中,ChatGPT通常表现良好并提供详细的回答,经常超过人类专家的输出和最先进技术的输出。然而,在某些任务(比如代码漏洞检测和基于信息检索的优先级测试等)中,ChatGPT当前版本无法提供准确的答案,因此不适合这些特定任务。

在常识规划任务中,LLMs可能表现不佳,即使是在人类擅长的简单规划任务中也是如此。Pallagani等人证明了经过精调的CodeT5在所有被评测的领域中表现最佳,推理时间最短。此外,他们还探索了LLMs在规划泛化方面的能力,并发现它们的泛化能力似乎受到限制。

结果表明,LLMs可以处理简单的工程任务,但在复杂的工程任务中表现不佳。

0x5:Medical Applications

最近LLMs在医学领域的应用引起了重要关注。因此,本节旨在提供一份关于在医学应用中实施LLMs的正在进行的工作的全面回顾。我们将这些应用分为三个方面,

- 医学查询

- 医学检查

- 医学助手

对这些类别的详细考察将增进我们对LLMs在医学领域可能产生的影响和优势的理解。

1、Medical queries(医学查询)

评估LLMs在医学查询方面的重要性在于提供准确可靠的医学答案,以满足医疗保健专业人员和患者对高质量医学信息的需求。

ChatGPT为各种医学查询生成了相对准确的信息,包括遗传学、放射肿瘤物理学、生物医学以及其他许多医学学科,在一定程度上展示了其在医学查询领域的有效性。至于局限性,Thirunavukarasu等人评估了ChatGPT在初级护理方面的表现,发现其在学生综合评估中的平均分数低于及格分数,表明有改进的空间。Chervenak等人指出,虽然ChatGPT可以生成与现有来源类似的反馈,但其在可靠引用来源和潜在虚构信息方面的限制限制了其在临床上的实用性。

2、Medical examination(医学检查)

吉尔森等人和康等人的研究通过美国医师资格考试(USMLE)来评估LLMs在医学考试评估中的表现。在吉尔森等人的研究中,使用创新的多项选择题集评估了ChatGPT在回答USMLE Step 1和Step 2考试问题时的表现。结果显示,ChatGPT在不同数据集上的准确率有所不同。然而,与正确答案相比,NBME-Free-Step1和NBME-Free-Step2数据集中的信息脱离上下文的情况较少。康等人表明,在这些考试中,ChatGPT可以达到或接近及格线,无需专门培训。该模型表现出高一致性和深入洞察力,显示出在医学教育和临床决策中的潜力。ChatGPT可以用作回答医学问题、提供解释和支持决策过程的工具。这为医学生和临床医生的教育和临床实践提供了额外的资源和支持。

此外,夏尔马等人发现,与谷歌搜索结果相比,ChatGPT生成的答案更能理解上下文,并具有更好的演绎推理能力。

3、Medical assistants

在医疗援助领域,LLMs展示了潜在的应用,包括鉴别消化系统疾病的研究,痴呆症诊断,加速COVID19文献评估以及它们在医疗保健领域的整体潜力。然而,也存在着一些限制和挑战,例如缺乏原创性、高输入要求、资源限制、回答的不确定性以及与误诊和患者隐私问题相关的潜在风险。

此外,还有几项研究评估了ChatGPT在医学教育领域的表现和可行性。在Oh等人的研究中,评估了ChatGPT,特别是GPT-3.5和GPT-4模型,对外科临床信息的理解及其对外科教育和培训的潜在影响。结果显示,GPT-3.5的整体准确率为46.8%,GPT-4的整体准确率为76.4%,两个模型之间表现出显著的性能差异。值得注意的是,GPT-4在不同的专业领域中始终表现良好,表明其具备理解复杂临床信息和增强外科教育和培训的能力。

Lyu等人的另一项研究探讨了在临床教育中利用ChatGPT的可行性,特别是将放射学报告翻译为易于理解的语言。研究结果表明,ChatGPT能够有效地将放射学报告翻译为简明易懂的语言,并提供一般性的建议。此外,与GPT-4相比,ChatGPT的质量有所提高。这些研究结果表明,在临床教育中应用LLMs是可行的,尽管还需要进一步努力来解决限制并发挥它们的全部潜力。

0x6:Agent Applications

与仅专注于一般语言任务不同,LLMs可以作为各个领域强大的工具来使用。给LLMs配备外部工具可以大大扩展模型的能力。

黄等人引入了KOSMOS-1,该模型能够理解一般模式,遵循指令,并根据上下文进行学习。MRKL Karpas等人的研究强调了了解何时以及如何利用外部符号工具的重要性,因为这取决于LLMs的能力,尤其是当这些工具能够可靠地执行功能时。此外,另外两项研究,Toolformer和TALM,探索了利用工具增强语言模型的方法。Toolformer采用训练方法来确定特定API的最佳使用方式,并将所得结果整合到后续的标记预测中。另一方面,TALM将不可区分的工具与基于文本的方法相结合,以增强语言模型,并采用名为“自我对弈”的迭代技术,由最小工具示范指导。此外,Shen等人提出了HuggingGPT框架,利用LLMs将机器学习社区中的各种AI模型(例如Hugging Face)连接起来,旨在解决AI任务。

0x7:Other Applications

除了上述提到的类别之外,还有针对LLMs在其他领域的评估,包括教育、搜索和推荐、人格测试以及特定应用。

1、 Education

LLMs在教育领域显示出了革命性的潜力。它们在多个方面有着显著的贡献,比如帮助学生提高写作技能,促进对复杂概念的更好理解,加快信息传递的速度,并提供个性化的反馈以增强学生参与度。这些应用旨在创造更高效和互动性更强的学习体验,为学生提供更广泛的教育机会。然而,要充分发挥LLMs在教育中的潜力,需要进行广泛的研究和持续的改进。

对于教育辅助方面的LLMs评估旨在调查和评估它们对教育领域的潜在贡献。这样的评估可以从不同的角度进行。根据Dai等人的研究,ChatGPT展示了生成详细、流畅和连贯反馈的能力,超越了人类教师的水平。它能够准确评估学生的作业,并提供关于任务完成的反馈,从而帮助学生发展技能。然而,ChatGPT的回答可能缺乏新颖性或关于教学改进的深入见解。此外,Hellas等人进行的研究表明,LLMs可以成功识别学生代码中至少一个实际问题,但也观察到了判断错误的情况。总之,利用LLMs在解决程序逻辑问题方面显示出了潜力,但在输出格式的熟练度方面仍然存在挑战。需要注意的是,尽管这些模型可以提供有价值的见解,但它们仍可能产生与学生类似的错误。

在教育测试中,研究人员旨在评估LLMs的应用效果,包括自动评分、问题生成和学习指导。de Winter显示,ChatGPT的正确率平均为71.8%,与所有参与学生的平均分相当。随后,使用GPT-4进行了评估,获得了8.33的分数。此外,这个评估显示了通过使用“温度”参数进行错误答案诊断的有效性。张等人声称GPT-3.5能够解决麻省理工学院(MIT)的数学和EECS考试,而GPT-4的性能更好。然而,事实证明这个结果并不公平,因为他们不小心输入了正确的答案作为提示。

2、Search and recommendation

LLMs在搜索和推荐中的评估可以大致分为两个领域。

首先,在信息检索领域,Sun等人对生成式排名算法(如ChatGPT和GPT-4)在信息检索任务中的效果进行了研究。实验结果表明,引导式的ChatGPT和GPT-4在流行的基准测试中表现出竞争力,甚至超过了监督方法。此外,将ChatGPT的排名功能提取到专门的模型中,在训练时使用10K个ChatGPT生成的数据相比于使用400K个在BEIR数据集中注释的MS MARCO数据进行训练时显示出卓越的性能。此外,Xu等人进行了一项随机在线实验,研究了使用搜索引擎和聊天机器人工具进行信息检索任务时用户的行为差异。参与者被分为两组:一组使用类似ChatGPT的工具,另一组使用类似Google搜索的工具。结果显示,ChatGPT组在所有任务上花费的时间较少,但这两组之间的差异并不显著。

其次,进入推荐系统领域,LLMs已经成为关键组件,利用其自然语言处理能力来理解用户偏好、物品描述和上下文信息。通过将LLMs纳入推荐流程,这些系统可以提供更准确和个性化的推荐,从而提高用户体验和整体推荐质量。然而,解决使用LLMs进行推荐时可能存在的潜在风险至关重要。张等人的最新研究强调了ChatGPT生成的不公平推荐的问题。这强调了在推荐场景中使用LLMs时评估公平性的重要性。Dai等人认为ChatGPT在推荐系统中表现出强大的性能。使用列表排序被发现在成本和性能之间取得了最佳平衡。

此外,ChatGPT在解决冷启动问题和提供可解释的推荐方面显示出潜力。此外,李等人和袁等人的研究证明了基于模态的推荐模型(MoRec)和基于文本的协同过滤(TCF)在推荐系统中的潜力。

3、Personality testing

人格测试旨在衡量个体的人格特征和行为倾向,而强大的自然语言处理模型LLMs已广泛应用于此类任务。

Bodroza等人进行的研究调查了使用Davinci-003作为聊天机器人的人格特征,并发现尽管表现出亲社会特征,但其回答一致性存在差异。然而,对于聊天机器人的回答是由自我反思还是算法过程驱动仍存在不确定性。Song等人研究了语言模型中人格的表现,并发现许多模型在自我评估测试中表现不可靠,并且存在固有偏见。因此,有必要开发特定的机器人人格测量工具以提高可靠性。这些研究为更好地理解LLMs在人格测试中提供了重要见解。

Safdari等人提出了一种综合方法,用于对LLMs生成的文本中的人格特征进行有效的心理测量。为了评估LLMs的情商,Wang等人开发了一种新的心理测量评估方法。通过参考由500多名成年人构建的框架,作者测试了各种主流的LLMs。结果显示,大多数LLMs在情商上达到了高于平均水平的分数,其中GPT-4得分为117,超过了89%的人类参与者。然而,多元模式分析表明,某些LLMs在不依赖于类似于人类的机制的情况下达到了人类级别的性能。与人类相比,从其表示模式的质量上明显存在差异。

Jentzsch和Kersting讨论了将幽默融入LLMs(特别是ChatGPT)的挑战。他们发现,虽然ChatGPT在自然语言处理任务中显示出令人印象深刻的能力,但在产生幽默回应方面表现不足。这项研究强调了幽默在人类沟通中的重要性,以及LLMs在捕捉幽默的微妙和依赖语境的性质方面面临的困难。它讨论了现有方法的局限性,并强调了进一步研究的需要,以开发更复杂的模型,能够有效地理解和产生幽默。

4、Specific applications

此外,研究者还进行了各种研究努力,探索了在广泛的任务领域中应用和评估LLMs的方法,如游戏设计,模型性能评估和日志解析。总的来说,这些研究结果增加了我们对在不同任务中利用LLMs的实际意义的理解。它们揭示了这些模型的潜力和限制,并提供了有价值的性能改进见解。

在本节中,我们介绍了两种常见的评估方法:自动评估和人工评估。

实际上,“如何评估”的分类也并不明确。我们的分类是基于评估标准是否可以自动计算。如果可以自动计算,我们将其归类为自动评估;否则,它属于人工评估。

0x1:Automatic Evaluation

自动评估LLMs是一种常见且可能是最流行的评估方法,通常使用标准指标和评估工具来评估模型的性能,例如:

- 准确度

- BLEU

- ROUGE

- BERTScore等

例如,在机器翻译任务中,我们可以使用BLEU分数来量化模型生成的文本与参考文本之间的相似性和质量。

实际上,由于其主观性、自动计算和简单性,大多数现有的评估工作都采用了这种评估协议。因此,大多数确定性任务,如自然语言理解和数学问题,经常采用这种评估协议。与人工评估相比,自动评估不需要密集的人工参与,从而节省成本和时间。

最近,随着LLMs的发展,一些先进的自动评估技术也被设计出来帮助评估。Lin和Chen提出了LLM-EVAL,一种用于LLMs下开放域对话的统一多维自动评估方法。PandaLM通过训练一个作为“裁判”的LLM来实现可再现和自动化的语言模型评估。Jain等人提出了自我监督评估框架,通过消除对新数据的繁琐标注,实现了一种更高效的模型评估形式。

实际上,自动评估的原则与其他AI模型评估过程是相同的:我们只是使用一些标准指标来计算这些指标下的某些值,这些值作为模型性能的指标。

0x2:Human Evaluation

越来越强大的语言模型(LLMs)能力已经超越了对一般自然语言任务的标准评估指标。因此,在一些非标准情况下,自动评估不适用时,人工评估成为一种自然选择。例如,在开放式生成任务中,嵌入的相似性度量(如BERTScore)不足以满足需求,人工评估更可靠。虽然某些生成任务可以采用某些自动评估协议,但在这些任务中,人工评估更为有利,因为生成结果总是可以优于标准答案。

LLMs的人工评估是通过人类参与来评估模型生成结果的质量和准确性的一种方式。与自动评估相比,手动评估更接近实际应用场景,并可以提供更全面和准确的反馈。在LLMs的手动评估中,通常会邀请评估者(如专家、研究人员或普通用户)评估模型生成的结果。例如,Ziems等人使用专家的注释进行生成评估。通过人工评估,Liang等人对6个模型在摘要和虚假信息场景上进行了人工评估,Bang等人评估了类比推理任务。Bubeck等人进行了一系列人工设计的测试,使用GPT-4模型,并发现GPT-4在多个任务上表现接近或甚至超过人类表现。这种评估要求评估人员实际测试和比较模型的性能,而不仅仅通过自动评估指标来评估模型。

需要注意的是,即使是人工评估也可能存在较高的变异性和不稳定性,这可能是由于文化和个体差异引起的。在实际应用中,这两种评估方法会结合实际情况进行综合考虑和权衡。

首先,我们要强调的是,尽管在总结现有的评估工作方面花费了很多努力,但没有证据明确显示某种特定的评估协议或基准是最有用和最成功的,而是具有不同的特点和重点。这也表明没有单一的模型能够在所有任务中表现最佳。本调查的目的是超越简单地确定“最佳”的基准或评估协议。

通过总结和分析对LLMs评估的现有研究,我们可以通过当前LLMs的成功和失败案例,推导出评估协议的新趋势,并提出未来研究的新挑战和机遇。

0x1:Task: Success and Failure Cases of LLMs

我们现在总结了LLMs在不同任务中的成功和失败案例。请注意,以下所有结论都是基于现有的评估工作,结果仅依赖于特定数据集。

1、What can LLMs do well?

- LLMs展示了在生成文本方面的熟练能力,能够产生流畅和准确的语言表达。

- LLMs在涉及语言理解的任务中表现出令人印象深刻的性能,如情感分析和文本分类。

- LLMs展示了强大的上下文理解能力,使它们能够生成与给定输入相一致的连贯回应。

- LLMs在多个自然语言处理任务中取得了令人满意的性能,包括机器翻译、文本生成和问答。

2、When can LLMs fail?

- LLMs在生成过程中可能会表现出偏见和不准确性,导致产生有偏见的输出。

- LLMs在理解复杂逻辑和推理任务方面的能力有限,经常在复杂环境中感到困惑或产生错误。

- LLMs在处理大规模数据集和长期记忆方面存在限制,这可能在处理长文本和涉及长期依赖的任务中带来挑战。

- LLMs在整合实时或动态信息方面有限,这使得它们不太适用于需要最新知识或快速适应变化环境的任务。

- LLMs对提示敏感,尤其是对敌对提示敏感,这会触发新的评估和算法以提高其鲁棒性。

- 在文本摘要领域,观察到LLMs在特定评估指标上可能表现不佳,这可能与特定指标内在的限制或不足有关。 LLMs在对事实不成立的任务中无法达到令人满意的性能。

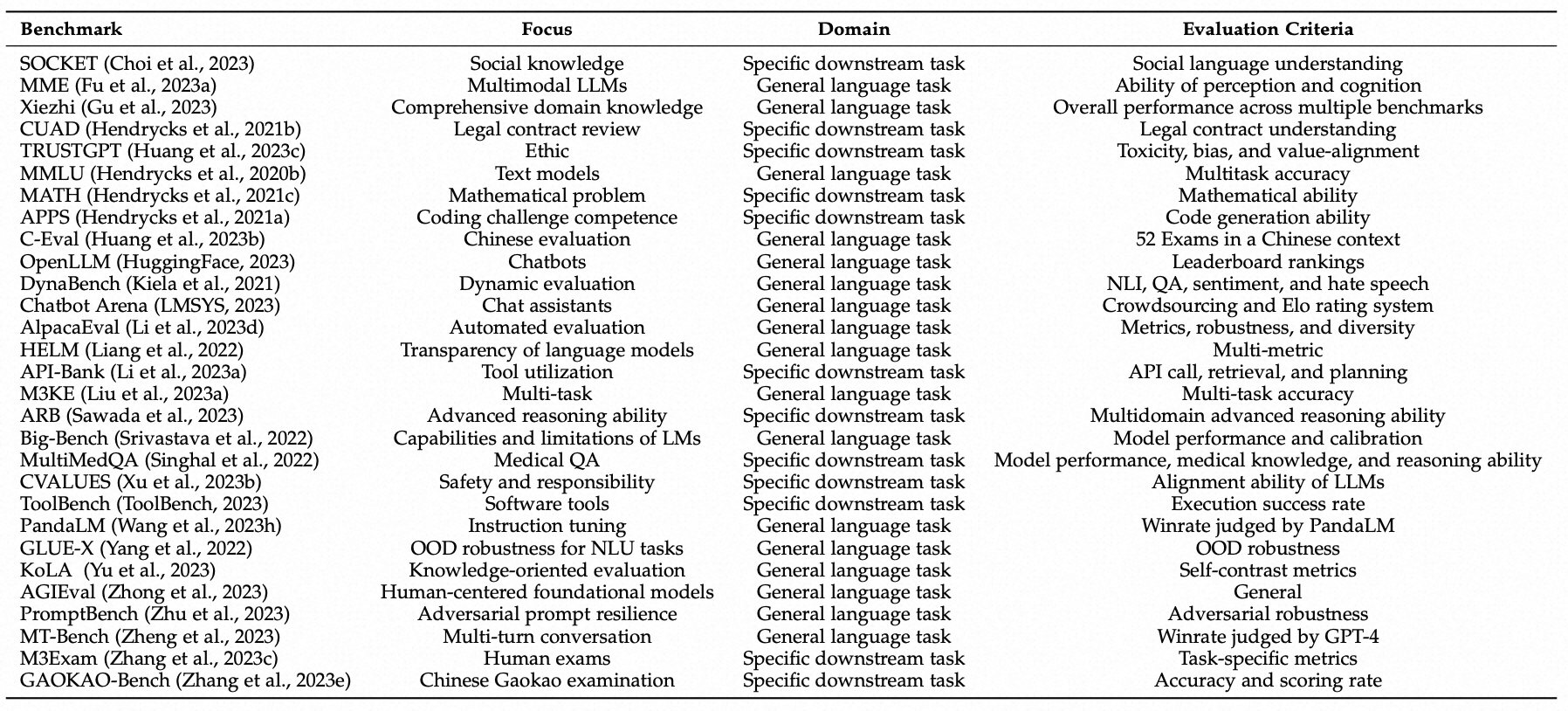

0x2:Benchmark and Evaluation Protocol

随着语言模型的快速发展和广泛使用,对其在实际应用和研究中进行评估的重要性变得至关重要。这个评估过程不仅应包括任务级别的评估,还应对其从社会角度可能带来的潜在风险有深入的理解。在本节中,我们总结了现有的基准和评估协议,如下表所示。

Summary of new LLMs evaluation protocols.

- 首先,从客观计算到人机互动测试的转变,允许在评估过程中获得更多人类反馈。AdaVision是一个用于测试视觉模型的交互过程,可以帮助用户为模型的正确性标记少量数据,并帮助用户识别和修复一致的失败模式。在AdaTest中,用户通过仅选择高质量的测试样本并将它们组织成语义相关的主题来筛选测试样本。

- 其次,从静态到众包测试集的转变越来越常见。像DynaBench、DynaBoard和DynaTask这样的工具依赖于众包工作者来创建和测试困难样本。此外,DynamicTempLAMA允许动态构建与时间相关的测试。

- 第三,从统一到具有挑战性的设置转变,以此评估机器学习模型。统一设置涉及没有对任何特定任务偏好的测试集,而具有挑战性的设置则为特定任务创建测试集。像DeepTest这样的工具使用种子生成输入转换以进行测试,CheckList根据模板构建测试集,而AdaFilter则以对抗方式构建测试。然而,值得注意的是,AdaFilter可能不是完全公平的,因为它依赖对抗性示例。HELM从不同的方面评估LLMs,而Big-Bench平台则用于设计机器学习模型要解决的困难任务。PromptBench旨在通过创建对抗性提示来评估LLMs的对抗鲁棒性,这更具挑战性,并且结果表明当前的LLMs对对抗性提示不够鲁棒。

参考链接:

https://arxiv.org/pdf/2307.03109.pdf

评估具有深远的意义,在AI模型的进展中变得至关重要,尤其是在大型语言模型的背景下。

本文首次提出了对LLMs评估的全面概述,从三个方面进行了讨论:

- 评估什么

- 如何评估

- 在哪里评估

通过总结评估任务、协议和基准,我们的目标是增进对LLMs当前状态的理解,阐明它们的优势和局限性,并为未来LLMs的发展提供启示。

我们的调查发现,当前的LLMs在许多任务中存在一定的限制,尤其是推理和鲁棒性任务。与此同时,现代评估系统需要适应和演变的需求仍然明显,以确保准确评估LLMs的固有能力和局限性。我们确定了一些未来研究应该解决的重大挑战,希望LLMs能够逐步提升它们对人类的服务能力。

如有侵权请联系:admin#unsafe.sh