区块链技术起源于比特币开源项目,比特币这个独具神秘色彩的项目自2009年起已经稳定运行十余年,在没有任何机构和个人进行专职运维的情况下没有出现过一次服务暂停,现今已经创造出千亿市值。区块链技术正是比特币一切传奇和辉煌背后的底层核心支撑技术。

区块链技术始于比特币,但不止于比特币,它博取经济学、密码学、博弈论、分布式系统等众多领域之长,背后带来的高可信、高可靠、高可用特性蕴藏着巨大的社会及商业价值,被认为是第四次工业革命浪潮中最重要且具有代表性的技术之一。

区块链概念

区块链概念起源于“神秘人物”中本聪于2008年发布的比特币白皮书,但10余年过去了,区块链仍没有一个标准的定义,然而这并不妨碍大家对区块链技术心驰神往,其对于技术的创新及商业社会的变革吸引着越来越多的人加入区块链的浪潮。

(1)区块链技术概述

1、区块链与信任

货币和文字都是人类文明历史长河中最具特色的伟大发明,二者之间存在着千丝万缕的关系,最早诞生的楔形文字就是当时苏美尔人用来记录商业交易信息的手段(当时的流通货币为大麦,称为“大麦货币”)。

文字承载信息,而货币承载信任,信任是一切商业行为的基础。

货币是有史以来最普遍也最有效的互信系统,其形态从实物货币、金属货币等实体货币逐渐演变为电子货币、数字货币等虚拟货币,从最开始作为既有实际价值又有信任价值的双向承载者演变为纯粹的信任承载者,货币体系的内核,就体现在信任上。

在经济学领域,信任被定义为一个主体评估另一个主体将采取某种特殊行为的主观概率水平。简单来说,对方在具有投机取巧的风险机会之下的策略就是信任的展现,而如何通过这种行为策略“计算”信任一直是各类学者重点研究的问题,鉴于人是有限理性的社会动物这一客观事实,目前还未构建出精确计算信任的环境和系统。

区块链技术的出现给信任的计算带来了新的方向,它的精妙之处在于不是计算人或参与主体的信任,而是计算信任过程中行为的可信度,即如果一个行为的违约性越低,则其可信度越高,反之亦然。这样无须在第三方进行背书的条件下就可以用风险成本和收益成本的设计模型重新定义信任,区块链开创了一种在不可信的竞争环境中低成本建立信任的新型计算范式和协作模式。

区块链作为一种新型可信协作模式,有望对新型生产关系的促进和经济社会的发展产生深远影响,国家对该项技术也极为重视。2016年,国务院印发的《“十三五”国家信息化规划》将区块链纳入新技术范畴并当作前沿布局。2019年10月,***在主持中共中央政治局第十八次集体学习时强调,“区块链技术的集成应用在新的技术革新和产业变革中起着重要作用。我们要把区块链作为核心技术自主创新的重要突破口,明确主攻方向,加大投入力度,着力攻克一批关键核心技术,加快推动区块链技术和产业创新发展。”2020年4月,国家发改委召开例行在线新闻发布会,明确将“区块链”纳入新型基础设施的信息基础设施中。区块链蕴含巨大的变革潜力,有望发展为数字经济信息基础设施的重要组件。

2、区块链定义

区块链目前尚未形成行业公认的定义,但对其定义解读的角度多种多样。

- 中本聪论文定义:中本聪的论文Bitcoin:A Peer-to-Peer Electronic Cash System指出,区块链是用于记录比特币交易账目历史的数据结构,每个区块的基本组成都由上个区块的散列值、若干条交易及一个调节数等元素构成,矿工通过工作量证明(PoW)来维持持续增长、不可篡改的数据信息,这是对于区块链最早的描述。论文中虽然介绍了区块链技术的要点和原理,但并未直接出现“Blockchain”(区块链)一词,给大家留下了丰富的想象和讨论空间。最终区块链这一命名由相关机构组织公开投票选出。

- 维基百科定义:区块链是凭借密码学算法串接起来并对内容进行保护的串联文字记录(区块)。每个区块都包含上个区块的加密散列、时间戳及交易数据(通常用默克尔树(Merkle Tree)计算的散列值表示),这样的设计使得区块中的内容具有不可篡改的特性。用区块链技术串接的分布式账本能让双方有效记录交易,且可永久查验此交易。

- 机构及专家定义:区块链是一种利用块链式数据结构验证与存储数据,利用分布式节点共识算法生成和更新数据,利用密码学手段保证数据传输和访问的安全,利用由自动化脚本代码组成的智能合约编程和操作数据的全新分布式基础架构与计算范式;区块链是大家共同参与记账的分布式账本,其通过单节点发起,全网广播、交叉审核、共同记账;区块链是建立信任的机器等。

3、区块链结构

区块链技术体系剥离了中心化的权威机构,通过分布式共识机制和加密算法来解决分布式系统中的信任和安全问题,区块链记录不可篡改,无须第三方机构进行信任担保,适合多个机构在区块链网络中相互监督并实时对账。区块链通过智能合约提高经济活动与契约的自动化程度,从而在多方协作的业务场景下提高业务效率、降低业务成本。其数据组织如下。

- 交易(Transaction):类比传统金融的交易定义。区块链中的交易是使底层数据状态发生变化的操作请求,每笔交易都对应唯一的交易哈希值。在使用过程中,多笔交易在一段时间内会被打包,形成一个区块,供多方查验。

- 区块(Block):一段时间内交易和底层数据状态结果打包的集合。系统在一次共识之后通常会生成一个区块,生成区块的时间间隔可以动态改变。

- 链(Chain):区块按照时间顺序向后追加形成一个串联的链,记录整个账本的状态变化,每个区块都会记录上个区块的哈希值,区块交易是否合法可以通过计算哈希值快速校验。

- 账本(Ledger):交易是由分布式系统中的多个节点共同记录的。每个节点都记录完整的交易信息,因此它们都可以监督交易的合法性并验证交易的有效性。不同于传统的中心化技术方案,区块链中任何一个节点都没有单独记账的权限,避免了因单一记账人或节点被控制而造假的可能。另外,由于全网节点都参与记账,因此除非绝大部分节点(数量由系统容错性决定)被破坏,否则交易记录不会丢失,保证了数据的安全。

(2)区块链技术来源

1、技术来源

上文提到的“中本聪”是一个具有神秘色彩的人物,其真实身份至今无从得知,2008年,他(她)在密码学邮件组中发表了论文Bitcoin:A Peer-to-Peer Electronic CashSystem(《比特币:一种点对点的电子现金系统》),提出了一种全新的、完全点对点的、可抛弃可信第三方的电子现金系统;2009年,比特币正式上线并发布创世区块,发行比特币2100万个,将在2040年全部发行完毕。比特币的诞生并不是一蹴而就的,任何一个现象级的技术出现,必然有一个深远而漫长的前序。

区块链技术起源于比特币,集密码学算法、分布式共识机制、点对点网络、时间戳等技术之大成,是一种基于零信任基础、去中心化的分布式系统。早在比特币以前,上述技术就有了很长的发展历史。在20世纪80、90年代,有一个想通过密码学算法改变世界的神秘联盟“密码朋克”(Cypherpunk),该联盟成员发现当时社会个人隐私和权限的侵蚀相当严重,在数字时代,保护隐私对于维持社会的开放性是至关重要的,于是这些热衷于加密算法的联盟成员每天都通过邮件进行技术交流,实现自己改变世界的想法,他们是数字货币最早的传播者。在其成员之中,密码破译专家大卫·乔姆在1981年的研究奠定了匿名通信的基础,并创建了数字化货币Ecash(Electronic Cash,电子现金)系统,作为以数据形式流通的货币;英国密码学家亚当·贝克在1997年发明了哈希现金(HashCash),采取PoW共识算法,通过一些额外的工作成本解决互联网上散布垃圾信息的问题;同年,哈伯和斯托尼塔提出了用时间戳保证数字文件安全的协议,后续发展为比特币协议的基础;戴维在1998年发明了数字货币系统B-Money,强调点对点交易及不可篡改的交易记录,也为比特币协议奠定了基础。

2、比特币

比特币之所以会引起广泛的热捧与讨论,是因为它是首个完全通过技术方式实现、无须中心化机构管理运维、安全可靠的数字货币系统。

传统货币,如纸质货币、电子货币,大家都比较熟悉,但是和比特币对比,二者具有很大的差别,如下表所示。

可以看到,同样是资产交易的流转,比特币没有依靠第三方机构进行担保管控,而寻求分布式共识机制、密码学算法自给自足、组织管理。这样相对于传统中心化系统的好处在于以下两点。

- 避免了中心化系统被攻击、交易成本高的问题:中心化顾名思义只有一个中心化系统进行统一管理,如果这个中心化系统被攻击或无法连接,那么整个系统将会瘫痪,造成不可逆的损失;除此之外,第三方机构交易会存在额外的手续费,这是第三方机构提供交易服务而产生的必然成本,这部分成本需要用户自己承担;用户还需要防范诈骗、盗刷、伪造等资产骗局,承担安全风险。

- 适用于“无强势中心”的场景:最典型的就是跨境贸易场景,由于发生贸易的两国的外汇储备不足,汇率变化导致两国意见不统一,每个国家都会更倾向于相信本国的银行系统,那么由谁来定夺将会是一个棘手的问题。

基于上述愿景,比特币设计了一套合理的货币发行机制,建立了一套可靠的交易记录系统,可以跨境交易,全球任何地方的用户都可以访问,这相对于每个国家独立、自成体系的银行系统具有更高的普适性,可以准确、可追溯地记录每笔在比特币系统中发生的交易,并且保证交易记录无法被恶意篡改。

基于上述目标,比特币通过分布式共识机制、密码学算法、块链式数据结构等技术完成了系统的构建,具有点对点传播、匿名性、交易可追溯、记录不可篡改等特性。

从技术层面上讲,区块链本质上是一个基于点对点网络(peer-to-peer)的分布式账本,数据由一串串相连的区块数据构成,相邻区块数据之间相互链接,其链接指针是采用密码学和哈希算法对区块头进行处理所产生的区块头哈希值。每个区块数据中都记录了一组采用哈希算法组成的树状交易状态信息,保证了每个区块内的交易数据都不可篡改,区块链里链接的区块也不可篡改。比特币的具体交易记录会保存在区块数据中,比特币系统大约每10分钟产生一个区块,如下图1-1所示,每个区块一般都包含区块头(Header)和区块体(Body)两部分,区块头封装当前的父区块哈希(Prev-Block)、版本号(Version)、默克尔根(Merkle Root)、时间戳(Timestamp)、难度(Target)、随机数(Nonce)信息。

区块头字段说明如表1-2所示。

比特币中采用PoW共识算法选择谁来记录交易并获得奖励(这个过程通常称为矿工“挖矿”),上述过程中的区块就是在挖矿过程中产生和确认的。挖矿是一种穷举随机数的算法,把上个区块的区块哈希加上10分钟内的全部交易打包,再加上一个随机数,计算出一个哈希值,规则需要随机数生成的哈希值满足一定条件(如00000开头),就可以获得这个区块的交易记账权。新产生的区块需要快速地广播出去,以便其他节点对其进行验证,防止造假。当记账成功时,获得区块奖励,也就是挖到了比特币。

(3)区块链技术特点

1、去中介化

去中介化是区块链技术最突出的技术特性,不同于传统应用的中心化数据管理,区块链技术不依赖额外的第三方机构或硬件设施,抛开基于中心化机构的信任评估、授权与担保,通过“机器信任”,即技术手段的方式,实现各个节点信息的自我验证、传递和管理。去中介化主要体现在网络架构和处理执行层面。

- 网络架构层面,不同于传统的星形拓扑网络,网络中存在一个中心网络节点,区块链拓扑网络为P2P(Peer-to-Peer,点对点)网络,其特点是任何一个节点的失效都不会影响其他节点之间的连接通信,极大地提高了网络容错性。

- 处理执行层面,区块链网络中不存在中心决策节点,即“中央节点”,所有节点承担的功能都是对等的,每个节点都可以独立处理、执行、决策、存储,最终通过分布式共识机制达成整个系统的统一。

2、不可篡改

记录在区块链上的数据会永远存在区块链上,一旦上链不可删除且极难篡改,这增强了链上信息的可信、可靠性。不可篡改主要体现在两个层面。

- 一是架构层面,区块链采取分布式全冗余存储,相当于区块链中的每方(每个节点)都有全量的数据,如果一方被篡改,那么所有方在共识过程中就会发现一方数据不一致从而进行错误处理,除非本次篡改得到了多方的同意。例如,比特币掌握51%及以上的算力,联盟链掌握1/3以上的投票权(该系统采用拜占庭容错算法)。这种掌握多数话语权的方式在分布式系统中极难实现,成本极高。

- 二是数据存储结构层面,区块链采用区块结构链式存储,每个区块中都保存着独一无二的区块哈希,并且该区块哈希会存储到下个区块中,下个区块哈希会存储到下下个区块中,从而形成链,当区块中的数据被篡改时,区块哈希会随之进行变化,造成本区块的区块哈希和下个区块的区块哈希记录的值不一致,除非后续区块中的区块哈希全部更改,这需要掌握区块链网络中的大多数算力或投票权,显然这很难实现。

综上所述,区块链通过分布式全冗余架构及密码学算法保证区块链上数据的不可篡改。

3、可追溯

区块链通过在块链式结构上标记时间戳的方式,达到可验证、可追溯的效果。交易的每次变更都会按照时间顺序记录在区块链上,并且将交易记录前后关联,最终形成一个完整的链,用户可以检索从源头到最终的所有交易信息,并且整个链的信息不可篡改和伪造,这样的特性可以很好地用于法律公证、知识产权等时间敏感的领域。

- 已上链的信息不可篡改

- 所有修改都可追溯

4、可信任

除了上述去中介化、不可篡改和可追溯特性,区块链还通过密码学算法对链上敏感的交易数据进行加密,用户需要具有相关权限才能访问,并且无须第三方机构,能够很好地解决不信任的问题。

区块链发展

2009年至今,区块链技术经历了10余年的发展,从在“极客圈”小部分人的爱好,到社会上万千大众对数字货币的狂热,再到回归技术本质的冷静。整体从乱象丛生到回归秩序,区块链的发展可谓是跌宕起伏。区块链的诞生并不是一蹴而就的,技术发展和产业应用是两个互相促进正向反馈的因子,在内部因子和外部因子的双重驱动下,区块链技术迸发出了持续的生机和活力,奋勇发展。下面将介绍区块链的发展历程,大致可以分为3个阶段:区块链1.0、2.0、3.0。

(1)区块链1.0——“可编程货币”

在区块链1.0阶段(2008—2013年),区块链技术的核心在于数字货币领域,以比特币为代表的加密数字货币主要解决了行业内长期存在的“双花问题”和“拜占庭将军问题[”。

- 双花问题主要研究在没有中心化或第三方机构的存在下,如何确保一笔交易的数字货币不被多次消费,不同于纸质货币,数字货币具有无限复制性

- 拜占庭将军问题主要研究在存在欺骗和错误的通信环境下,多个分布式参与方如何就同一决策达成一致

区块链通过点对点网络、密码学算法、分布式共识机制、区块结构链式存储等底层技术很好地解决了上述问题。后来出现的数字货币,如莱特币、狗狗币等的底层技术都是基于比特币区块链进行优化实现的,其架构一般可分为三层。

- 区块链层:区块链层是整体架构的核心,包括共识过程、消息传递、数据存储等核心功能。

- 协议层:协议层提供一些软件服务、规则制定等。

- 货币层:货币层主要作为价值表示,在用户之间传递价值,相当于一种货币单位。

可能有人会想,在有了银行、支付宝、Visa、PayPal等便捷又好用的服务设施后,为何还需要加密数字货币?在区块链1.0阶段,基于区块链技术构建了很多去中心化的数字支付系统,一笔交易可以直接由两个单独的个体发起和完成,很好地解决了货币、汇兑、支付手段等方面的信任、流通、风险问题,给传统的金融体系带来了一定的冲击。

但是,区块链的思想始于货币但不止于货币,其有望用一种完全分布式、全球化的方式在个体之间分配和交易各种资源和价值信息,成为一个全球性的可编程开放式网络。

(2)区块链2.0——“可编程金融”

承载着成为全球性的可编程开放式网络的愿景,伴随着图灵完备的智能合约系统的出现,区块链走进了2.0阶段。区块链1.0阶段的加密数字货币,在区块链网络中交易处理脚本语言只能完成货币资产交换的简单操作,但现实社会中不仅有货币资产的交易,还有股票、债券、产权、合同等各式各样、有形无形的资产需要进行转移和交换等复杂逻辑操作,简单的脚本语言无法发挥出区块链技术的潜在能量。所以业界逐渐将关注点转移到运行在区块链上的模块化、可重用、完备的自动执行脚本语言:智能合约。

从此,区块链的应用范围从数字货币领域延伸到金融交易、证券清算和结算、身份认证等商业领域,涌现出很多新的应用场景,如金融交易、智能资产、档案登记、司法认证,DApp(去中心化应用)、DAC(去中心化自治企业)等。

以太坊是区块链2.0阶段的代表性平台,其主要提供一个图灵完备的智能合约系统,通过编写以太坊独立研发的Solidity智能合约,开发者可以编程开发任何DApp,如投票、域名、金融交易、众筹、知识产权、智能财产等。根据以太坊白皮书所述,以太坊平台应用有三种类型。

- 金融应用:为用户提供更强大的资产管理和参与智能合约的方法。包括子货币、金融衍生品、对冲合约、遗嘱等涉及金融交易和价值传递的应用,甚至一些种类全面的雇佣合约。

- 半金融应用:既涉及金钱方面也涉及非金钱方面。例如,为解决计算问题而设的自我强制悬赏。

- 非金融应用:如在线投票、DAO(去中心化自治组织)等不涉及金钱方面的应用。

在区块链2.0阶段,以智能合约为主导,逐渐形成区块链强大的生态系统:各式各样的协议和与钱包相关的项目(瑞波币、SoinSpark)、开发平台和API(blockchain.info)、基于区块链的存储通信与计算(Storj、IPFS)、DApp、DAO、DAC、DAS(去中心化自治社会)。越来越多的金融机构、初创公司和研究团体加入区块链技术的探索行列,推动区块链技术的迅猛发展。

(3)区块链3.0——“可编程社会”

随着区块链技术的不断发展,其不仅可以重塑货币、支付、金融及经济形态等方面,更广泛地看,还可以超越货币和经济,走向政务、科学、社交、文化、工业、艺术等更广大的舞台,这就是区块链3.0阶段。

- 区块链技术从根本上成为低成本、低摩擦、高信任、高效率的新范式,过去大数据应用的核心瓶颈如“数据隐私”“数据孤岛”“数据确权”等,都可以通过区块链加密技术和智能合约技术解决

- 技术信任机制保障资源和价值可以在更大范围内有序流动,实现全球资源和资产的优化配置、

- 政府与市场、政府与社会的关系在新的信息基础设施平台上得以重构

“数字治理”成为国家治理现代化的底层支撑。在物联网、医疗、供应链管理、社会公益等行业不断有新的应用涌现。例如,在智能化物联网应用中,汽车可以自动订购汽油、预定检修服务或清洗服务,冰箱可以自动订购商品,甚至空调和冰箱可以谈判如何错峰用电。我们可以大胆构想,区块链技术将广泛而深刻地改变人们的生活方式,重构整个社会,成为促进社会经济发展的理想框架。

但同样要注意的是,区块链技术虽然有许多潜在的用途和发展方向,但就像互联网没有渗透到生活的所有角落一样,并不是所有的场景都需要点对点交易、公共记录、去中心化等区块链模式,如无须公开的个人信息存储。我们应该理性地看待区块链技术,根据实际的用途和类别有的放矢,才能让区块链技术更好地发展。

区块链分类

区块链技术经历了三次大的技术演进,产生了较为典型的区块链平台,如2009年的比特币、2013年的以太坊、2015年的Hyperledger Fabric和趣链区块链平台。

区块链按照开放程度可分为

- 公有链(Public Blockchain)

- 联盟链(Consortium Blockchain)

- 私有链(Private Blockchain)

三类,这是目前行业内最常见的分类方式。

按照节点准入权限可分为

- 许可链(Permissioned Blockchain)

- 非许可链(Permissionless Blockchain)

其中,联盟链和私有链属于许可链,公有链属于非许可链。其主要特点和区别如下表所示。

公有链是完全开放且去中心化的区块链系统,没有节点准入权限,任何人都可以选择参与链上的事务运作,如链上数据读写、验证和创建区块等。公有链内的网络节点地位平等,不存在中心节点或权限优势的节点,节点无须授权便可自由加入或退出,因此公有链属于非许可链。公有链的典型代表有比特币、以太坊等,它们将共识算法、加密验证与激励机制结合起来,构建节点间的信任,完成区块链数据的验证与读写。公有链的共识算法支持大规模网络和数据扩展,并对算法容错性提出较高要求,如比特币的PoW、PoS等。同时,公有链的稳定运行离不开经济激励,一般通过发行比特币、以太币等Token(代币)来吸引大量节点主动合作,共同维护链上数据的安全。

公有链的优点在于所有数据公开透明、不可篡改,并且链上账户不会与现实身份进行绑定,具有较高的匿名性;但与此同时,由于公有链的共识过程需要大量网络节点共同参与完成,因此造成了其交易吞吐量低且交易速度缓慢的问题,如比特币每秒只能处理7笔交易。基于上述特点,公有链通常适用于完全去中心化、全民监督、全网自治的应用场景,如数字加密货币。同时可以促进DApp发展,有助于推动“可信数字化”时代进步。

联盟链是多中心化的区块链系统,通常由若干实体机构形成一个组织或联盟,并按照一定的规则共同参与记账。联盟链具有严格的节点准入权限,只有经过授权的节点才能加入,其系统维护规则和数据读写权限通常由联盟成员共同协商制定。联盟链的共识过程由预先确定的节点控制,一般不采用资源浪费型的PoW共识算法,而采用分布式一致性算法,如PBFT(Practical Byzantine Fault Tolerant,实用拜占庭容错)、RAFT等。此外,与公有链相比,联盟链通过多中心化的互信达成共识,因而激励机制不是必要选项。

联盟链属于许可链的一种,在交易成本、性能效率、隐私保护、监管审计等方面具有更大的优势,适用于机构间共享数据服务的应用场景,如资产清算、数据可信存证、去中介交易等。典型的联盟链代表有Linux基金会超级账本(Hyperledger)项目、R3区块链联盟Corda项目、趣链区块链平台项目等,目前,基于这些联盟链底层平台开发的应用已经涉及金融、医疗、政务、能源、IoT等领域,并且仍在不断拓展。

私有链是完全中心化的区块链系统,仅对单独的个人、实体或私有组织开放,其数据读写权限由中心机构控制,根据实际需求赋予特定机构,或者选择性地对外开放。和联盟链一样,私有链也是许可链的一种,区别在于私有链的节点准入权限只掌握在单一机构手中。由于私有链的信任机制是由中心机构自行背书的,因而不需要激励机制,私有链在三者中拥有最优的性能表现和最低的交易成本。私有链需要依赖掌控绝对权限的中心机构,其本质和中心化的数据库系统无异,因而面临高权限节点易受攻击、信任缺失等风险,但由于其不可篡改、可追溯的特性,私有链在机构内部的数据库管理、财务审计、办公审批等方面具有较高的应用价值。

对于不同种类的区块链选择,应视具体应用场景而定,

- 侧重于可信度与开放性,对交易速度不苛求的应用场景,公有链更有发展潜力

- 对于更加注重隐私保护、权限控制,对系统性能和监管审计等有较高要求的应用场景,联盟链或私有链更加适用

区块链架构

如下图所示,整体来看,区块链体系技术架构分为基础协议、扩展协议和生态组件。

区块链是融合了分布式存储、点对点网络、分布式一致性算法、密码学算法等多领域、多学科的新型技术,这些技术构成了区块链的技术内核,因此,基础协议包括

- 数据结构与账户体系

- 网络通信

- 共识算法

- 安全体系

- 智能合约

随着区块链应用和技术的不断发展,基础的区块链架构在可扩展性、监管合规化、互操作性等方面的问题逐渐凸显,无法支撑大规模商业应用,由此区块链技术也逐渐发展和裂变,各类技术和机制不断出现,丰富区块链基础内核,这类基于区块链基础内核延伸的技术我们将其归为扩展协议,主要包含

- 针对可扩展性提出的一系列区块链扩容协议

- 针对监管合规提出的治理与审计

- 针对互操作性提出的跨链互操作

- 区块链与物联网

- 大数据等产业融合创新的区块链+

另外,为了加强全景区块链生态构建能力,相应的工具与组件也是必不可缺的,目前,相应的生态组件可以分为

- 方便区块链应用、测试、扩展的工具

- 服务及安全管理。

(1)基础协议

区块链是建立在可信存储机制、点对点网络、共识算法、安全机制、智能合约等基础技术之上的分布式系统,基础协议主要是实现区块链基础功能的组件,包括数据结构与账户体系、网络通信、共识算法、安全体系、智能合约。

1、数据结构与账户体系

根据数据类型和技术架构的不同,区块链底层的存储模型也各有所异。底层的存储涵盖区块数据结构与组织形式、账户体系及账本数据组织形式。

其中,区块数据结构往往大同小异,分为包含一系列校验哈希值的区块头及包含交易的区块体,而区块数据组织形式却各不相同,从最开始的块链式逐步发展到树、图等复杂模式。

除基础的区块数据结构与组织形式之外,账户体系也是区块链底层一种重要的数据结构,常见的有比特币的UTXO模型及以太坊的账户余额模型。

除基础的区块数据结构与组织形式、账户体系之外,能支撑复杂业务的区块链平台往往还涉及账本数据组织形式,账本数据需要通过特殊的组织形式如默克尔树,进行组织和存储,以便快速校验数据的正确性。

2、网络通信

网络通信包含P2P网络、区块链网络模型、区块链网络协议。

区块链网络是典型的P2P网络,涵盖节点验证、节点发现、数据收发等功能。

随着区块链架构的复杂化,逐渐演变出验证节点、SPV节点等节点类型,形成相应的分层区块链网络模型。

同时,针对网络节点自发现、大规模组网等需求,区块链网络相应适配了各种不同的网络协议,如Gossip、Whisper、Libp2p等。

3、共识算法

共识算法是用于保证分布式系统一致性的算法。区块链是典型的分布式系统,所有节点都独立完成数据计算和存储,需要共识算法来确保各节点的一致性。这里的一致性可以是交易顺序一致性、账本一致性、节点状态一致性等。共识算法往往由传统分布式一致性算法演变而来,如RAFT、PBFT等,也有针对区块链架构提出的典型共识算法,如PoW、PoS、DPoS等,随着区块链技术的不断发展,新型共识算法不断被提出,如Casper、Algorand、Hotstuff等。

4、安全体系

区块链系统有着很高的安全性要求,所涉及的身份认证、节点连接、通信传输、数据存储等方面都需要相应的核心安全技术;同时对隐私性有一定的要求,可以概括为身份隐私保护技术和数据隐私保护技术。其中,核心安全技术涵盖哈希算法、数字签名、密钥协商、对称加密及PKI证书体系,身份隐私保护技术包括盲签名、环签名、群签名等;数据隐私保护技术涉及账本隔离、账本加密、密态计算与验证等多种机制。

5、智能合约

智能合约是区块链业务逻辑的载体,完成编译部署后,可按照智能合约预设的条件和逻辑完成业务执行。

智能合约包含承载区块链业务逻辑的智能合约脚本、智能合约执行引擎及分布式应用。

(2)扩展协议

随着区块链技术与应用的快速发展,区块链基础架构在性能、安全性、可扩展性等方面的瓶颈逐渐凸显,由此涌现出一系列新的技术机制,作为基础架构的扩展,丰富区块链的落地能力。

- 针对区块链的性能和存储瓶颈,演化出链上扩容和链下扩容

- 针对安全合规问题,相应提出治理与审计

- 针对互操作难题,提出跨链互操作

- 针对区块链与现有技术和应用的可信增强与融合,相应提出区块链+

1、扩容协议

区块链扩容最终是为了解决性能瓶颈(交易吞吐量)和存储容量瓶颈。

扩容一直以来都是区块链行业亟待解决的难点问题,相应涌现了一系列技术手段,以提升其可扩展性。

目前,扩容方案整体上分为链上扩容和链下扩容。其中,

- 链上扩容包括区块扩容、并行扩容和架构扩容。

- 区块扩容通过提高区块大小上限,增加写入单个区块的交易数量,从而提高交易吞吐量,常用于比特币等公有链场景

- 并行扩容在原有架构的基础上,增加子链、并行链分担部分交易处理,通过并行执行的形式,提高交易吞吐量,支付通道、分片等都是并行扩容的技术手段

- 架构扩容通过新型的区块链架构达到交易扩容的目的。例如,基于DAG(Directed Acyclic Graph,有向无环图)的区块链架构可以有效提高交易吞吐量

- 链下扩容也称为第二层扩容。区别于链上扩容,链下扩容的主要思想是在不改变主链本身架构的情况下新增一层通道,实现功能与性能的扩展,主要包括侧链技术、状态通道和链下协同。

- 侧链技术将一条具有更好性能的侧链与主链连接起来,实现跨链资产转移,同时将复杂的业务逻辑在侧链中执行,主链承担结算任务,从而分担主链压力,提高区块链整体的交易速度,侧链的主要模式有中间人托管模式、驱动链模式和SPV模式

- 状态通道是一种将部分事务处理逻辑转移到链下进行的技术,与侧链技术不同的是,状态通道的实现更轻量级,在链上打开一条通道即可进行逻辑处理,不需要额外搭建一条侧链,主要模式有闪电网络、雷电网络

- 链下协同的主要思想是将链上不方便存储和计算的数据放到链下进行存储和计算,通过映射关系保证链上链下的协同和一致性,主要模式有链下存储、链下计算,可以有效提高主链的性能。

2、治理与审计

与中心化应用不同,区块链去中心化、不可篡改等特性与实际工程友好性存在矛盾,缺乏有效的运维管理及完善的治理模式,同时面对难以监管的困境。

在区块链治理方面,公有链基本维持通过开源社区来对区块链进行维护的现状;而联盟链的用户多用区块链即服务(BaaS)平台,通过将云计算和区块链进行结合,采用容器、微服务及可伸缩的分布式云存储技术等创新方案简化区块链系统的部署和运维管理,同时,自动化运维和自治治理成为区块链行业研究的重点方向。中国人民银行于2020年2月发布《金融分布式账本技术安全规范》,在业内被视为区块链在金融行业应用的重要标准。如何通过有效审计来保障链上资产的安全性及业务运行的合法、合规性是区块链行业发展的重点问题。

治理与审计的整个实施路径涵盖权限体系、治理模型、审计和Baas运维治理。其中,

- 权限体系可以针对链级权限、节点权限、用户权限等维度进行权限控制

- 治理模型可以分为链上治理、链下治理及链上链下协同治理

- 审计则针对节点共识历史、账本数据校验/同步/变更事件、用户访问操作记录、用户身份变更记录、隐私保护策略、智能合约安全、审计管理员操作记录及业务数据本身内容等展开精确有效的审计工作

- BaaS运维治理是使上述治理过程更加易于管理及可视化操作封装的一层服务,方便业务人员执行区块链权限管理、联盟治理、链上数据审计等操作

3、跨链互操作

随着区块链技术的广泛应用,涌现出各种区块链平台。每条链的共识算法、加密机制等各不相同,导致区块链间的异构性。而异构性使得链与链之间很难做到信息和价值互通,形成区块链生态中的“价值孤岛”效应。

为了打通价值孤岛,需要相应的跨链机制实现跨链互操作。常见的跨链机制有以Ripple为代表的公证人机制,以闪电网络为代表的哈希锁定机制,以BTCRelay为代表的侧链机制,以及以Cosmos、Polkadot、BitXHub为代表的中继机制。

4、区块链+

区块链具有去中心化特性、身份验证功能及可靠的链式存储结构,可以通过区块链+赋能众多分布式系统的使用场景,解决它们之间面临的问题。

- 在区块链+物联网行业,区块链可以解决物联网设备管理困难、数据传输成本过高、隐私保护不完善,以及设备间数据安全共享等问题

- 在区块链+大数据行业,区块链的账本不可篡改存储机制、共识算法和密码学算法可以为大数据的存储、计算及数据资产化流通提供增信功能

- 在区块链+工业互联网行业,随着工业4.0时代的逐步推进、智能制造的日渐兴起、工业化与信息化的日益融合,工业互联网正在全球范围内进行人、机、物间高度互联的新一轮技术革命,而区块链技术可以帮助提升工业互联网的适用性、安全性及智能性。

(3)生态组件

为了加强区块链生态构建能力,需要为应用、测试、扩展服务提供相应的生态工具与服务,如促进链上链下信息交互的消息队列MQ、支撑数据可视化的大数据分析、统一的区块链测试框架、运维操作、IoT云平台等。

辅助区块链系统进行安全管理的组件也必不可少,如基础的密钥管理、证书管理、漏洞检测及适用于监管的舆情检测等。

区块数据结构与组织形式

不同主流区块链系统中的数据结构不尽相同,但思路上大体类似,本节将对区块数据结构与组织形式进行介绍。

(1)区块数据结构

交易是区块链中最基本也最重要的数据结构。每笔交易中都封装了参与方之间的一次转账操作,经过验证的合法交易将被执行,并保存在区块链中,交易的执行是驱动区块链系统发生状态迁移的唯一途径,而区块是存储交易及相关元数据的数据结构。

如下图所示,一般来说,区块可以分为区块头和区块体两部分,区块头存储该区块的元数据,区块体存储所有实际的交易结构。

1、区块头

在区块头(Block Header)中,区块哈希是对区块头进行两次SHA256(Secure HashAlgorithm,安全散列算法)运算得到的结果,区块哈希可以唯一地标识一个区块。父区块哈希为当前区块的前驱区块的哈希值,通过在区块头中存储该字段形成一种区块间的链式结构。

除区块哈希外,区块高度(Block Height)也可以用来标识区块,之所以称为“高度”,是因为我们往往将区块链视为一个垂直的栈式结构,栈底为0号区块,挖矿产生的新区块将不断加入栈顶,截止到2020年5月18日,比特币的区块高度已经到达630778。不同于区块哈希,区块高度有时无法唯一地标识某一个区块,出现这种情况表明区块链产生了分叉(Fork)。

在比特币中,默克尔根是通过特定算法对区块内所有交易进行计算得到的哈希值,以太坊和Hyperledger Fabric的区块头中除了包含交易的默克尔根,还包含一个针对账本状态的默克尔根。此外,以太坊还包含一个针对交易回执的默克尔根。

在比特币与以太坊这类基于PoW共识算法进行共识的公有链中,区块头还包含如难度、随机数等与共识过程相关的字段,此外,以太坊为了支持智能合约的执行,在区块头中加入了与Gas相关的字段,

2、创世区块

区块链中的第一个区块称为创世区块(Genesis Block),我们可以通过查找高度为0的区块或以下区块哈希值定位到比特币的创世区块

000000000019d6689c085ae165831e934ff763ae46a2a6c172b3f1b60a8ce26f

由于创世区块不存在任何的前驱区块,因此创世区块的结构总被静态编码在比特币客户端中,比特币创始人中本聪在创世区块的第一条交易(CoinBase)中隐藏了如下信息:“The Times 03/Jan/2009 Chancellor on brink of second bail‐out for banks.”,这是创世区块产生当天《泰晤士报》的头条报道,也是中本聪对当时脆弱的金融系统的暗讽。

(2)区块数据组织形式

1、链式

链式结构是最常见的一种区块数据组织形式,任意一个区块(除了创世区块)都可以通过区块头中的父区块哈希索引到上个区块,从而回溯到创世区块,如下图所示。当新区块被矿工发送至网络时,节点会验证该区块的父区块哈希是否与本地最新区块的区块哈希一致,若一致则将其加入本地区块链。

由于区块头中包含默克尔根,因此通过哈希算法可快速验证某个区块是否遭受了篡改;又因为区块头中包含父区块哈希,因此区块链中任意一个区块的篡改都会导致后续所有区块的改变。

2、DAG式

在IOTA区块链项目中使用DAG或新型区块链结构Tangle。

Tangle摒弃了区块的概念,用交易作为DAG的节点,DAG以创世交易(Genesis Transaction)为起点展开,每当有新交易发布到网络中时,网络参与方都会尝试验证DAG中至少一个末端节点(Tip)交易的合法性,并在验证通过后将新交易指向末端节点,由于除创世交易外的每笔交易都遵循这样的验证逻辑,因此可以确保从创世交易开始一直到最新交易路径上的所有交易都是经过验证的。

如下图所示,在加入6号交易时,选择4号和5号交易进行验证,若验证通过,则证明1~5号交易都是经过验证的。

账户体系

区块链中的账户体系主要分为以资产为核心建模的UTXO模型和以用户为核心建模的账户余额模型两类,本节将对这两种账户体系进行介绍。

(1)UTXO模型

UTXO(Unspent Transaction Output)模型是比特币引入的模型,本节首先通过一个例子对UTXO流程进行介绍,随后对相关概念进行详细介绍。

下述例子仅展示UTXO的思想,其中的比特币金额不与实际情况对应。如下图所示,

- 张三通过挖矿成功获得了10个比特币的奖励

- 随后张三准备向李四转账5个比特币,因此张三构建了一笔包含1个输入和2个输出的交易(如交易A所示),其中,输入来自张三的挖矿所得,一个输出进入李四的账户,另一个输出作为找零回到张三的账户,交易A执行完成后,张三和李四各拥有5个比特币的UTXO

- 在交易B中,张三向李四转账2个比特币,向王五转账3个比特币

- 在交易C中,李四使用来自张三的输出,向王五转账5个比特币,在这两笔交易执行完成后,张三花光了所有的比特币,李四与王五分别拥有2个和8个比特币的UTXO

- 在交易D中,王五使用张三与李四转给自己的3个和5个比特币的输出,进行后续的花费,交易D执行完成后,张三、李四与王五分别拥有0个、2个和0个比特币的UTXO

1、CoinBase

在比特币中,挖矿成功的矿工将得到一笔奖励,这笔奖励一部分来自打包交易的手续费,另一部分就是来自CoinBase。区块中的第一笔交易称为CoinBase交易,该交易以CoinBase为输入,以矿工的比特币地址为输出,这笔交易的执行将使该矿工的比特币地址凭空多出若干个比特币。在上述示例中,张三便是通过CoinBase交易获得的挖矿奖励。

2、输入和输出

交易中的每个输出都是一定数量的不可分割的比特币,这些输出由全网共同验证,并且可能被其持有者用作后续交易的输入。

比特币全节点(Full Node)会追踪和统计网络中所有可用的交易输出,我们称这些交易输出为UTXO集合,即所有“未花费的交易输出”。当我们称一位用户拥有多少比特币时,实际上指的是比特币网络中有多少UTXO可以被该用户控制的密钥使用,而这些UTXO可能分散在成千上万的区块和交易中,比特币钱包帮我们做收集和计算的工作,将这些UTXO的总额以账户余额的形式呈现给用户。

在上述示例中,交易B、C执行完成后,张三、李四和王五分别拥有0个、2个和8个比特币的UTXO,这样的账户余额呈现是比特币钱包对这三位用户可花费的交易输出进行全网追踪和统计后的结果。

交易的输出可以是任意数量的Satoshi(比特币的最小计量单位),值得注意的是,每个输出都是离散且不可分割的,这意味着输出一旦生成,只能作为一个整体被使用。在使用UTXO时,若某个UTXO金额大于这次交易应付的价格,那么该UTXO将作为一个整体被使用,并且产生两部分输出:一部分支付给交易接收方,另一部分作为找零支付给自己,如上图中的交易A;若该用户没有单独的UTXO支付这笔交易,那么比特币钱包将以一定的策略对用户的UTXO进行挑拣和组合,共同作为这笔新交易的输入。

通过使用比特币网络中现存的交易输出,不断生成可被后续交易使用的新输出,比特币系统在消耗和生成UTXO的过程中实现了在不同参与方之间转移的价值。

值得注意的是,在CoinBase交易中并不存在实际的输入,因此可以认为比特币网络是先有输出,再有输入的。从经济学层面理解,CoinBase是凭空产生的货币,它可以理解为为了支撑上层价值/信用社会的必要成本。

(2)账户余额模型

相对于UTXO模型,账户余额模型更符合我们的直观理解,因为账户余额模型与现实生活中的银行账户类似。银行系统直接记录每个账户的余额,在进行交易时,首先判断发起方的余额是否充足,若充足则进行交易双方的余额变动。

下图展示了基于账户余额模型的转账流程,我们可以看到,交易中记录了发起方地址、接收方地址与转账金额,因此每方的账户余额都是一个全局变量,交易的执行直接对转账双方的余额进行操作。

以太坊(Ethereum)是使用账户余额模型的典型代表,其账户类型可以分为外部账户与智能合约账户两种。

1、外部账户

外部账户(External Owned Account,EOA)是由用户创建的账户,用户通过一组密钥对来控制外部账户,拥有了私钥即拥有了账户的拥有权。在发送以太坊交易时,用户需要使用其私钥对交易进行数字签名,以证实交易的有效性。

2、智能合约账户

智能合约是一段可执行代码,而智能合约账户是存储这段代码的账户。智能合约账户不存在相关的密钥对,无法主动发起交易,所以外部账户是与以太坊交互的唯一媒介。当外部账户向智能合约账户发起交易时,执行该智能合约账户中的智能合约,由于以太坊使用图灵完备(Turing Complete)的虚拟机EVM来执行智能合约,因此用户可以引入足够复杂的逻辑来实现各种丰富的功能,如多重签名、权限控制等。

(3)模型对比

上文对现阶段广泛采用的两种账户体系进行了介绍,本节将对混合模型进行介绍,随后进行模型之间的对比。

1、混合模型

有些区块链项目提出将UTXO模型与账户余额模型进行结合。以量子链(Qtum)为例,其在负责智能合约执行的虚拟机层与负责转账操作的UTXO层之间加设了一层账户抽象层(Account Abstract Layer,AAL),通过AAL对UTXO账户与智能合约账户进行适配和转换,实现UTXO模型与账户余额模型的优势互补。

2、优劣对比

下表给出了UTXO模型与账户余额模型在建模对象、适用场景、隐私性与并行度这几个角度的优劣对比。

- 建模对象。UTXO模型首先构建“代币”的概念,再为代币赋予所有权,用户可以自由、直接地操作其拥有的代币。因此,UTXO模型是以资产为基础进行建模的;而在账户余额模型中,用户的余额背后并不存在真实的代币进行支撑,用户只能对账户进行操作。因此,账户余额模型是以账户为基础进行建模的。

- 适用场景。UTXO模型中并不存在“账户当前状态”的概念,所有状态都以UTXO的形式保存在交易中,我们称UTXO模型是无状态(Stateless)的。因此,难以基于UTXO模型构建转账、货币发行等数字货币领域之外的复杂应用(如智能合约);而在账户余额模型中,外部账户拥有账户余额等状态数据,智能合约账户拥有智能合约变量等状态数据,我们称账户余额模型是有状态(Stateful)的。因此,基于账户余额模型可以进行丰富的编程应用。

- 隐私性。在UTXO模型中,如果用户为每笔收到的交易都使用新的地址,那么这些交易将很难关联到该用户上,提高了用户的隐私性。不过由于区块链应用往往需要追踪某一用户的各种状态,因此这种隐私性可能只在电子货币领域有用武之地;而在账户余额模型中,账户的各种状态与账户地址直接关联,其隐私性相对较弱。

- 并行度。在UTXO模型中,交易的输出都是不可分割的独立UTXO,因此比特币持有者可以选择不同的UTXO构建交易,这些交易是互不影响、可并行执行的;而在账户余额模型中,账户余额是一个全局的世界状态,因此若多条交易涉及同一个账户的改变,那么这些交易将无法并行执行。

账本数据组织形式

在区块链中,数据主要分为两大类:区块数据和账本数据,之前已经介绍了区块数据组织形式,本节将介绍账本数据组织形式。

(1)默克尔树

默克尔树(Merkle Tree)又称为二叉哈希树(Binary Hash Tree),是一种用来快速计算摘要和验证一批数据完整性的数据结构。在比特币中,通过默克尔树对区块中的所有交易进行计算、汇总,可以得到一个唯一标识这批交易的哈希值,该哈希值为默克尔根(Merkle Root)。比特币采用连续两次的SHA-256运算作为基本的哈希计算,本节将通过一个例子来介绍默克尔树的工作流程。

如下图所示,假设在某个区块中,有A~G七条交易,首先,分别对这些交易进行哈希计算,得到Hash-A~Hash-G七个哈希值,这些哈希值将作为默克尔树的叶子节点。值得注意的是,由于默克尔树又称为二叉哈希树,其必须拥有偶数个叶子节点,因此我们将重复使用最后一笔交易的哈希值,即Hash-G。

随后,对相邻叶子节点的哈希值进行字符串拼接,对拼接后的结果进行一次哈希计算,将计算的结果作为该相邻叶子节点的父节点。在下图中将Hash-A与Hash-B进行字符串拼接,对拼接后的结果进行两次哈希计算,可得到Hash-AB。重复这一过程,直到默克尔树的最顶层只剩下单个节点,即默克尔根。

默克尔根是一个长度为32的字节数组,无论区块中有多少笔交易,任何一笔交易的篡改都会造成默克尔根的变动,因此默克尔根总能唯一地标识每笔交易。

默克尔树能够快速验证一笔交易是否存在于某一批交易中,因此被广泛应用于简单支付验证(Simple Payment Verification,SPV),即正向验证准确性

若不使用默克尔树,则验证一笔交易是否存在于某一批交易中的直接做法是直接遍历、一一比较(确认该批交易没有遭到篡改、确认存在于该批交易中),这会带来与交易数目呈正比的时间复杂度;若使用默克尔树,则时间复杂度会降低至交易数目的对数级别。

如下图所示,若要验证TX-F是否存在于这批交易当中,只需要提供Hash-E、Hash-GG、Hash-ABCD三个哈希值,通过三次哈希计算判断默克尔根是否一致,我们称由TX-F一直到默克尔根的这条路径为默克尔路径(Merkle Path)。

通过默克尔树,我们将存在性证明的复杂度降低到了log级别,极大地优化了存在性证明的计算性能。

默克尔树能够快速查找到两个区块的merkle treee中不同的交易,即逆向定位错误

已上图为例,假设A和B机器中,TX-F不一样,这个比较检索过程如下:

- Step1:首先比较Hash-ABCDEFG是否相同,如果不同,检索其孩子Hash-ABCD和Hash-EFGG.

- Step2:Hash-ABCD相同,Hash-EFGG不同。检索Hash-EFGG的孩子Hash-EF和Hash-GG;

- Step3:Hash-EF不同,Hash-GG相同,检索比较Hash-EF的孩子Hash-E和Hash-F

- Step4:Hash-E不同,Hash-F相同。Hash-E为叶子节点,获取其目录信息。

- Step5:检索比较完毕。

以上过程的理论复杂度是Log(N)。

之所以要逐层走完所有节点,进行哈希验证,目的是为了找到导致默克尔树根变化的根节点(problem root cause),因为根节点的哈希发生变化,可能存在以下几种情况:

- 待检测的叶子节点遭到篡改,即待验证的交易不在该批交易中

- 包括待检测的叶子节点在内,还有其他的叶子节点也遭到篡改

- 待检测叶子节点之外的其他节点遭到篡改

通过逐层二叉分治的原因定位,可以完整筛查出存在错误的所有交易节点。

默克尔树能够快速验证整批交易在传输过程中是否遭到篡改和数据损坏,即进行完整性校验

在构造Merkle树时,首先要对数据块计算哈希值,通常,选用SHA-256等哈希算法。但如果仅仅防止数据不是蓄意的损坏或篡改,可以改用一些安全性低但效率高的校验和算法,如CRC。然后将数据块计算的哈希值两两配对(如果是奇数个数,最后一个自己与自己配对),计算上一层哈希,再重复这个步骤,一直到计算出根哈希值。

在构造Merkle树时,首先要对数据块计算哈希值,通常,选用SHA-256等哈希算法。但如果仅仅防止数据不是蓄意的损坏或篡改,可以改用一些安全性低但效率高的校验和算法,如CRC。然后将数据块计算的哈希值两两配对(如果是奇数个数,最后一个自己与自己配对),计算上一层哈希,再重复这个步骤,一直到计算出根哈希值。

在分布式环境下,从多台主机获取数据,怎么验证获取的数据是否正确呢,只要验证Merkle树根哈希一致,即可。

例如,下图中L3数据块发生错误(比如数据被修改了),错误会传导到计算hash(L3),接着传导到计算hash(Hash1-0+Hash1-1),最后传导到根哈希,导致根哈希的不一致,可以说,任何底层数据块的变化,最终都会传导到根哈希。另外如果根哈希不一致,也可以通过Merkle树快速定位到导致不一致的数据。

(2)MPT

MPT(Merkle Patricia Tree,默克尔帕特里夏树)即默克尔树与帕特里夏树(PatriciaTree)结合的数据结构。MPT是以太坊采用的账本数据组织形式,以太坊中的状态数据、交易数据、交易回执数据会被组织成相应的三棵MPT,这三棵MPT的根节点哈希值(StateRoot、TransactionRoot、ReceiptRoot)会被保存在区块头中。

本节首先介绍Patricia树的概念,随后以一个具体的例子对MPT的构建流程进行介绍。

1、Patricia树

Patricia树是Trie树的升级版本,Trie树又称为前缀树或字典树,Trie树中的数据不是直接保存在某个节点中,而是通过共享公共前缀的方式进行组织,即任何一个节点的子孙节点都拥有相同的前缀。如下图(a)所示,Trie树中以7个节点存储了“team”“to”“so”“stop”4个单词,但这似乎并不是一种空间友好型数据结构,Trie树的最大优点是可以最大限度地减少查找过程中的字符串比较。若数据集中存在大量相同前缀的数据,那么Trie树可以在节省大量存储空间消耗的同时,带来相当高的数据查询效率;若数据集中的数据几乎没有共同前缀,那么Trie树的数据查询效率将变得非常差。

Patricia树对没有共同前缀的数据进行优化组织,若一个节点只拥有一个子节点,那么该节点将与子节点进行合并。对于相同的数据集,Patricia树的结构如图(b)所示。

2、MPT节点类型

MPT中包含扩展节点、叶子节点与分支节点三类,这三类节点内都包含一个“节点标识”字段,用于存储与计算节点哈希值,以及节点在内存中的淘汰策略。除此之外,这三类节点拥有以下特性。

- 扩展节点(Extension Node):存储本节点所属的Key的范围,以及一个指向其他节点的Value字段。

- 叶子节点(Leaf Node):与扩展节点的结构基本相同,只不过叶子节点不指向其他节点,其Value字段存储的是一个数据项的内容。

- 分支节点(Branch Node):用于表示MPT中拥有超过一个子节点的非叶子节点。为了防止Key的范围过大,MPT首先通过某种编码方式使Key的每位都通过十六进制进行标识,从而一个分支节点最多可以拥有十六个子节点,也可以拥有一个存储自身数据的字段。

3、MPT的构建

我们通过向一棵空MPT插入4个Key-Value对来看MPT是如何构建的。首先,插入一条Key为“a711355”,Value为“45.0”的记录,此时的MPT结构如下图所示。由于MPT中只有一个节点,因此这个节点为叶子节点。

其次,插入一条Key为“a77d337”,Value为“1.0”的记录,如下图所示。显然,这条记录与上一条记录拥有共同的前缀“a7”,因此MPT在此处出现了分支,并且由两个叶子节点分别存储两条记录无法共享的后缀。

然后,插入一条Key为“a7f9365”,Value为“1.1”的记录,同样,该记录与上两条记录拥有共同的前缀“a7”,因此可以直接成为现有分支节点下的一个新叶子节点,如下图所示。

最后,插入一条Key为“a77d397”,Value为“0.12”的记录,该记录与MPT中“a77d337”记录拥有最长的共同前缀“a77d3”,因此,上图中的第二个叶子节点就成为一个扩展节点,代表这两条记录在第六位上产生的分叉,最终的MPT结构如下图所示。

(3)增量哈希

使用树形结构对区块链数据进行组织固然能带来许多优势,但在读写操作的性能及存储表现上,树形结构显然不是那么优秀,因此一些区块链项目摒弃了树形结构,直接将数据以Key-Value对的形式进行存储。

这种方法带来的最主要的问题是如何验证当前区块链状态的正确性。直接方法是遍历数据库中所有账户数据,并对这些数据依次进行哈希计算,最后得到一个代表当前区块链的状态哈希值,然而若每次出块都遍历整个数据库,则会带来巨大的磁盘IO开销,因此这种方法并不可取。

所谓增量哈希,其实就是对上个区块的增量哈希值加上新区块执行过程中产生的修改集进行哈希计算,将其结果作为新区块的状态哈希值。

举例来说,若在创世区块中创建了50个账户,则创世区块的状态哈希值就是这50个账户的哈希值,记为H0;在1号区块中,20个账户的余额或智能合约变量发生了变动,则1号区块的状态哈希值为

运行流程

交易是区块链系统对外界业务场景进行响应和处理的最小单元。一般来说,区块链中的交易会导致区块链系统中的价值转移。另外,在目前的企业级区块链系统中,交易可以通过对智能合约的部署和调用,进行复杂业务逻辑的部署和执行。

(1)运行流程概述

目前,主流区块链系统采用的交易流大体上可分为两类,

- 一类为以太坊、趣链区块链平台中的先定序后执行模式

- 一类为Hyperledger Fabric中的先执行后定序模式

这里的交易定序指的是由共识模块对交易进行排序和打包。

1、先定序后执行

下图为以太坊交易运行流程。一般来说,交易生命周期包含如下步骤。

- 交易生成。由用户在客户端(SDK)构建一笔区块链交易,附上可证明交易正确性的私钥签名,向某个区块链节点发送这笔交易。

- 交易广播。节点在收到上述交易并验证私钥签名的正确性后,向全网节点广播这笔交易。

- 交易共识。共识节点(挖矿节点)在收集了一定数量的交易,或者收集了一段时间的交易后,将交易按照手续费高低进行排序并打包,随后进行挖矿。挖矿成功的节点将广播这批交易。

- 交易执行。节点在收到这批交易后,依次执行其中的交易。值得一提的是,以太坊不仅支持直接的转账操作,还支持智能合约的部署与调用,后者的执行过程将在节点的虚拟机中进行。

- 交易存储。在这批交易全部执行完成后,节点对执行结果进行构造,并将相应的区块数据、账本数据写入数据库。

2、先执行后定序

如下图所示,Hyperledger Fabric交易运行流程大致可以分为以下几个步骤。

- 交易提案。用户在客户端生成一笔交易提案,提案中包含本次需要执行的链码(Hyperledger Fabric中的智能合约)信息,用户对提案进行私钥签名后将其发送给一个或多个Peer(背书)节点。

- 交易背书与执行。Peer节点对提案进行以下验证:(1)格式完整;(2)该提案未被执行过;(3)提案私钥签名正确;(4)提案发起方有足够的操作权限。在验证通过后,基于当前账本状态对相应的链码进行交易执行,生成一个读写集(本次交易执行读取了哪些数据,更新了哪些数据),但此时区块链账本状态并不会被更新。最后将提案的执行结果,连同节点自身的私钥签名一起返回给客户端,完成本节点对这次提案的交易背书。

- 背书检查。客户端在收到一定数量的提案结果后,对它们的合法性进行检查,并判断本次交易提案是否满足背书策略(有来自足够数量的Peer节点的背书),随后根据提案结果生成一笔交易发送至Order(排序)节点。

- 交易定序。Order节点监听网络中来自不同客户端的交易,并按照一定的规则将其打包成区块,在收集了一定数量的交易,或者收集了一段时间的交易后,将区块广播至所有Peer节点。

- 交易提交。Peer节点在收到区块后,依次应用每条交易中的读写集到世界状态,在这之前,Peer节点还需要验证交易背书是否满足背书策略。

- 交易存储。Peer节点在提交完区块后,将相应的区块数据、账本数据写入数据库。

值得一提的是,Hyperledger Fabric并不是将交易的执行结果直接应用于状态机,而是以读写集(Read-Write Set)的形式记录这些执行结果。如下图所示,HyperledgerFabric的每笔交易都会记录其对状态数据的读取情况和即将对状态数据造成的修改,这里对状态数据的读取情况指在预执行过程中,访问到的每条数据对应的版本信息,即产生于哪个区块的第几笔交易,所有状态数据的读取情况的总和构成这笔交易的读集;而即将对状态数据造成的修改指即将写入数据库的数据信息,一旦这笔交易验证通过,写集中的数据在持久化到数据库时就会附带上版本信息。这些修改信息的总和构成这笔交易的写集。

简单来说,读集和写集组成了一笔交易的读写集。Hyperledger Fabric会将交易发送给Peer节点,Peer节点在收到该交易后会访问数据库,根据交易指定的逻辑完成对交易的预执行,得到该交易对应的读写集,并将读写集返回给客户端,客户端接收到读写集后可完成交易的生成。

(2)交易的生成

一般来说,用户通过区块链生产厂商提供的客户端进行交易的生成与发送,下表展示了以太坊交易字段及其含义。

- From字段标识了一笔交易的发起方地址,一般一个以太坊客户端会管理多个账户,From字段在以太坊中主要用于使客户端明确发起交易的账户,而不会被真正写入交易并发送到以太坊网络中,这是因为发起方地址可以通过签名方的公钥进行恢复。

- To字段标识了转账的目标账户,或者要操作的智能合约对应的智能合约账户,若该字段为空,则意味着智能合约被部署。

- Nonce字段是一个连续增长的整数,用于标识特定账户已经发送到以太坊网络中的交易数目。一方面,Nonce字段的存在可以保证矿工在打包交易时能够确定来自相同账户的交易顺序,考虑如下场景:张三计划发起两笔交易,并希望第一笔交易可以先于第二笔交易被打包,由于区块链网络的异步性,此时若没有Nonce字段的存在,则张三只能先发送第一笔交易,等到确认这笔交易被打包后再发送第二笔交易,否则无法确定矿工收齐这两笔交易的先后顺序,而事实上张三只需要递增这两笔交易的Nonce值,矿工即可对交易进行正确排序;另一方面,Nonce字段可以解决数字货币中著名的“双花问题”,即若没有Nonce字段,则矿工无法判断自己是否打包过某笔交易,从而导致恶意用户可以不断复制一笔交易并发送至网络中,使这笔交易被反复执行。

- 以太坊出于矿工激励策略与系统稳定性的考虑设置了Gas机制,根据以太坊黄皮书,一次账户余额的变更、一次哈希计算、任何智能合约的执行等都需要消耗一定量的Gas,如果Gas消耗超出这笔交易发起方指定的数目,则撤销这笔交易,且其造成的所有对区块链状态的改变都将被回滚。一方面,交易执行中消耗的Gas都将为矿工所得,激励矿工为网络的良好发展不断贡献算力;另一方面,防止用户在智能合约潜在的漏洞中对区块链系统造成有意或无意的破坏(如智能合约中的死循环造成全网节点的瘫痪)。具体来说,Gas在交易结构中体现为GasPrice与GasLimit,前者指明了Gas与以太币之间的转换比例,后者为交易发起方愿意为这笔交易的执行支付的Gas上限。当然,对矿工来说,越“值钱”的交易会越早被打包。

- Data字段一般和智能合约有关。一般来说,智能合约调用交易中的Data字段包含调用方法的标识和需要传入的参数,智能合约部署交易中的Data字段主要包含智能合约经编译后的字节码。以太坊虚拟机会按照交易特点解析Data字段中的内容,并进行相应的操作。

- 交易签名可以保证交易的完整性与真实性。交易签名的一般流程是对交易整体计算摘要后,使用交易发起方账户的私钥对交易摘要进行签名。交易签名采用非对称加密算法,如传统椭圆曲线签名算法,许多国产区块链系统也支持国密算法SM2

(3)交易传播与验证

每个节点在收到一笔交易后都会进行有效性验证。一般来说,这一步是验证交易签名是否合法,以保证交易在整个生成到传播的过程中没有被篡改过。交易签名验证的方式与在其他场景下签名的验证方式基本没有区别,首先,计算交易摘要;然后,使用交易发起方账户的公钥对签名进行解密,得到发送方发送时的交易摘要,若二者相等,则交易验证通过。

以比特币为代表的基于UTXO模型的区块链平台一般采用锁定脚本和解锁脚本的方式保证交易的有效性,其将一系列操作数和指令以脚本的形式附在交易中,若这些脚本执行得到期望的结果,则验证通过。

接收到这笔交易的节点会将这笔交易广播到区块链系统中的每个节点上。对于大规模网络,区块链系统一般不与全网节点建立全连接,而采用Gossip等P2P协议,将交易广播给逻辑或物理上的“邻居”,然后由“邻居”完成进一步的交易广播;相反,对于小规模、节点较少的私有链或联盟链场景,可以采用全连接的P2P网络,每个节点都可以一次性完成所需信息的广播任务。

区块链节点在接收到来自客户端或其他节点的交易后,会将交易暂存到本地交易池(Transaction Pool),用于后续的共识定序和区块生成。一般来说,区块链节点会提供两种交易池,一种用于暂存可供用户生成区块的交易(Pending Pool),另一种用于暂存用户暂时无法生成区块的交易(Queued Pool)。为保证执行效率,区块链系统的交易池都是一段内存空间,不会占用持久化存储设备的空间和IO。

在前面对Nonce字段的介绍中提到,矿工需要依照Nonce值按序打包同一用户的所有交易,由于区块链网络存在异步性,无法对交易到达矿工的先后顺序做出假设,因此,对于未按序到达的交易,矿工先将其暂存到Queued Pool,而对于按序到达的交易,则将其暂存到Pending Pool。

Pending Pool中的交易会被进一步打包用于生成区块,区块的生成规则遵循区块链底层采用的共识算法。

- 在采用PoW共识算法的比特币或以太坊中,矿工为了最大化自己的利益,会优先挑选交易池中手续费更高的交易进行打包,为防止手续费低的交易“饿死”,随着交易的等待时间不断变长,交易的优先级会得到提升;在完成交易的打包且成功解出PoW共识算法之后,矿工将这批交易广播至全网节点,并由全网节点进行验证和执行。

- 在采用BFT类算法的趣链区块链平台中,由于不存在任何激励机制,因此往往由一个事先选举的节点进行交易的打包,打包时按照先来先服务等较为公平的策略进行交易的选择。在完成交易打包后,将这批交易广播至全网节点进行后续的共识流程。

打包好的交易将用于区块的生成。在目前常用的企业级区块链系统中,一般有专门的主节点对内存中的交易进行排序和打包,随后将打包结果同步给其他参与方,各个参与方进行必要的执行等操作获取其他区块的相关信息(例如,交易执行过程完成对世界状态的修改后,会生成最新的世界状态哈希)后,即可成功生成区块。对于这样的区块链系统,所有正常工作的节点均会生成一致的区块,不会出现相同区块高度的区块不一致的情况。

而在以比特币为代表的公有链中,不同的矿工可能会产生不同的打包结果,生成不同的区块,即出现分叉,比特币网络的节点根据共识机制解决分叉问题。

(4)交易的执行

节点在接收到一批交易并验证其合法性之后,便开始依次执行其中的交易。节点根据交易中的To字段判断这笔交易是转账交易还是智能合约交易。若为后者,则取出交易中的Payload字段,交由虚拟机进行智能合约的执行。

在采用BFT类算法的联盟链中,由于同一时刻只有一个节点在打包,因此所有正常节点在任意区块高度都执行相同顺序的交易,这保证了这些节点的状态总是发生一致的变迁。

区块链的网络层封装了区块链系统的组网方式,包括节点间的组织形式、数据传输方式等。本章将重点介绍区块链网络层的拓扑结构、网络协议及网络中不同的节点类型。

P2P网络

P2P是“peer-to-peer”的缩写,peer在英语里一般是同伴、同事的意思,因此P2P网络通常被称为对等网络,网络中的每个节点被称为对等节点。在P2P网络中,每个节点的地位都是对等平权的,既能作为服务的请求者又能为其他节点提供服务。

P2P网络打破了互联网中传统的客户端/服务器端结构,使每个节点都具有不依赖中心服务器,自由、平等通信的权利。

P2P网络的发展到目前为止经历了四个阶段:

- 集中式

- 纯分布式

- 混合式

- 结构化

每个阶段都代表一种P2P网络模型,主要的区块链平台大多采用混合式和结构化P2P网络模型来构建。

目前,在学术界和工业界对P2P网络没有一个统一的定义,不同的研究学者和机构分别给出了P2P网络不同的定义,这些定义之间并不矛盾,均从不同角度反映了P2P网络的内在特点。一般来说,P2P网络具有如下特点。

- 去中心化。信息的传输和服务都直接在节点间进行,无须中心化服务器的介入。

- 可扩展性。虽然节点的加入增加了对服务的需求,但同步扩充了系统资源的供给和服务能力。

- 健壮性。P2P网络具有高鲁棒性、高容错性的特点,同时,网络拓扑结构可以根据部分节点失效自动调整。

- 负载均衡。在P2P网络中,每个节点既是服务器端又是客户端,同时,资源分布在多个节点上,能够更好地实现网络的负载均衡。

- 隐私保护。节点信息的传输无须经过某个中心节点,降低了隐私泄露的风险,同时增加了消息的匿名性。

惠普实验室(Hewlett-Packard Laboratories)的Milojicic将P2P网络定义为一类采用分布式方式、利用分布式资源完成关键功能的系统。其中,分布式资源包括算力、存储空间、数据、网络带宽等各种可用资源,关键功能是分布式计算、数据内容共享、通信与协作或平台服务。

(1)P2P网络模型

1、集中式P2P网络

集中式P2P网络结构最为简单,一个节点保存其他节点的索引信息,而索引信息又包括节点IP、端口、节点资源等。节点之间互连的路由信息需要向中心节点查询,如果和对等节点建立连接则不再依赖中心节点。集中式P2P网络结构简单、容易实现,但是由于其所有路由信息都在中心节点中存储,因此当节点数量不断增长时容易出现性能瓶颈,也容易出现单点故障。

集中式P2P网络拓扑结构如下图所示。

2、纯分布式P2P网络

纯分布式P2P网络移除了中心节点,在P2P网络之间建立了随机网络,一个新加入的节点和P2P网络中的某个随机节点建立连接,形成一个随机的拓扑结构,如下图所示。新节点和邻居节点建立连接后需要全网广播,让整个网络感知到新节点的存在。

全网广播的方式是,新节点向自己的邻居节点广播,邻居节点在接收到广播后向自己的邻居节点广播,以此类推,从而广播到整个网络。这种广播机制也称为泛洪机制。

纯分布式P2P网络不存在集中式P2P网络的单点故障和中心节点性能瓶颈,具有较好的扩展性,但是泛洪机制又引入了新的问题,一是容易形成泛洪循环,节点A发出的消息经过节点B到节点C,节点C再广播到节点A,形成了一个消息循环;二是响应消息风暴,如果节点A想请求的资源被很多节点拥有,那么在短时间内就会有大量的节点向节点A发送响应消息,可能会让节点A崩溃。

3、混合式P2P网络

混合式P2P网络就是混合了集中式P2P网络和纯分布式P2P网络的结构,混合式P2P网络中存在多个超级节点组成分布式P2P网络,而每个超级节点又与多个普通节点组成局部的集中式P2P网络,如下图所示。相对于普通节点,超级节点在处理能力、带宽、存储方面具有一定的优势。一个新的普通节点加入网络时,需要先选择一个超级节点进行通信,该超级节点推送其他超级节点列表给新加入的普通节点,然后,新加入的普通节点再根据超级节点列表中的状态选择一个超级节点作为父节点。

这种混合式P2P网络拓扑结构限制了泛洪机制广播的范围,避免了大规模的泛洪循环。在实际应用中,混合式P2P网络拓扑结构是相对灵活且比较有效的网络结构,容易实现。

4、结构化P2P网络

结构化P2P网络综合了集中式P2P网络的快速查找和纯分布式P2P网络的去中心化特点,对二者进行了权衡,结构化P2P网络是目前P2P网络的主流结构。

结构化P2P网络也是一种分布式P2P网络,但其与纯分布式P2P网络有所区别。纯分布式P2P网络是一个随机网络,而结构化P2P网络可以将所有节点按照某种结构有序地组织起来,形成一个环形网络或树形网络。

结构化P2P网络在具体实现上普遍基于DHT(Distributed Hash Table,分布式哈希表)算法。具体的实现方案有Chord、Pastry、CAN、Kademlia等算法,其中,Kademlia算法是以太坊P2P网络所采用的算法。下图展示了一个简单Kademlia网络的拓扑结构。在Kademlia算法中,通过对节点按照二叉树的结构进行组织,可以达到对节点高效路由和索引的目的。

(2)P2P网络协议

1、BitTorrent协议

BitTorrent(全称比特流,简称BT)协议是一个网络文件传输协议,依赖P2P网络,采用BT协议的节点作为数据下载者在下载的同时不断向其他下载者上传已下载的数据。BT协议充分利用了用户的上行带宽,通过一定的策略保证上传速度越快,下载速度也越快。

BT协议是架构于TCP/IP协议之上的一个P2P网络文件传输协议,处于TCP/IP协议的应用层。BT协议本身包含很多具体的内容协议和扩展协议,并且还在不断扩充。如果有多个下载者并发地下载同一个文件,则每个下载者同时为其他下载者上传文件,这样,文件源可以支持大量的用户进行下载,而只带来适当的负载增长。

BT协议把提供下载的文件进行拆分,这种拆分并不是将文件实际拆分,而是按照固定大小拆分成逻辑上的小块,逻辑分块后硬盘上并不产生各个块文件,而把每个块的索引信息和哈希值写入torrent文件(种子文件,简称“种子”),作为被下载文件的索引和校验依据。下载者要下载文件内容,首先需要得到相应的torrent文件,然后使用BT客户端进行下载。下载时BT客户端首先解析torrent文件,得到Tracker服务器地址,然后连接Tracker服务器。Tracker服务器回应下载者的请求,提供拥有资源节点的IP地址。BT客户端也可解析torrent文件,得到节点路由表,然后连接节点路由表中的有效节点,由网络中的有效节点提供其他下载者的IP地址。

下载者再连接其他下载者,根据torrent文件,分别告知对方自己已经拥有的数据块,然后向对方获取自己没有的数据块。这种方式不需要其他服务器或网络节点的参与,分散了单条线路上的数据流量,减轻了服务器的负担。下载者每得到一个块,都需要算出下载的数据块的哈希验证码,与torrent文件中的进行对比,如果一致则说明数据块正确,不一致则需要重新下载这个数据块。下载者越多,提供的带宽越多,torrent文件也越多,下载速度就越快。

从BT客户端角度考虑,下载原理分为以下几步。

- 根据BT协议,文件发布者会根据要发布的文件生成一个torrent文件。BT客户端可从Web服务器上下载该torrent文件,并从中得到Tracker服务器地址等信息。

- 根据Tracker服务器地址与Tracker服务器建立连接,并从Tracker服务器上得到拥有torrent文件的节点的信息,或者根据这些信息与网络中其他节点建立连接,或者从对等节点中得到拥有torrent文件的节点的信息。

- 根据节点信息与多个节点建立连接,依据对应协议完成握手,并从连接的对等节点中下载数据文件,同时监听其他节点的连接,以便将自己拥有的数据分享出去。

在这个发展阶段的BT协议使用Tracker服务器作为torrent文件提供索引,同样面临着集中式P2P网络遇到的问题,随着P2P网络的发展,出现了DHT这样不依赖中心索引服务器(如Tracker服务器)的结构化网络模型,BT协议也随之更新,支持无Tracker服务器模式。

DHT是一种分布式存储方法。在不需要中心索引服务器的情况下,每个BT客户端负责一个小范围的路由,并存储一小部分数据,从而实现整个DHT网络的寻址和存储。使用支持该技术的BT客户端,用户无须连接Tracker服务器就可下载,因为BT客户端会在DHT网络中寻找下载同一文件的其他用户,并与其进行通信,开始下载。这种技术优势非常明显,极大地减轻了Tracker服务器的负担,甚至可以不使用Tracker服务器,用户之间可以更快速地建立连接。

2、Kademlia协议

Kademlia是一种通过分散式杂凑表实现的协议,它是由Petar Maymounkov和DavidMazières为P2P网络设计的一种结构化网络协议。Kademlia协议规定了网络的结构,也规定了通过节点查询进行信息交换的方式。节点间依赖自身ID作为标识,同时依赖自身ID进行节点路由和资源定位。

相对于纯分布式P2P网络泛洪式地查询数据,Kademlia网络为了更加快速地搜索节点,采用基于两个节点ID的异或来计算距离。需要注意的是,同一网络中的节点ID格式必须一致,并且得到的距离只是在Kademlia网络中的虚拟距离,与现实中节点的物理距离没有关系。一个具有2n个节点的Kademlia网络在最坏的情况下只需要n步就可以找到被搜索的节点。

在Kademlia网络中,所有节点都被当作一棵二叉树的叶子节点,并且每个节点的位置都由其ID前缀唯一确定。任意一个节点都可以按照自己的视角把这棵二叉树分解为一系列连续的、不包含自己的子树。

- 最高层的子树,由整棵不包含自己的二叉树的另一半组成

- 下一层子树则由剩下部分中不包含自己的二叉树的另一半组成

- 以此类推,直到分割完整棵二叉树

下图展示了节点0011对子树的划分。

虚线包含的部分就是各子树,从节点0011的视角一共划分为四棵子树。Kademlia协议确保每个节点都知道其各非空子树的至少一个节点。在这个前提下,每个节点都可以通过节点ID找到任何一个节点。这个路由的过程是通过异或节点ID,不断缩短节点间距离得到的。

下图演示了节点0011是如何通过连续查询找到节点1110的。节点0011通过在逐层的子树间不断学习,并查询最佳节点,获得越来越接近的节点,最终收敛到目标节点。

- 首先,假设查询的目标节点是1110

- 按照节点0011的视角划分子树,在第一棵子树中,假设节点0011知道其节点是101,节点0011首先向节点101发起请求。向节点101发起请求是因为根据与节点101计算异或距离后发现其与目标节点距离最近,为了得到目标节点需要向离目标节点更近的节点查询。

- 然后,节点101也会按照自己的视角将整棵树进行划分,它同样知道每棵非空子树中的至少一个节点,这时返回目标节点所在的对应子树中节点101知道的节点

- 以此类推,找到目标节点。后续的每步查询都是上步查询的返回值,并且每步都越来越接近目标节点。

在Kademlia网络保存的每个子树的节点列表都被称为K桶,其中,K标识了一个桶中存放节点的数量。每个节点都保存了按自己视角划分子树后子树中节点的信息,如果只保存单个节点,则鲁棒性不足,为了解决这个问题,需要多保存几个节点。在上图中可以看到,有些子树的节点多,有些子树的节点少。Kademlia协议为平衡系统性能和网络负载设置了一个常数,但该常数必须是偶数,如K=20。在BT协议的实现中,K=8。

网络中的节点并不是一成不变的,随时有节点加入也有节点退出,为了维护网络的稳定性需要实时更新K桶,剔除已经退出网络的节点,增加新加入网络的节点。

基于对网络上大量用户行为习惯的研究结果,节点的失效概率和在线时长呈反比,也就是说,在线时间长的节点继续保留在K桶列表中更有利于网络的稳定性。

由于每个K桶覆盖距离的范围都呈指数增长,因此形成了离自己近的节点的信息多,离自己远的节点的信息少的情况,保证了路由查询过程是收敛的。这种方式也意味着有更多可能连接到离自己近的节点,一方面是因为距离近的子树的节点少,另一方面是因为自己可以更多地包含距离近的节点。

区块链网络

区块链网络是按照P2P协议运行的一系列节点的集合,这些节点共同完成特定的计算任务,共同维护区块链账本的安全性、一致性和不可篡改性。

区块链系统为了适应不同的应用场景或解决单一节点性能瓶颈,衍生出了不同类型的节点,这些节点有不同的分工,共同维护整个区块链网络的健壮性。除了P2P协议,区块链网络还包含其他协议。

(1)节点类型

虽然P2P网络中的各个节点相互对等,但在区块链网络里根据提供的不同功能,不同区块链系统会对节点类型进行不同的划分。

区块链技术发展早期,主要以公有链为主,根据节点存储内容的不同,节点类型划分为以下两种。

- 全节点:全节点指的是节点同步全量区块链数据,负责交易的广播和验证,维护整个区块链网络的稳定运行。

- 轻节点:轻节点也被称为简单支付验证(SPV)节点,指的是节点只同步区块头数据,依赖全节点,通过默克尔路径验证一笔交易是否存在于区块中,不需要下载区块中的所有交易。存储容量有限的IoT设备可以通过运行一个轻节点参与到区块链网络中。

随着区块链技术的快速发展和普及,区块链应用呈现爆发式增长,各种应用场景层出不穷。为了解决传统企业业务上的痛点,企业级联盟链应运而生,这也对区块链技术提出了更高的要求,相对于公有链,联盟链中的节点类型更加多样化。例如,由大中企业组成的联盟链,其核心企业具有最优厚的计算资源和最高的数据管理权限,而小企业只有数据访问权,它依赖核心企业提供的数据来运行自己特定的业务。核心企业节点间通过运行共识协议决定区块链账本的内容,而小企业节点同步这些账本内容,当收到一条客户端发送过来的交易时,转发给核心企业节点处理。

因此,根据节点是否参与共识,节点类型又可划分为以下两种。

- 共识节点/验证节点:共识节点在某些系统中也被称为验证节点,主要负责对交易排序,并打包成块,与其他验证节点达成一致的共识,然后执行交易,将交易和执行结果进行存储。

- 非共识节点/非验证节点:非共识节点在某些系统中也被称为非验证节点,主要负责同步验证节点生成的区块,执行交易,将交易和执行结果进行存储。

下图为趣链区块链平台多种类型节点组成的网络拓扑。

其中,VP为共识节点,NVP和CVP均为非共识节点,每个VP节点都可以部署一个由CVP节点组成的灾备集群,在VP节点发生故障时,自动切换接替VP节点的工作。

在某些联盟链系统中,为了突破单一节点系统资源的限制,将区块的共识、执行和存储功能进行拆分,分别交由不同节点完成。

- VP节点运行共识协议,决定交易的排序,并打包成区块,因为VP节点不存储区块链账本内容,因此不执行区块只广播区块。

- NVP节点接收到VP节点广播过来的区块后,首先对区块进行合法性校验,校验通过后,按照区块内交易的顺序执行交易,并存储交易和执行结果。

Hyperledger Fabric联盟链就是一个典型的拆分节点共识、执行和存储的例子,共识交由Order节点完成,执行和存储交由Peer节点完成,下图为Hyperledger Fabric联盟链多种类型节点组成的网络拓扑,为了简化复杂度,图中没有画出多通道的Hyperledger Fabric联盟链网络,仅描述只有一个通道的Hyperledger Fabric联盟链网络,组织A和组织B在一个通道内。

在由多个组织参与组成的Hyperledger Fabric联盟链网络中,每个组织都可以是一个集群,不同的组织集群连接起来形成一个区块链网络。

在整个网络中,节点主要分为客户端节点、CA节点、Order节点和Peer节点。

- 客户端节点为通过客户端发送提案、提交交易的节点

- CA节点负责为网络中的节点提供基于数字证书的身份信息

- Order节点负责对Peer节点签名并对满足签名策略的交易提案进行排序和出块,广播给Peer节点

- Peer节点可担任不同角色,角色如下。

- 记账节点(Committing Peer):所有的Peer节点都可以称作记账节点,负责对区块及区块交易进行验证,验证通过后写入账本。

- 背书节点(Endorsing Peer):负责执行客户端节点发送过来的交易提案,并根据背书策略对交易进行签名背书后再返回给客户端节点。

- 主节点(Leader Peer):一个组织集群中有多个Peer节点,为了提高通信效率,需要一个主节点作为代表负责与Order节点通信,接收Order节点广播过来的区块,并同步给组织集群内其他Peer节点。主节点可以通过动态选举或静态指定产生。一个组织集群内可以有一个或多个主节点。

- 锚节点(Anchor Peer):负责与其他组织集群的Peer节点通信,即负责跨组织集群的通信,确保不同组织集群内的Peer节点相互知道对方组织集群的节点信息。锚节点不是Hyperledger Fabric联盟链网络的必选项,一个组织集群可以有零个或多个锚节点。

综上所述,在不同的区块链系统里,根据节点职能的不同对节点类型有不同的划分,不同类型的节点分工协作,维护整个区块链网络的健壮性和稳定性。通过对节点类型进行划分,一方面,可以满足业务应用场景的需求,比如,前文提到的中小企业联盟链的例子;另一方面,突破单一节点系统资源限制,便于日后节点横向扩展,构建更大规模的区块链网络。

(2)区块链网络模型

区块链的网络结构继承了计算机通信网络的一般拓扑结构,可以分为如下图左边和右边所示的完全去中心化网络结构和多中心化网络结构。

完全去中心化指网络里所有节点都是对等的,各个节点自由加入或退出网络,不存在中心节点。采用PoW共识算法的公有链就是一种完全去中心化网络。在这种网络中,所有节点都有权限生成新区块,并写入区块链账本,节点只要解出PoW数学难题就能获得记账的权利,在经济激励机制下,越来越多的节点参与到记账权的竞争中,整个网络得以稳定运行,这种稳定运行不依赖某些中心节点,任何节点的退出都不会对区块链网络造成影响。但是,完全去中心化网络维护成本高、共识效率低、交易确认延迟高。随着互联网技术的发展,人们对交易吞吐量的要求越来越高。据统计,全球知名信用卡支付公司平均每秒可处理大约2000笔交易,其峰值维持在每秒上万笔交易。

站在“区块链不可能三角”(可扩展性、去中心化、安全性)的角度,区块链要想应用到实际业务场景中,可扩展性和安全性缺一不可。而去中心化作为区块链技术兴起的一大亮点,也不可缺失。因此,人们想到,可以牺牲部分去中心化来提升整个网络的可扩展性,但这种牺牲并不是说网络就此变成了中心化网络架构,而是演变成一种叫作“弱去中心化”的网络架构,也称为多中心化网络结构。

多中心化网络结构指网络里存在特定数量的中心节点和其他节点,只有中心节点拥有记账权。如上图右边所示,黑色圆点表示中心节点,灰色圆点表示其他节点,中心节点负责共识和出块,它的加入和退出受到严格控制,往往需要经过全网节点投票同意后方可加入或退出;其他节点虽然没有记账权,但可以共同监督中心节点的行为,如果中心节点存在作恶行为,则可以将其投出。其他节点也可以竞争成为中心节点。

不同区块链系统采用的网络连接方式不同,主要划分为如下图左边和右边所示的全连接网络和自发现传播网络,这两种网络连接方式各有优缺点。

- 全连接网络,即节点间两两建立可互相收发消息的网络连接,消息的发送不需要经过中间节点传播,直接到达对端,具有实现简单、通信高效的优点,但是网络扩展性不高

- 自发现传播网络,即节点只与部分节点建立网络连接,但总有一条链路可以到达网络里的各个节点,因此,理论上网络可无限扩展,但是实现起来较复杂且通信可能有一定的延迟。

(3)区块链网络协议

区块链网络在对等网络的基础上,还包括其他协议。本节将介绍区块链系统网络层常用的协议。

1、Gossip

Gossip协议最早是在1987年由Demers Alan,Dan Greene等在ACM上发表的论文Epidemic Algorithms for Replicated Database Maintenance中提出的。它是一种去中心化、可扩展、可容错,并保证最终一致性的消息传播通信协议,用来实现节点间信息同步,解决分布式架构中的一致性问题。

Gossip协议的基本原理是当一个节点想要把自己的消息同步给组织集群内其他节点时,先周期性地随机选择几个节点,并把消息传播给这些节点。收到消息的节点重复同样的过程,即把消息再传播给随机选择的其他节点,直至组织集群里的所有节点都收到了该消息。随机选择目标传播节点的数量N是一个指定的常量,这个N称为fanout参数。由于整个收敛过程需要一定的时间,因此无法保证在某一时刻所有节点都收到了消息,但理论上最终所有节点都会收到消息。因此,Gossip协议是一个最终一致性协议,其不要求任何中心节点,允许节点任意加入或退出组织集群,组织集群里的所有节点都是对等的,任意一个节点不需要知道整个组织集群里的所有节点信息就可以把消息散播到全网,即使组织集群中任何节点宕机或重启也不会影响消息的传播。

下图为Gossip协议在由16个节点组成的网络里的数据传播示意图,

- 首先,图(a)中节点1更新数据,并想广播给其他节点

- 图(b)所示,节点1随机选择了节点2和节点7进行数据传播

- 然后,如图(c)所示,节点1、节点2和节点7继续随机选择节点进行数据传播。

- 以此类推,最后,网络里的所有节点都更新了数据

总结一下,节点传播消息是周期性的,并且每个节点都有自己的周期。节点传播消息的目标节点数量由fanout参数决定。至于往哪些目标节点传播消息,则是随机选择的。所有节点都重复同样的过程,直至整个网络从不一致的状态收敛到一致的状态。

一般来说,Gossip网络中两个节点间的通信方式有以下三种。

- Push-based方式:节点A将数据及版本号(Key,Value,Version)推送给节点B,节点B更新节点A中比本地新的数据。

- Pull-based方式:节点A仅将(Key,Version)发送给节点B,节点B将本地比节点A新的数据(Key,Value,Version)推送给节点A,节点A更新本地数据。

- Push-Pull混合方式:在Pull-based方式的基础上,节点A将本地比节点B新的数据推送给节点B,节点B更新本地数据。

理论上,使用Gossip协议进行通信的组织集群的节点数量无上限,网络收敛速度快,因此,Grossip协议在区块链领域得到了广泛应用。

面向企业级联盟链的Hyperledger Fabric采用Gossip协议作为其P2P网络的消息传播协议。其主要作用有:

- 区块传播:避免为了同步区块,所有的Peer节点都与Order节点连接的情况。仅需要主节点与Order节点相连,负责与Order节点通信。主节点在获取到新区块以后,通过Gossip网络的Push-based方式将新区块传播给随机选择的预定数量的其他Peer节点,收到新区块的Peer节点重复该过程,直到每个Peer节点都收到了新区块。通过Gossip协议进行区块传播在一定程度上缓解了Order节点的压力

- 区块同步:当Peer节点由于宕机、重启或新加入导致区块落后时,通过Gossip网络的Pull-based方式可以从其他Peer节点处拉取新区块,直至账本数据同步到最新状态,此过程不需要Order节点的参与

- 节点发现:Peer节点周期性地通过Gossip网络的Push-based方式随机选择预定数量的节点传播心跳消息,表示自身存活状态。因此,每个组织集群的Peer节点都可以维护组织集群内所有Peer节点的存活状态信息。若每个组织集群中至少有一个Peer节点访问锚节点,则锚节点就可以知道通道内所有不同组织集群的Peer节点的信息,进而网络里的所有Peer节点都可以知道通道内所有不同组织集群的节点信息,维护通道内的节点关系视图(组织集群关系视图)。

同样采用Gossip协议的还有Facebook研发的面向稳定币的区块链系统Libra,Libra仅使用Gossip网络中的Push-based方式实现区块链节点发现功能。节点周期性地随机选择预定数量的节点向其传播自己当前的网络视图,收到消息的节点如果检查到对端发送过来的信息更新,则更新本地维护的节点地址信息,重复该过程,直到网络里的所有节点都有一个完整的节点关系视图。如果节点关系视图里有未建立连接的节点,则与其建立连接。因此,Libra仅使用Gossip协议实现节点发现功能,而整个网络还是一个全连接网络,节点间两两相连。

2、Whisper

Whisper起源于以太坊,是以太坊里的一个网络子协议,子协议指的是构建在以太坊P2P网络之上的协议,虽然各个子协议都有自己的协议名称、协议版本号和协议消息定义,但是,所有子协议的底层通信都使用同一个以太坊P2P网络。

Whisper是一个基于身份的消息传递系统,其设计目的是为DApp提供一种高隐私性、防网络嗅探的通信服务。一个以太坊节点可以自行选择是否开启Whisper服务,如果开启,那么这个节点被称为Whisper节点。

Whisper节点周期性地向其他节点广播自己收到的Whisper消息,因此,所有的Whisper消息都会发送给每个Whisper节点。为了降低网络负担,防止恶意客户端向节点发送大量垃圾消息对节点造成DDoS攻击,以太坊使用PoW来提高Whisper消息发送的门槛,即每次发送Whisper消息,节点都需要进行一次PoW,仅当消息的PoW值超过特定阈值时,节点才会处理该消息,并转发给其他Whisper节点,否则将其丢弃。本质上,如果节点希望网络将Whisper消息存储一段时间(TTL),那么计算PoW值的成本可视为为该消息分配资源所支付的价格,因此,所需PoW值与消息大小和TTL呈正比。

由于所有的Whisper消息都会被加密且通过加密网络传输,只有持有对应密钥的人才能对消息解密,所以Whisper消息传递具备安全性。

Whisper对外暴露了一套订阅—发布模型的API,客户端通过这套API,可以向Whisper节点发送与某个Topic相关的消息,节点将消息分发给所有与该Topic相关的过滤器,并在到达广播时间时将消息广播给其他Whisper节点。客户端也可以向Whisper节点订阅自己感兴趣的Topic,节点将返回一个过滤器ID给客户端,如果过滤器里有与该Topic相关的消息,则客户端使用过滤器ID向节点查询得到Topic消息。客户端也可以在向Whisper节点发送消息时指定这个Topic消息要转发给哪个Whisper节点,由接收发送请求的节点将消息转发给指定节点,指定节点收到Topic消息以后,将消息分发给所有与该Topic相关的过滤器,并在到达广播时间时将消息广播给其他Whisper节点。

3、libp2p

libp2p是协议实验室(Protocol Labs)研发的IPFS项目里相当重要的一个组件,主要负责节点发现、数据路由、安全传输等,后来被提升为独立的开源社区项目。如今,已经有多个项目使用libp2p作为网络传输层,如IPFS、Filecoin、Polkadot和以太坊2.0等。

libp2p支持各种各样的传输协议,如TCP、UDP、QUIC等,它使用自描述(Multiaddr)来标准化一个节点的地址,而不仅是IP地址和端口号。自描述地址包括IP地址类型、IP地址、网络传输协议、端口号、应用协议ID和节点ID等信息,通过地址解析和协议协商,libp2p知悉使用什么协议才能连接到目标节点。这使得libp2p在网络协议繁多、协议升级频繁的大环境下,可以很方便地实现各种协议的扩展。

libp2p作为一种专门为点对点应用设计的模块化、易扩展、集多种传输协议和点对点协议为一体的通用P2P解决方案,具有成为未来点对点传输应用、区块链和物联网基础设施的潜力,它高度抽象了主流的传输协议,使得上层应用开发不必关注底层网络的具体实现,最终实现跨环境、跨协议的设备互联。

本章将介绍用于保证区块链系统一致性的核心算法——共识算法。共识问题在区块链系统出现之前就已经有非常长时间的研究了,传统分布式一致性算法可以解决组织集群部署下由于节点出现宕机错误导致的不一致问题,通常用于多机灾备容错方案,如分布式数据库管理。但是,区块链系统上承载的是价值传输,因此典型的区块链共识算法必须考虑到恶意节点的存在,保证区块链上的价值不会被恶意节点操纵。随着区块链技术的不断发展,区块链共识算法逐渐呈现百花齐放的态势,近年来也出现了许多新型的共识算法,它们大都在前人的研究基础上进行了一定的结合与改良,往往能够很好地解决许多现实中的问题,达到非常好的效果。

共识算法概述

(1)共识问题

共识问题指的是如何让处在分布式系统中的一系列节点就某一个决策达成一致。一个好的共识算法可以让分布式系统中的所有节点运行得像一个节点实体一样,其中每个节点都有完全一致的操作记录。但是,这样一个听起来很简单的问题却成为近几十年来分布式系统理论研究的核心。究其原因,主要可以总结为如下三点。

- 首先,实践证明共识问题是一个难以解决的问题。FLP不可能定理从理论上证明了如果一个分布式系统中存在任意一个故障节点,那么共识问题在异步系统中是不可解的,只有在同步系统中才有解。因此,共识问题的难易程度在很大程度上依赖通信模型中的时序假设。

- 其次,设计一个正确的共识算法是很难的。简单的协议往往不能应付所有场景,如2PC协议、3PC协议,在遇到网络分区之后都无法保证系统的一致性。Chubby的发明者MikeBurrows曾经说过:“只有一种共识协议,那就是Paxos,其他共识协议都是Paxos的变种。”由Leslie Lamport构思的Paxos以设计精妙著称,但是由于其难以理解,因此在很长一段时间里都不曾被人知晓。

- 最后,随着分布式系统的发展,共识算法变得愈发重要。分布式数据库、复制状态机等一系列分布式系统都在极大程度上依赖共识算法。

(2)正确性定义

共识算法的正确性定义如下。

在一个由N个节点组成的分布式系统中,一个正确的共识算法必须满足如下四个特性。

- 一致性(Agreement):所有节点都同意某个决策值,这就要求共同决策的结果是可以被所有结点很容易、不存在分歧地进行快速验证。

- 有效性(Validity):最终决定的决策值必须由这N个节点中的某个节点提出,即共识达成的过程是异步的。

- 终止性(Termination):所有节点最终都能完成决策,即共识达成的步骤一定是有限状态机。

- 容错性:所有节点需要假设网络中存在错误节点的前提下,依然能够达成最终的共识

一致性比较好理解,即如果不同节点最终选定的决策值不一致,那么共识就无法达成。当然,在某些情况下,可以稍微减弱这个条件,即只要系统中大多数(Majority)节点同意某个决策值,就认为共识已经达成了。

有效性可能看起来不太直观,但是如果仅保证一致性,则可能存在如下问题:所有节点最终都会选择一个系统的默认值。例如,在一个数据库提交协议的过程中,如果每次决策都是“不提交”,虽然不会破坏一致性,但是所有合法的事务提交都会被拒绝,这显然是不合理的。

终止性也是一个非常重要的特性。一致性可以定义系统如何选择一个决策值,却没有定义何时进行这样的选择。因此,共识算法需要通过终止性来保证系统始终不停地向前运转,而不是一直停留在一个决策中迟迟无法结束,这样的共识算法是不实用的

最后是容错性,设计一个能够容忍节点出错的共识算法更加困难。事实上,共识问题最典型的应用场景就是容错系统,如状态机复制(StateMachine Replication)问题。容错系统中往往存在一组连续的共识问题,任何一个节点都有可能出现异常,有可能是良性的宕机停止错误(Crash Stop),也有可能是恶意的拜占庭错误(Byzantine Fault),如何保证在存在错误节点的同时达成连续的共识是一个实用的共识算法必须考虑的问题。

(3)通信模型

分布式系统建立在许多通过网络连接或其他方式进行消息通信的节点之上,而网络通信的不确定性会限制共识算法的设计。通信模型定义了不同消息的延迟对于分布式系统的限制能力。总的来说,一共存在三种类型的通信模型,分别是同步模型、异步模型与部分同步模型。

1、同步模型(Synchronous Model)

在同步模型中,所有节点之间的消息通信都存在一个已知的延迟上界∆,并且不同节点处理事务的相对速度差值有一个已知上界ϕ。因此,在同步模型中,每轮共识中的任何一个节点都必须在一定的时间差内执行完成本地事务,并能够在给定时间内向其他节点传输完成任意大小的消息。在同步模型中,任何节点的请求都应该在一个可预估的时间内得到响应,否则,可将对端节点视为故障节点。

同步模型是一个非常理想的通信模型,在现实生活中几乎不可见,但是在分布式系统的理论研究中却发挥着极其重要的作用,许多早期的分布式一致性算法都是在同步模型的假设下设计的。

2、异步模型(Asynchronous Model)

在异步模型中,上述的延迟上界∆与ϕ都不存在,即节点间消息传递的延迟无上界(但是可以保证消息最终能够传递完成),节点的处理速度也未知。

异步模型比较符合现实的互联网环境,节点无响应可能是网络断开造成的,也可能是节点处理速度过慢,无法通过简单的超时检测判断节点是否失效。异步模型与同步模型相比更通用。一个适用于异步系统共识的算法,也适用于同步系统,但是反过来并不成立。

在异步模型中设计一个正确的共识算法已经被证明是不可能的。

3、部分同步模型(Partial Synchrony Model)

部分同步模型是介于同步模型与异步模型之间的一种通信模型,于1988年由Dwork、Lynch、Stockmeyer在论文中提出。

该模型假设存在一个全局稳定时间(GlobalStabilization Time,GST),在GST之前,整个系统可能处于异步状态,即消息的传递无延迟上界,但是在GST之后,整个系统可以恢复到同步状态。然而,该模型中的GST是未知的,即无法预知何时到达GST从而恢复到同步状态。部分同步模型的时序假设比较贴合现实世界中对共识算法的需求,即共识总可以在同步状态下完成,然而一旦网络出现问题,共识可能会进入一段时间的阻塞,直至网络恢复正常。因此,部分同步模型中的共识算法设计首要保证的就是安全性(就算系统进入了异步状态),仅需要在GST之后保证系统的可终止性(活性)。

该模型其实是许多共识算法的模型基础(虽然有些并没有显式地提及),如Paxos、ViewStamp Replication、PBFT共识算法等。

4、共识算法简史

最早的分布式一致性算法可以追溯到Leslie Lamport在1978年发表的论文。虽然在论文中并没有显式地提及一致性的概念,但是Lamport在摘要中明确指出了一种用于定义分布式事件发生前后关系(偏序关系)的算法,该算法最终可用于同步分布式系统的逻辑时钟(也称为Lamport Clock),从而确定系统中所有事件的全序关系。Lamport在论文中通过一个状态机的例子展示了全序关系如何用来解决分布式系统中的同步问题,这也是首篇将同步问题与分布式状态机问题结合到一起的论文,按照Lamport的说法,这篇论文实际上描述了一种如何实现任意分布式状态机的算法,这也正是分布式一致性算法的来源。

同年,JimGray在论文中提出了两阶段提交(2PC),首次尝试解决分布式数据库中的一致性问题,但是2PC存在严重的阻塞问题。

1981年,Dale Skeen在论文中提出了三阶段提交(3PC),可以解决2PC的阻塞问题,但是3PC在发生网络分区时会有严重的不一致问题。事实上,2PC满足了安全性却牺牲了活性,而3PC恰恰相反,它满足了活性却牺牲了安全性。

1982年,Leslie Lamport在论文中提出了著名的拜占庭将军问题,引入了拜占庭错误,将一致性问题的复杂度又提升了一个档次。与此同时,Lamport也给出了两种在同步模型下拜占庭将军问题的解法,虽然此时人们对同步网络与异步网络还没有非常清晰的定义。

直到1985年,Fischer、Lynch和Paterson在论文中提出并证明了FLP不可能定理,直截了当地告诉人们在异步网络中,只要有一个节点出现故障,就不可能存在一种完美的共识算法可以正确地终止。在此后的共识算法设计过程中,人们大都会避开异步网络的假设,但是异步网络才是现实生活中真实的网络模型。

直到1988年,Dwork、Lynch、Stockmeyer在论文中提出了部分同步模型,该模型旨在提出一种介于同步网络与异步网络之间的网络模型。在该模型中,FLP不可能定理的限制可以被部分打破,即当系统处于异步状态时,共识可以阻塞,而现实中总有恢复到同步网络的时候,此时共识就可以继续推进了。

1990年,Lamport在论文中提出了Paxos,这是首次被提出的一个能够在异步网络中保证安全性并在网络进入同步状态后保证活性的共识算法,其后很大一部分共识算法都是Paxos的变体,包括后来的RAFT。但是Paxos最大的问题在于它只能安全运行在非拜占庭网络的环境中,一旦有节点进行恶意攻击,那么整个系统将会崩溃。

1999年,MiguelCastro和Barbara Liskov在论文中提出了PBFT共识算法,该算法大大降低了拜占庭容错算法的网络复杂度,成为第一个实用的拜占庭容错算法。

2008年,中本聪发表了比特币白皮书,首次提出了比特币的概念,同时将PoW共识算法应用到区块链。此后,各类证明类的共识算法相继出现,如PoS、PoA等,共识算法也从传统分布式一致性算法慢慢演化成独特的区块链共识算法。

拜占庭将军问题

1982年,Leslie Lamport、Robert Shostak和Marshall Pease三位科学家发表了论文,该论文提出了著名的拜占庭将军问题。拜占庭将军问题首次假设了分布式系统中存在恶意节点的情况,并给出了在同步模型下的解法(虽然在此之前,同步模型与异步模型还没有明确的定义)。在拜占庭将军问题中,节点不仅会出现宕机或断网等良性错误,还有可能出现任意情况的拜占庭错误。例如,硬件或软件故障导致的节点不按程序逻辑运行,甚至节点程序被人恶意操纵,等等。总之,拜占庭错误更加贴近实际生活中面临的故障模型,也是分布式系统中最难解决的故障模型。

Leslie Lamport、Robert Shostak和Marshall Pease三位科学家在上述论文的摘要中,指出了一个可靠的计算机系统必须能够处理故障组件向其他组件发送不一致消息的恶意情况,并提出了一种更加抽象的描述方式:一组驻扎在敌军周围的拜占庭将军之间如何就攻击还是撤退达成一致。在该假设中,将军们只能通过信使进行沟通。与此同时,将军之间可能存在叛徒,叛徒企图混淆忠诚将军的视线,即向不同将军发送不一样的消息。叛徒的存在使问题变得更加复杂,因为叛徒不仅有可能投反对票,还有可能向不同将军投不一致的票。最终的问题就是在上述假设下,能否找出一种可以保证忠诚将军之间达成一致的算法。该算法需要满足如下两个条件。

- A. 所有忠诚将军最终会同意相同的决策,并且该决策是一个合理的决策。

- B. 少数叛徒不能使忠诚将军最终选择一个错误的决策。

条件A与条件B保证了最终所有忠诚将军行动一致,并且他们的决策不会被少数叛徒影响。

上述条件是站在全局视角来看的,为了简化问题的描述,可以从单个将军的视角进行分析。如果从每个将军的视角来看,都满足如下条件,那么整个系统将按照上述的条件A、条件B进行运转,下面给出拜占庭将军问题在单个将军视角下的描述(司令—副官模型)。假设一共有n个将军,任何一个将军作为司令都必须向其他n-1个副官(将军)发送一条指令,所有将军的行为需要满足两个条件,即

- IC1. 所有忠诚的副官最终会选择相同的指令。

- IC2. 如果司令是忠诚的,那么每个忠诚的副官都必须同意他的指令。

需要注意的是,如果司令是忠诚的,那么显然条件IC2可以推导出条件IC1。但是,司令不一定是忠诚的,如果司令是叛徒,那么所有忠诚的副官也应该协商选择一个相同的指令决策。

最终,Leslie Lamport、Robert Shostak和Marshall Pease给出了两种不同的解法,分别是基于口头消息的协议和基于书面消息的协议。

- 基于口头消息的协议

在基于口头消息的协议中,需要有至少3m+1个将军才能容忍m个叛徒的存在。

首先定义“口头消息”(口头消息协议的网络模型假设)。

- A1. 每个发送出去的消息都能够被成功地传递。 A2. 消息的接收方能准确地知道消息的发送方是谁。

- A3. 消息丢失可以被检测到。

可以看出,上述三点其实定义了一个较为严格的同步网络。A1和A2保证了叛徒不能干扰任意两位将军之间的网络通信。A1保证了叛徒不能干扰消息通道,A2保证了叛徒不能直接伪造其他将军的消息(但是叛徒可以伪造转发第三方将军的消息);A3阻止了叛徒企图通过不发送消息来阻止决策的达成。同时,基于口头消息的协议要求所有将军之间都可以直接发送消息(对应于分布式系统中的点对点网络)。

最终,证明在包含m个叛徒的情况下,至少需要3m+1个将军才能给出一个基于口头消息的解法,具体的算法及证明在此不做赘述,可以通过如下的例子来简单地理解其中的思想。

(1)当一共有n=3个将军时,如果有m=1个叛徒,则问题无解。

如下两个图所示,考虑两种情况,副官是叛徒及司令是叛徒,观察副官1的视角。

① 如果副官(副官2)是叛徒,此时司令发出一条指令(攻击),那么副官1将会收到一条来自司令的攻击指令和一条来自副官2的撤退指令(副官2故意欺骗副官1说自己收到的指令是撤退)。最终,在副官1的视角下,他收到了{攻击,撤退}的指令集合。

② 如果司令是叛徒,此时司令故意向副官1发出攻击指令,向副官2发出撤退指令,随后,副官2如实地将自己收到的指令(撤退)转发给副官1。最终,在副官1的视角下,他还是收到了{攻击,撤退}的指令集合。

上述两种情况中,在副官1的视角下,他收到的始终是{攻击,撤退}的指令集合,因此他无法辨别出到底司令是叛徒还是副官(副官2)是叛徒,这将导致副官1无法做出最终决策,违背了条件IC2(如果司令是忠诚的,那么忠诚的副官必须同意司令的指令)。

(2)当一共有n=4个将军时,如果其中有m=1个叛徒,则问题可解。

如下两个图所示,依然考虑两种情况,副官是叛徒及司令是叛徒。

①如果副官(副官3)是叛徒,此时司令给出一条指令(v),那么副官2将会收到一条来自司令的指令v、一条来自副官1的指令v(副官1如实转发自己收到的指令)、一条来自副官3的指令x(副官3故意欺骗副官2说自己收到的指令是x)。最终,在副官2的视角下,他收到了{v,v,x}的指令集合,由于v有2票,x只有1票,因此副官2可以直接判断出副官3是叛徒,并最终选择指令v作为自己最终的选择。同理,副官1将会做出相同的选择,即指令v,最终司令、副官1与副官2这3位忠诚的将军将会选择一致的指令v(满足条件IC1、条件IC2)。

②如果司令是叛徒,此时司令故意向副官1发出指令x,向副官2发出指令y,向副官3发出指令z,随后,每位副官都如实地转发自己收到的指令给其他两位副官。最终,在任何一位副官的视角下,他们收到的指令集合都是{x,y,z},可以判断司令为叛徒。在司令是叛徒的情况下,所有忠诚副官的行为必然是一致的(满足条件IC1)。由于司令是叛徒,因此无须考虑是否满足条件IC2。

- 基于书面消息的协议

上述第一个例子指出:仅通过口头消息,不存在一个解法使得小于3m+1个将军的军队中能够容忍m个叛徒,此处问题的难点在于叛徒可以伪造第三方将军的消息,从而混淆其他将军的视线。如果能够限制叛徒的这种伪造能力,那么问题就会变得简单,这就是基于书面消息的解法。这里的“书面”指的是所有消息都会带上将军的签字,从而变得不可伪造。对应到实际的计算机系统中,即所有的网络消息都需要带上节点的私钥签名,其他节点可以通过公钥进行验证。具体来说,在基于书面消息的协议中,需要对基于口头消息的协议的网络模型增加一个额外的假设条件。

- A1. 每个发送出去的消息都能够被成功地传递。 A2. 消息的接收方能准确地知道消息的发送方是谁。

- A3. 消息丢失可以被检测到。

- A4.(a)忠诚将军的签名不可伪造,任何对于已签名消息的篡改都可以被检测出;(b)任何人都可以验证将军签名的真实性。

需要注意的是,这里并没有对叛徒的签名做任何假设,即任意叛徒的签名都可以被另外的叛徒伪造,形成叛徒之间的共谋,这是可以容忍的。基于书面消息的协议的本质是引入签名消息,使得所有消息都可以追本溯源。在这种条件下,算法能够处理n

个将军中至多有m个叛徒的情况,其中,n≥m。

FLP不可能定理

1985年,Fischer、Lynch和Patterson三位科学家发表了论文,提出了著名的FLP不可能定理。作为分布式系统领域中最重要的定理之一,FLP不可能定理给出了一个非常重要的结论:在一个异步通信网络中,只要存在一个故障节点,就不存在一种完美的共识算法可以正确地终止。

FLP不可能定理实际上是在一个比异步通信网络更强的通信模型下得出的结论,如果在这样一个更强的通信模型下都无法保证共识算法的终止性,那么在现实中更弱的通信模型下也不可能达到这种保证。FLP不可能定理假设系统中不存在拜占庭错误,并且消息传递是可靠的,即消息传递的延迟未知,但是所有消息最终都会被成功传递且只会被传递一次。也就是说,FLP不可能定理假设网络消息可能出现延迟,但是不会出现丢包、重复包的情况,这是一个比现实网络更可靠的网络假设,但即便是在这种网络假设下,FLP不可能定理也证明了在任意时间停止单个节点进程,会导致任何一个共识算法都无法达成最终一致,更不要说现实网络中还存在网络分区与拜占庭错误等问题了。因此,如果不对通信模型做更进一步的假设,或者对容错类型做更大的限制,那么该问题就不存在一个完美的解决方案。

FLP不可能定理解决了此前五到十年间在分布式系统领域一直存在争议的问题。在此之前,已经有能够在同步网络中解决一致性问题的算法了(如拜占庭将军问题的两种解法),甚至在同步网络中还可以容忍节点出错。事实上,在同步模型中,可以通过等待一段已知的上限时间来检测对端节点是否出现故障,但是这在异步模型中是行不通的。直至FLP不可能定理的出现,才从理论的角度告诉人们可以不用再想方设法地设计一个在异步网络中始终能够达成一致的共识算法。因此,后续的共识算法设计通常会在某些方面做出妥协。例如,网络假设不再是异步模型而是部分同步模型,即允许存在一定时间的异步网络状态,在此期间无法达成共识,但是只要网络恢复到同步状态,就可以立即完成共识,虽然这样对于系统的活性有一定的影响,但是只要能够保证系统的安全性,依然是一个可接受的共识算法。例如,Paxos理论上也会出现活锁,但其能够保证即使出现活锁整个算法也是安全的,那么在实际场景中,只要活锁结束了,就可以继续推进共识了。

CAP理论

2000年,加州大学伯克利分校的Eric Brewer教授在ACM PODC会议上提出了CAP猜想。两年后,麻省理工学院的Seth Gilbert和Nancy Lynch从理论上证明了CAP猜想。此后,CAP理论正式成为分布式领域公认的定理。一个分布式系统最多只能同时满足如下三种特性中的两种。

- 一致性。这里的一致性(Consistency)指的是强一致性(Linearizability Consistency),即一旦完成了一次写操作,那么从任何一个节点处读取出来的结果要么是最新结果(最近一次写的结果),要么读取失败返回错误信息。强一致性是目前能够实现的最高级别的一致性模型,但是它的实现代价通常是非常大的,因此,在实际的工程实践中,通常将其放宽至较弱的一致性,如最终一致性(Eventual Consistency)。

- 可用性。可用性(Availability)指客户端每次的请求都会在一定时间内收到一个有效的响应,即服务一直可用。可用性一直是CAP理论中最有歧义的特性。从工程角度来说,可用性指的是系统能够成功处理请求的比例,或者客户端能够成功收到有效响应的比例。有效响应指的是该响应是正确的且能够在一定时间内返回。从这个角度来说,可用性是系统运行过程中通过人为观测得出的一个指标,因此,不能简单地说某种共识算法是“可用的”还是“不可用的”,只能说系统在一个运行时段内的观测结果是可用的还是不可用的。

- 分区容错性。分区容错性(Partition tolerance)指就算节点之间出现了网络分区问题,系统仍然能够对外提供服务。如果一个共识算法是在假设没有网络分区的情况下设计的,那么一旦出现网络分区,整个系统可能会出现任意错误,违背一致性或失去可用性。例如,RabbitMQ在出现网络分区后,不同的网络分区内可能出现各自的master进行各自独立的读写,此时就算恢复网络,整个系统也将进入不一致的状态。

CAP理论告诉人们,在设计一个分布式系统时,不必奢求同时满足上述三种特性,在实际的工程实践中,必须选择性地做出取舍,才能设计出一个实际可用的、高效的系统。

在分布式系统尤其是区块链系统中,营造一个高可用甚至永远不会出错的网络环境需要付出高昂的代价。因此,区块链系统必须满足分区容错性这一特性。那么对于区块链系统来说,就只能在一致性与可用性之间做出权衡与让步了。

例如,比特币系统中有成千上万的节点运行在世界的各个角落,几乎不可能设计出一个强一致性的共识算法保证所有节点同时对外提供一致的读写服务。因此,比特币系统选择通过牺牲强一致性来满足最终一致性、可用性与分区容错性。尽管比特币网络随时都有分叉的可能,即已经上链的区块有可能被回退,但是随着时间的推移,靠前的区块得到越来越多的确认,其被回退的可能性越来越低,以至于达到一种几乎不可能被回退的最终一致性。在此期间,每个节点都可以正常地对外提供读写服务。

共识算法分类

从传统分布式一致性算法的缓慢发展到现如今区块链共识算法的百花齐放,共识算法的发展已经走过了四十年左右的时光。不同共识算法的侧重点不同,它们所面临的问题、环境也不同。本节将从如下几个角度对共识算法进行分类。

- 容错类型。根据是否能够容忍拜占庭错误,可以将共识算法分为两类。是否能够容忍拜占庭错误标志着该算法是否能够应用到低信任的网络。通常来说,在公有链环境中必须使用拜占庭容错算法,而在联盟链中可以根据联盟参与方之间的信任程度进行选择。

- 拜占庭容错共识算法:PBFT、PoW、PoS、DPoS。

- 非拜占庭容错共识算法:Paxos、RAFT。

- 算法确定性。根据算法确定性,可以将共识算法分为两类。确定性共识指共识决策一旦达成,就不存在回退的可能,这一类共识算法通常是传统分布式一致性算法及其改进版本;概率性共识指已经达成的共识决策在未来有一定的概率会被回退,这个概率随着时间的推移会趋于0,这一类共识算法通常是应用在公有链上的区块链共识算法。

- 确定性共识算法:Paxos、RAFT、PBFT。

- 概率性共识算法:PoW、部分PoS。

- 选主策略。根据选主策略,可以将共识算法分为两类。选举类共识指通过投票选择出块节点,同一个节点可以连续多轮作为出块节点存在,这一类共识算法通常是传统分布式一致性算法及其改进版本;证明类共识指出块节点需要通过某种方式证明自己具备某种能力,从而获得出块权,这一类共识算法通常每轮的出块节点都不相同,从而保证出块权的公平性,通常应用在公有链上。

- 选举类共识算法:RAFT、PBFT。

- 证明类共识算法:PoW、PoS。

分布式一致性算法

分布式一致性算法主要研究在不考虑拜占庭错误,只假设节点发生宕机、网络故障等错误时,如何让多个节点达成一致。比较著名的分布式一致性算法包括:2PC、3PC、Paxos、ViewStamp Replication、Zab、RAFT等。本节主要介绍其中的2PC、3PC、Paxos及RAFT。

(1)2PC

2PC(Two-phase commit),即两阶段提交,是一种在分布式系统中为了协调所有节点进行统一提交或回滚从而保证所有节点在事务提交过程中能够保证一致性的算法,常用于分布式数据库管理。由于2PC能够处理许多临时的系统故障(如进程宕机、网络断开等),因此得到了较为广泛的应用。但是,2PC并不总能成功地恢复系统的故障,在极少数情况下,还是需要人为手动地干预才能补救。

在传统的数据库管理中,完成数据更改称为提交(Commit);撤销数据更改称为回滚(undo),用于保证事务的原子性;重新执行数据更改称为重做(redo),用于保证事务的持久性。单个数据库服务器可以通过事务日志实现回滚与重做,从而保证数据库的ACID特性。但是,在分布式数据库中,不同节点的服务器部署在不同地点,并且服务器之间只能通过网络进行通信,因此需要通过某种协议来协调不同节点进行统一的提交或回滚,这就是2PC设计的初衷。

1、协议流程

顾名思义,2PC将分布式事务的提交分为了两个阶段,分别是投票阶段和提交阶段。同时,为了进行分布式事务的统一调度,2PC中引入了协调者(Coordinator)节点的概念,协调者节点负责向所有参与方(Participants)节点发送统一的决策指令,并收集所有参与方节点的反馈进行下一步决策。2PC假设每个参与方节点都有一个稳定的、带有预写日志(Write-ahead Log)的存储介质,即所有参与方节点都不会无限宕机,宕机重启之后可以从预写日志中恢复正确的状态。

- 阶段一:投票阶段(Vote),投票阶段也称为请求阶段,在该阶段,协调者节点会请求所有参与方节点一致执行最新事务,并同步等待所有参与方节点进行投票表决,协调者节点将根据所有参与方节点的表决结果来决定是否进行后续的提交操作。

- ① 协调者节点向所有参与方节点发送一个包含最新事务的询问提交请求,询问参与方节点是否可以进行最新事务的提交,并等待所有参与方节点的响应。

- ② 参与方节点在收到询问提交请求后,本地执行最新事务(协调者节点询问是否可以提交的事务),并将undo日志与redo日志写入本地的稳定存储介质,但不进行真正的提交。

- ③ 每个参与方节点都根据自身执行情况反馈给协调者节点同意提交响应Yes或终止提交响应No。具体来说,当参与方节点本地执行成功时,反馈Yes;当参与方节点本地执行失败时,反馈No。

- 阶段二:提交阶段(Commit),在阶段二中,协调者节点会根据所有参与方节点的反馈结果决定进入事务提交流程或事务终止流程。

- 事务提交流程。当所有参与方节点的反馈都是Yes时,执行事务提交流程。

- ① 协调者节点向所有参与方节点发送提交请求。

- ② 参与方节点在收到提交请求之后,真正完成事务提交,释放事务期间占用的锁资源。

- ③ 参与方节点在完成事务提交之后,向协调者节点发送Ack响应。

- ④ 协调者节点在接收到所有参与方节点的Ack响应之后,完成事务提交流程。

- 事务提交流程。当所有参与方节点的反馈都是Yes时,执行事务提交流程。

-

- 事务终止流程。当有任何一个参与方节点超时未反馈或反馈为No时,执行事务终止流程。

- ① 协调者节点向所有参与方节点发送回滚请求。

- ② 参与方节点在收到回滚请求之后,根据阶段一中记录的undo日志进行本地事务的回滚,释放事务期间占用的锁资源。

- ③ 参与方节点在完成事务回滚之后,向协调者节点发送Ack响应。

- ④ 协调者节点在接收到所有参与方节点的Ack响应之后,完成事务终止流程。

- 事务终止流程。当有任何一个参与方节点超时未反馈或反馈为No时,执行事务终止流程。

提交阶段也称为执行阶段,在该阶段,协调者节点会根据阶段一中参与方节点的表决结果进行下一步决策。需要注意的是,2PC中并没有假定节点间的消息通信是同步通信,因此,阶段一中有可能出现某些参与方节点反馈超时的情况,而反馈超时不一定表明反馈的参与方节点执行失败,也有可能该参与方节点在本地执行成功了但是在反馈过程中消息传递失败了,而协调者节点为了尽量保证不被一个节点阻塞住,只能假定该参与方节点“执行出错”,从而进入事务终止流程。这是一种比较保守的应对策略,但是也是一种比较安全的策略,因为让执行正确的节点因为某些可能出错的节点进行一次回滚是没有问题的,但是让执行失败的节点因为某些可能成功的节点进行一次提交则是会出错的。

2、优缺点

2PC的优点在于易于理解、实现简单,可以在最优情况下以最小的成本保证数据的一致性,即要么所有节点一起提交,要么所有节点一起回滚。

2PC的缺点也非常明显,具体如下。

- 同步阻塞。在整个事务提交过程中,所有节点都处于阻塞状态,每个阶段都需要等待所有节点的响应,这是2PC的实际效率低的原因。同时,在整个事务提交过程中,所有节点持有的公共资源(如数据库资源)都处于抢占状态,第三方应用想要访问公共资源时会陷入阻塞状态。

- 单点故障。在整个事务提交过程中,协调者节点都是至关重要的,它负责向所有节点统一发送决策指令并收集所有节点的反馈消息,从而推进整个流程的前进。一旦协调者节点不可用,则整个集群将会一直处于阻塞状态,必须等到协调者节点恢复或选举出新的协调者节点才能继续推进。

- 数据不一致。

- 在阶段二中,如果协调者节点因为宕机或网络断开不能够将“提交”请求成功地发送给所有参与方节点,则会导致部分节点在收到提交请求后完成最终提交,而其他节点无法提交的情况。整个系统陷入不一致的状态,必须等到协调者节点恢复或选举出新的协调者节点才有可能重新进入一致的状态。

- 更致命的是,阶段二中出现协调者节点与参与方节点同时不可用的情况。例如,最先收到提交请求的参与方节点在完成提交之后宕机了,那么此时就算协调者节点恢复了或选举出了一个新的协调者节点,协调者节点也无法确定事务提交的状态。系统将进入一个“不确定状态”,必须等待所有的参与方节点都恢复之后,才能确定事务是否真正被提交了。

(2)3PC

2PC的优势在于在最优情况下(没有节点宕机或断网)的系统延迟是非常小的,但是任何一个节点不可用,会导致整个系统超时,从而导致延迟大大增加。

3PC(Three-phase commit),即三阶段提交,通过引入一个新的阶段消除2PC中因为某些节点故障导致的“不确定状态”,因此,3PC是非阻塞的。

1、协议流程

3PC是对2PC的扩展。3PC同样假设每个参与方节点都有一个稳定的、带有预写日志的存储介质,从而保证节点在宕机重启之后可以从预写日志中恢复出正确的状态。相比2PC,3PC主要有以下两个改进点。

- 引入超时机制。在3PC中,协调者节点与参与方节点都有各自的超时器。

- 增加“准备提交”阶段。3PC将2PC的阶段二(提交阶段)分为两个阶段,预提交阶段(PreCommit)与最终提交阶段(DoCommit)。

下面介绍3PC的流程。

- 阶段一:询问提交阶段。3PC的询问提交阶段(CanCommit)与2PC的投票阶段类似,参与方节点根据自身情况反馈Yes或No,但是该阶段参与方节点不执行事务。

- ① 协调者节点向所有参与方节点发送一个包含最新事务的CanCommit请求,询问参与方节点是否可以进行最新事务的提交,并等待所有参与方节点的响应。

- ② 参与方节点在收到CanCommit请求后,判断自身是否准备好了进行最新事务的提交,如果准备好了,则反馈Yes;否则反馈No。

- ③ 参与方节点在反馈响应之后,本地启动超时器等待协调者节点的阶段二请求(预提交或回滚)。

在阶段一中,协调者节点会询问所有参与方节点当前是否可以进行最新事务的提交,并同步等待所有参与方节点进行投票表决,协调者节点将根据所有参与方节点的表决结果来决定是否进行后续的提交操作。

- 阶段二:预提交阶段(PreCommit)。在阶段二中,协调者节点会根据所有参与方节点的反馈结果决定进入事务预提交流程或事务终止流程。需要注意的是,参与方节点在阶段二的事务预提交流程中才会开始真正地执行事务。

- 事务预提交流程。当所有参与方节点在阶段一的反馈都是Yes时,执行事务预提交流程。

- ① 协调者节点向所有参与方节点发送PreCommit请求。

- ② 参与方节点在收到PreCommit请求之后,本地执行最新事务,并将undo日志与redo日志写入本地的稳定存储介质,但不进行真正的提交。

- ③ 每个参与方节点都根据自身执行情况反馈给协调者节点,同意提交响应Yes或终止提交响应No。具体来说,当参与方节点本地执行成功时,反馈Yes;当参与方节点本地执行失败时,反馈No。

- ④ 参与方节点在反馈响应之后,本地启动超时器等待协调者节点的阶段三请求(提交或回滚)。

- 事务终止流程。当有任何一个参与方节点在阶段一超时、未反馈或反馈为No时,执行事务终止流程。

- ① 协调者节点向所有参与方节点发送回滚请求。

- ② 参与方节点在收到回滚请求或等待协调者节点阶段二请求超时之后,根据阶段一中记录的undo日志进行本地事务的回滚,释放事务期间占用的锁资源,完成事务终止。

- 事务预提交流程。当所有参与方节点在阶段一的反馈都是Yes时,执行事务预提交流程。

与2PC的不同点在于,3PC的阶段二中每个参与方节点不是同步阻塞式地等待协调者节点的请求,而是主动地根据自身超时器的情况做出下一个决策。如果按时收到协调者节点的请求,则根据协调者节点的请求进行后续操作;如果超时还未收到协调者节点的请求,则直接终止事务。

- 3)阶段三:最终提交阶段(DoCommit)。在阶段三中,协调者节点会根据所有参与方节点的反馈结果决定进入事务最终提交流程或事务终止流程。只有在事务最终提交流程中,节点才会进行真正地提交。

- 事务最终提交流程。当所有参与方节点在阶段二的反馈都是Yes时,执行事务最终提交流程。

- ① 协调者节点向所有参与方节点发送DoCommit请求。

- ② 参与方节点在收到DoCommit请求之后,真正完成事务的提交,释放事务期间占用的锁资源。

- ③ 参与方节点在完成事务提交之后,向协调者节点发送Ack响应。

- ④ 协调者节点在接收到所有参与方节点的Ack响应之后,完成事务。

- 事务终止流程。当有任何一个参与方节点在阶段二超时、未反馈或反馈为No时,执行事务终止流程。

- ① 协调者节点向所有参与方节点发送回滚请求。

- ② 参与方节点在收到回滚请求之后,根据阶段二中记录的undo日志进行本地事务的回滚,释放事务期间占用的锁资源。

- ③ 参与方节点在完成事务回滚之后,向协调者节点发送Ack响应。

- ④ 协调者节点在接收到所有参与方节点的Ack响应之后,完成事务终止。

- 事务最终提交流程。当所有参与方节点在阶段二的反馈都是Yes时,执行事务最终提交流程。

需要注意的是,在阶段三中,协调者节点有可能出现宕机或网络不可用的情况,从而导致某些参与方节点收到了DoCommit请求,某些没有收到DoCommit请求。对于收到DoCommit请求的参与方节点,可以直接进行本地提交,而对于超时未收到DoCommit请求的参与方节点,也可以继续进行事务的提交。

2、优缺点

3PC的优点在于引入了PreCommit阶段,解决了2PC的阻塞问题,即协调者节点可以在任意时刻发生异常。系统可以选出一个新协调者节点,而新协调者节点总是可以通过询问参与方节点的方式来获知当前系统的状态。

- 若事务在旧协调者节点发生异常之前就已经达到最终提交状态,那么所有参与方节点必然已经接收到PreCommit请求(否则旧协调者节点不可能进入最终提交状态),因此,新协调者节点可以获知当前所有节点已经发送过PreCommit请求,从而继续事务的提交。

- 若事务在旧协调者节点发生异常之前还没有达到最终提交状态,那么某些参与方节点必然还没有接收到PreCommit请求,从而新协调者节点也可以获知当前系统还未达到最终提交状态,可以选择终止提交或重新运行一遍完整的3PC。

但是,在上述场景中,所有参与方节点必须运行正常才能保证新协调者节点可以获知正确的状态。如果出现网络分区,则3PC仍然有可能出现数据不一致的问题。例如,在阶段二中发生了网络分区,所有接收到PreCommit请求的参与方节点处在网络分区1中,所有未接收到PreCommit请求的参与方节点处在网络分区2中,那么网络分区1中的参与方节点最终会因为超时自行进行最终提交,而网络分区2中的参与方节点在阶段二中会因为超时终止事务提交,从而导致整个系统不一致,此时就算网络恢复,新协调者节点也无法确定应该进行事务的提交还是回滚。

(3)Paxos

3PC解决了2PC的主要问题——单点阻塞问题,但是无法解决网络分区带来的数据不一致问题,即3PC保证了系统的活性,但是却牺牲了系统的安全性。与此不同的是,2PC虽然存在阻塞问题,但是在阻塞结束之后,总能恢复系统的一致性,即2PC保证了系统的安全性,但是却牺牲了系统的活性。那么是否存在一个算法能够同时保证系统的安全性与活性呢?答案是肯定的,它就是Paxos。

Paxos是第一个在异步模型下能够保证正确性且容错的共识算法。在此之前,FLP不可能定理明确指出,在异步模型中,只要存在节点故障,就不可能存在一个可终止的共识算法。因此,Paxos也做出了一定的牺牲:Paxos牺牲了一定的活性从而保证了系统的安全性,即在系统处于异步状态时暂停共识的推进,只要有半数以上的节点恢复至同步状态,就可以推进共识,完成终止。

总的来说,Paxos有如下三点特性。

- 安全性(Safety)

- 如果决策已经达成,那么所有节点都会同意相同的决策。

- 最终的决策值必须是由某些节点提出的。

- 无保证的终止性(No Guaranteed Termination)。Paxos不保证收敛到一个最终决策,但只有在非常极端的场景下才会出现。

- 容错性(Fault Tolerance)。可以容忍系统中少于半数的节点宕机,此时其他节点也可以达成一致。

1、协议流程

Paxos代表了一类分布式一致性协议,包括Basic Paxos、Multi Paxos、CheapPaxos、Fast Paxos等协议及其变体。其中,Basic Paxos主要描述了如何就一个值达成一致的决策,而Multi Paxos则针对分布式系统中如何就一系列的值达成一致的决策,RAFT其实是Multi Paxos的一种变体。

本节主要介绍Basic Paxos的协议流程。以下若无特殊说明,Paxos代指Basic Paxos。

Paxos协议流程类似于2PC,但是又存在一些不同点。在Paxos中,存在一个或多个节点同时想要竞选成为协调者节点(也叫作提案者,Proposer)的情况,而每轮共识最终只会选出一个Proposer进行最终提案值的选择。Proposer提出一个决策值,并收集其他参与方节点(也叫作接受者,Acceptor)的投票。最终,Proposer会宣布选定的最终决策值。如果能够达成一个最终决策,则该决策值会被传递到对此感兴趣的节点(也叫作学习者,Learner)中。可以看出,Paxos是一个保证公平性的协议,即所有节点都可以竞选成为Proposer,没有哪个节点拥有特殊的权利。

为了便于理解,本节忽略Learner的存在,仅通过参与共识的Proposer与Acceptor的视角来描述Paxos的共识流程。Paxos分为两阶段共识,如下图所示,分别是准备阶段(Prepare)与接受阶段(Accept)。所有的参与方节点在运行时都必须持久化如下几个值,以保证算法的安全性。

- Na,Va:本节点接受的最大提案号及其对应的值。

- Nh:本节点响应过的最大提案号。

- MYn:本轮共识中本节点提出的提案号。

- 阶段一:准备阶段

- 如果某节点想要发起提案,则直接选定一个提案号MYn(MYn> Nh),并向集群中的大部分节点发送包含MYn的Prepare(N)请求,其中N=MYn。

- 每个Acceptor在收到一条Prepare(N)请求后,首先判断其中的提案号N是否大于本节点响应过的Prepare请求中的Nh。

- ① 如果N≤Nh,则直接发送Propose-Reject拒绝消息给Proposer。

- ② 否则,发送一个承诺响应Promise(Na,Va)给Proposer,并更新Nh=N,承诺本节点不会再接受任何提案号小于N的提案。其中,(Na,Va)是本节点接受的最大提案号及其对应的值,如果本节点未接受过任何提案,则Na与Va均为空值NULL。

- 阶段二:接受阶段

- 如果Proposer收到了大部分(超过半数)节点关于Prepare(N)请求的响应,则Proposer找出这些响应中提案号最大的Promise(Nn,Vn),并向这些Acceptors发送Accept(N,Vn)请求;如果所有节点的响应都是NULL,那么Proposer就任意选择一个本地想要提出的提案值V,向这些Acceptors发送Accept(N,V)请求。

- 当Acceptor接收到一条Accept(N,V)请求时,判断Nh是否大于当前Accept请求的N。

- ① 如果N<Nh,则直接发送Accept-Reject拒绝消息给Proposer。

- ② 否则,发送一个同意响应给Proposer,并更新Na=Nh=N,Va=V。

2、活锁

Paxos看似实现了一个完美的异步共识算法,但是它无法逃脱FLP不可能定理的限制。在若干个Proposer相继提出包含更大提案值的提案时,Paxos有一定的可能性进入活锁(Live Lock)状态,从而无法达成共识。例如,在一个由2个Proposers及3个Acceptors组成的共识网络中。

- Proposer1提出Prepare(N)请求。

- 3个Acceptors都能接收到Prepare(N)请求,从而响应Promise(N)请求并更新本地的Nh=N。

- Proposer1陆续收到来自3个Acceptors的Promise(N)请求并发出Accept(N)请求。

- 但是,3个Acceptors在接收到Proposer1的Accept(N)请求之前先接收到了来自Proposer2提出的Prepare(N+1)请求,从而先响应Promise(N+1)请求并更新本地的Nh=N+1。

- 随后,3个Acceptors才接收到Proposer1的Accept(N)请求,此时本地的Nh已经变成N+1,大于Proposer1请求的N,因此拒绝Proposer1的Accept(N)请求。

- 随后,Proposer1立马提出Prepare(N+2)请求。

- 同样地,3个Acceptors在接收到Proposer2的Accept(N+1)请求之前先接收到了来自Proposer1提出的Prepare(N+2)请求,从而先响应Promise(N+2)请求并更新本地的Nh=N+2。

- 随后,3个Acceptors才接收到Proposer2的Accept(N+1)请求,此时本地的Nh已经变成N+2,大于Proposer2请求的N+1,因此拒绝Proposer2的Accept(N+1)请求。

- 如此往复,可能永远处在这种交替发出提案的循环中无法终止。

由此可见,Paxos仍然无法避开FLP不可能定理的限制,在一定条件下有可能进入无法达成共识的死循环。常见的解决思路是选择一个固定的Proposer,或者给不同的Proposer设置不同的超时时间(如设置为一个随机数)来尽可能减小上述情况出现的可能性,但是在异步网络中依旧无法避免上述情况的出现。

3、优缺点

Paxos相比2PC与3PC的最大优点就在于其同时保证了系统的安全性与一定的活性(最终一致性),Paxos能够达成最终一致性的原因在于其实现了如下两个机制。

- 平等共识与特殊的排序规则:在Paxos中,没有一个节点拥有特权,任何节点都可以主动发起提案,因此一旦Proposer发生故障,另外的节点可以立马接管Proposer的角色。同时,Paxos中特殊的排序规则保证了就算存在多个Proposer同时提出不同的提案值,最后也能收敛到一个最终值。Prepare阶段仅用来确认“提案权”,Accept阶段才确认“最终值”,而这个最终值是目前为止第一个收到大多数节点投票的提案值,不一定是当前Proposer提出的提案值。

- 绝大多数(Majority)共识:Paxos中不再要求每轮共识都等待所有节点的一致投票,而仅需要半数以上的节点投票,因此Paxos也是一个容错的共识算法。同时,由于任意两个“绝大多数共识”之间必然存在交集,因此在不考虑节点作恶的情况下,Paxos在出现网络分区之后依然能够保证系统的安全性。

Paxos在一定程度上给出了一种在异步网络下分布式一致性问题的解决范式,但是其本身的算法过于晦涩难懂,以至于Lamport本人也在Paxos发表之后又写了一篇论文来重新解释Paxos的共识流程。同时,一个Paxos的正确实现被证实是非常有难度的挑战,有兴趣的读者可以阅读Chandra、Griesemer、Redstone的实践论文来理解实现过程中的一些权衡与考量。

(4)RAFT

Paxos诚然是一个非常有影响力的共识算法,可以说奠定了分布式一致性算法的基础,但是由于其难以理解且实现难度大,沉寂了很长一段时间。直到后来Chandra、Griesmer、Redstone将其用到Chubby中实现了一种分布式锁服务,Paxos才渐渐为人所知并名声大噪。直到今天,想要实现一个完整的Paxos依旧非常困难。因此,出现了非常多的Paxos变体,其中最著名的当属RAFT。

RAFT是一种用来管理日志复制的一致性算法,旨在易于理解。它具备Paxos的容错性和性能,不同之处在于它将一致性问题分解为相对独立的三个问题,分别是

- 领导选取(Leader Election)

- 日志复制(Log Replication)

- 安全性(Safety)

这使得RAFT更好理解,并且更容易应用到实际系统的建立中。此外,RAFT还推出了一种新的机制以支持动态改变集群成员。相比Paxos,RAFT有如下几个特性。

- 强领导者:RAFT使用一种比其他算法更强的领导形式。例如,日志条目只从领导者(Leader)发送给其他服务器,从而简化对日志复制的管理。此外,RAFT对Leader(主节点)选举的条件做了限制,只有拥有最新、最全日志的节点才能够当选Leader,这减少了Leader数据同步的时间。

- 领导选取:RAFT使用随机定时器来选取Leader。这种方式仅在所有算法都需要实现的心跳机制上增加了一点变化,使得解决选举冲突更加简单和快速。

- 成员变化(Membership Change):RAFT为了调整集群中的成员关系,使用了新的联合一致性(Joint Consensus)方法,让大多数不同配置的机器在转换关系时进行交叠(Overlap)。这使得在配置改变时,集群能够继续运转。

1、基本概念

在RAFT中,每个节点一定会处于以下三种状态中的一种:

- Leader(主节点)

- Candidate(候选节点)

- Follower(从节点)

在正常情况下,只有一个节点是Leader,剩下的节点都是Follower。Leader负责处理所有来自客户端的请求(如果一个客户端与Follower进行通信,那么Follower会将信息转发给Leader),生成日志数据(对应在区块链中即负责打包)并广播给Follower。Follower是被动的,它们不会主动发送任何请求,只能单向接收从Leader发来的日志数据。Candidate是在选举下一任Leader的过程中出现的过渡状态,任何一个节点在发现主节点故障之后都可以成为Candidate,并竞选成为Leader。

RAFT将时间划分为任意不同长度的term(任期)。任期用连续的数字表示。每个任期的开始都是一次选举。如果一个Candidate赢得了选举,那么它就会在该任期的剩余时间内担任Leader。如果选票被瓜分,没有选出Leader,那么另一个任期将会开始,并且立刻开始下一次选举。

每台服务器都存储着一个数字作为当前任期的编号,这个数字单调递增。当节点之间进行通信时,会互相交换当前任期号,若一个节点的当前任期号比其他节点小,则更新为较大的任期号。如果一个Candidate或Leader的任期号过时了,则会立刻转换为Follower。当一个节点收到过时任期号的请求时,会直接拒绝这次请求。

2、主节点选举(Leader Election)

RAFT使用一种心跳机制(Heartbeat)来触发Leader的选举。当节点启动时,它们会初始化为Follower。若节点能够收到来自Leader或Candidate的有效消息,则它会一直保持Follower的状态。Leader会向所有Follower周期性地发送心跳信息来保证其Leader地位。如果一个Follower在一个周期内没有收到心跳信息,那么它会开始选举,以选出一个新的Leader。

在开始选举之前,一个Follower会自增它的当前任期号,并转换为Candidate。随后,Candidate会给自己投票并向集群中的其他节点发送RequestVote请求。一个节点会一直处于Candidate状态,直到发生下列三种情况之一。

- 它赢得了选举。

- 另一个节点赢得了选举。

- 一段时间后没有任何一个节点赢得选举。

有如下几种情况可能发生:

- 情况1:一个Candidate如果在一个任期内收到了来自集群中大多数(超过一半)节点的投票就会赢得选举。在一个任期内,按照先到先服务原则(First-Come-First-Served),一个节点将选票投给它收到的第一个RequestVote请求相对应的Candidate。大多数原则使得在一个任期内最多有一个Candidate能赢得选举。如果有一个Candidate赢得了选举,则它会成为Leader。然后向其他节点发送心跳信息,从而建立自己的领导地位,并阻止新的选举。

- 情况2:当一个Candidate等待其他节点的选票时,它有可能会收到来自其他节点发来的声明其为Leader的心跳信息。如果这个Leader的任期号比当前Candidate的任期号大,则Candidate认为该Leader合法,并转换自己的状态为Follower。如果在这个Leader的任期号小于Candidate的当前任期号,则Candidate会拒绝该心跳信息,并继续保持Candidate状态。

- 情况3:一个Candidate既没有赢得选举也没有输掉选举。如果许多Follower在同一时刻成为了Candidate,则选票会被分散,可能没有Candidate获得大多数选票。当这种情况发生时,每个Candidate都会超时,并且通过自增任期号和发起另一轮选票请求来开始新的选举。然而,如果没有其他方式分配选票,那么这种情况可能会无限地重复下去。

RAFT采用随机选举超时时间来尽可能地避免情况3的发生。为了防止在一开始选票就被瓜分,选举超时时间是在一个固定的间隔内随机选出来的(如150~300ms)。这种机制使得在大多数情况下只有一个节点会率先超时,它会在其他节点超时之前赢得选举,并向其他节点发送心跳信息。每个Candidate在开始一次选举时都会重置一个随机的选举超时时间,在进行下一次选举之前一直等待。这能够减小在新的选举一开始选票就被瓜分的可能性。

3、日志复制(Log Replication)

Leader一旦被选出,它就开始接收客户端请求。每个客户端请求都包含一条需要被复制状态机执行的命令。Leader把这条命令作为新的日志条目加入日志记录,然后向其他节点广播AppendEntries请求,要求其他节点复制这个日志条目。当这个日志条目被安全复制之后,Leader会将这个日志条目应用到它的状态机中,并向客户端返回执行结果。如果Follower崩溃了或运行缓慢,或者网络丢包了,那么Leader将会无限重发AppendEntrie请求(甚至在它向客户端响应之后),直到所有的Follower最终都存储了所有的日志条目。

在RAFT中,日志如下图所示进行组织。每个日志条目都存储着一条被状态机执行的命令和这条日志条目被Leader接收时的任期号。日志条目中的任期号用来检测不同节点上的日志的不一致性。每个日志条目也包含一个整数索引,来表示它在日志中的位置。

当Leader创建的日志条目已经复制到大多数服务器上时,这个日志条目就称为可被提交的Committed状态(见下图中的7号日志条目)。RAFT保证已被提交的日志条目是持久化的,且最终会被所有可用的状态机执行。Leader跟踪记录它所知道的被提交日志条目的最大索引值,然后将这个索引值添加在之后的AppendEntries请求中(包括心跳信息),从而让其他服务器知道这个日志条目已被提交。一旦一个Follower知道了一个日志条目已被提交,就会将该日志条目应用至本地的状态机(按照日志顺序)。

典型共识算法

前文描述的分布式一致性算法通常基于如下假设:分布式系统中不存在拜占庭节点,即只考虑节点出现宕机、网络故障等问题,不考虑节点篡改数据、向不同节点发送不一致消息等恶意情况。

因此,分布式一致性算法通常被应用在数据库管理中实现多机备份。在实际应用中,这些备份机器往往分布在一家机构的不同机房中,即备份机器之间是相互信任的,不会出现节点作恶的情况。

但是,区块链系统上承载的是价值传输,且参与方的身份多变。在联盟链中可能是多个利益参与方,而在公有链中,则是任意一个可以连入区块链网络的个体,区块链节点完全有可能为了自身利益而发送错误的信息。因此,在设计区块链共识算法的时候,不可避免地要考虑节点作恶的情况,如双花攻击、51%算力攻击等,这种由节点主动发起的恶意行为是典型的拜占庭行为。

在区块链共识算法中,为了应对拜占庭行为,有如下两种不同的解决思路:

- 一种是通过设计在理论上容忍拜占庭错误的共识算法来解决,如经典的PBFT共识算法、新型的HotStuff等

- 一种则是通过增加作恶成本来尽可能避免拜占庭行为。例如,比特币系统中使用的PoW共识算法需要51%及以上的算力才能作恶。拥有51%及以上的算力是很难达到的,并且相比作恶,每个区块的区块奖励也是不菲的,因此绝大多数节点不会想要浪费巨大的资源去作恶,最终保证比特币系统几乎能够完全避免拜占庭行为。

在将共识算法应用到区块链系统中时,通常需要考虑算法实现的复杂度与实用度。在公有链与联盟链的设计中,考虑的侧重点不同,最终的算法选择也有所差异。

- 公有链侧重节点规模与安全性,因此考虑使用证明类共识算法来提升系统的规模,使用经济激励机制来保证系统的安全性

- 联盟链/私有链侧重高性能和低延迟,因此考虑使用确定性共识算法来快速达成最终一致性,并根据需求选择拜占庭容错或非拜占庭容错算法。

(1)PoW共识算法

PoW最早在1993年由Cynthia Dwork与Moni Naor在学术论文中提及,并于同年由Markus Jakobsson与Ari Juels正式提出。起初,PoW主要用于防止垃圾邮件的产生。2008年,PoW作为共识算法应用在比特币系统中。

1、基本概念

数学难题

PoW共识算法设计了一个数学难题(Mathematical Puzzle),要求节点在生成新区块之前,需要消耗一定的计算资源才能获得难题的解,从而将区块广播到网络,并且其他节点可以轻易验证这个解的有效性。

哈希算法

哈希算法(Hash Algorithm)是一种能够把任意长度的输入变换成固定长度的输出的算法,记为y=Hash(x),不同的输入x得到的输出y各不相同。除此之外,在已知x时可以快速计算得到y,但是在已知y的情况下,通常只能通过穷举法才能逆推出x。

由于哈希算法具有正向快速、逆向困难的特性,因此常使用哈希算法来设计PoW共识算法的数学难题。

挖矿与矿工

在一轮区块生成中,系统通过对输出值设定条件来调整数学难题的难度,节点在成功解出难题且通过验证上链后,将会获得相应的比特币奖励。这个过程被形象地称为“挖矿”(Mining),而参与挖矿的节点被称为“矿工”(Miner)。

2、共识流程

在生成新的区块之前,PoW共识算法会预设目标值htarget,要求矿工计算出的哈希值小于该目标值,以此来表示PoW共识算法的难度。为了生成区块并获得比特币奖励,矿工首先收集一组交易打包成一个区块,并尝试解决数学难题进行挖矿。在此期间,矿工需要生成随机数nonce,同当前区块数据datacurrent与上个区块的哈希值hprev进行多轮哈希计算,当前区块的哈希值hcurrent为

直到当前区块哈希值hcurrent满足条件

直到当前区块哈希值hcurrent满足条件

此时的nonce为本次数学难题的解,矿工将作为区块头数据加入当前区块,如下图所示。然后将该区块广播到区块链网络,等待验证通过后,矿工就可得到相应的比特币奖励。

htarget越小,PoW共识算法的难度越大,生成满足要求的区块难度越高。通过调整区块难度,可以控制节点生成区块的大致时间,从而要求节点达到一定的工作量。

在比特币系统中,所有节点同时挖矿,最先计算出有效区块的节点将获取记账权,可以将区块加入网络。但是,系统内存在传播延迟,如果生成区块的速率过快,可能会使部分节点在没有收到最新区块消息的情况下,同时完成区块计算,生成多个有效区块,从而导致区块链产生分叉(Fork),如下图所示。

网络传输存在延迟,区块的生成速度越快,在同一时刻生成多个有效区块的概率越大,区块链产生分叉的可能性越高。这不但浪费计算资源,还使系统更容易被攻击。在最初的设计中,为了在保障一定交易吞吐量的同时降低分叉的概率,比特币限制矿工生成区块的平均时间在10分钟左右。PoW共识算法的难度会根据当前区块的生成情况进行调整,将生成区块的平均时间控制在10分钟左右。

3、最长链原则

上文提到,当有多个矿工同时生成新区块,并在网络中广播时,区块链会产生分叉。如果发生了这种情况,通常以最长链原则来应对,即选择一条最长的链作为主链,矿工挖矿与数据同步都以最长链为标准。如果存在长度相同的链,那么就从中随机选取一条进行挖矿。

如下图所示,当区块链产生分叉时,逻辑上会形成两条子链:A—B—C—D1—E,A—B—C—D2。矿工在生成新区块时将选取其中一条进行挖矿,在完成挖矿后会产生一条最长链。此时,A—B—C—D1—E将作为主链,A—B—C—D2会被舍弃,D2中的交易将被回滚,重新放回交易池,等待重新被打包。

最长链原则作为识别主链的方式,被大部分共识算法采用,如PoW、PoS、DPoS等,都将最长链作为主链,信任其中记录的数据。

在比特币系统中,交易即使被打包进一个区块,也有可能产生分叉,导致交易被回滚,因此通常需要等待额外几个区块生成以后,才可以认为当前交易已经不可回滚,进入相对确定的状态。一般来说,在连续生成六个区块后,第一个区块里的交易就很难被篡改,可以被认为完成确认,所以一笔交易在比特币系统中的确认时间大约为1小时。

4、算法应用问题

51%攻击问题

在比特币最初的设计思路中,中本聪计划使用一CPU一票的机制实现公平的去中心化决策。对于使用PoW共识算法的区块链系统来说,保证去中心化的方式就是将算力分散到所有参与方手中,每个参与的矿工都有生成新区块的机会。而单个节点的算力有限,其生成区块的速度无法超越整体,也就无法破坏区块链系统,攻击者也就无法通过注册多个账号来提高自己完成挖矿的效率,从而有效地抵抗女巫攻击,保证去中心化决策的正常进行。

但是,如果攻击者掌握的算力超过系统整体的一半,就可能垄断区块的生产,从而掌握整个系统,这就是51%攻击(51% Attack,Majority Attack)。攻击者可以主动对区块链进行分叉,并忽略其他矿工生成的新区块。由于其算力占系统的绝大部分,因此攻击者生成区块的速率更快,最终攻击者生成的区块链长度会超过正确的主链长度。按照最长链原则,攻击者生成的区块链会作为主链,而真正的主链会被拒绝。

不过,51%攻击并不是一种经济的做法,它需要攻击者付出大量的算力成本,并且在51%攻击行为被发现后,有可能会引发整体币值下降,从而导致财产缩水,增高发起攻击的代价。

算力集中问题

随着计算机技术的进步,挖矿手段也产生了很大的变化,大致经历了CPU挖矿、GPU挖矿、GPU集群挖矿、FPGA矿机、ASIC矿机、矿池(ASIC集群)阶段,GPU运算能力是CPU的几百倍,FPGA是GPU的数十倍,ASIC是FPGA的数千倍,多个ASIC矿机又可以组成矿池。

单个节点的算力飞速提升,需要使用更加专业化的设备才能有效参与挖矿竞争。这使得挖矿的成本提高且难以控制,只有计算资源高度集中的矿池才能负担得起这种成本投入。如下图所示,世界上规模排名前五的矿池掌握的计算资源占据全部比特币网络计算资源的一半以上。计算资源的集中,导致理想状态下的去中心化形式越来越难以满足,PoW共识的公平性、去中心化程度开始被破坏。

资源消耗问题

在一轮挖矿过程中,矿工需要消耗大量的资源来解决数学难题,但是,这些数学难题除了满足PoW共识算法的要求,对于其他领域没有太多价值。加密货币信息网站Digiconomist的数据显示,截至2017年,我国投入到比特币和以太坊挖矿的电力已经超过约旦、冰岛、利比亚等国家,在所有国家和地区电力消耗中排名第71位,造成了巨大的资源浪费。

吞吐量问题

使用PoW共识算法的系统,为了尽可能降低分叉概率,区块生成速率相对较慢,交易确认时间较长。在比特币系统中,平均需要10分钟才能完成出块,并经过约1小时才能完成交易确认,交易吞吐量非常低,很难满足实际应用需求。

(2)PoS共识算法

区块链共识算法可以被看作一种选举机制,通过集体参与的方式选出领导者,由领导者进行本轮区块的生成,从而避免单个用户或集团长期控制账本,并维持区块链系统整体的一致性。

前面提到的PoW共识算法是通过算力来争夺领导者资格的,但是PoW过程中的大量资源浪费,导致其很难被更大规模的应用接受。对此,有人开始尝试直接使用“股份”(Stake)作为标准进行领导者资格的竞选,并随之产生了权益证明(Proof of Stake,PoS)共识算法。

PoS的思想起源于企业的股份制:一个人拥有的股份越多,其获得的股息和分红就会越高。如果区块链系统也采用这种方法进行维护,则不需要过多的资源消耗,也能够使区块链资产有自然的通胀。节点通过投入一定量的虚拟货币参与共识,根据持币情况获得打包新区块的权利,并获得奖励。

1、基本概念

验证者

在PoS共识算法中,将参与共识的节点称为验证者节点(Validator)。任何拥有虚拟货币的节点都可以通过发送特殊交易的方式,将部分虚拟货币转为“股份”,从而成为验证者节点。完整的验证者节点集合(Validator Set)由区块链系统负责维护。

币龄

为了描述持币情况,PoS共识算法引入了“币龄”的概念。币龄(Coinage)表示节点持有部分虚拟货币的时长,当节点将虚拟货币作为股份投入后,这部分虚拟货币就开始积累币龄,币龄的计算方式如下

在使用了这部分虚拟货币后,无论是用来进行区块生成还是简单的交易,这部分虚拟货币对应的币龄都将被销毁。在最初的PoS共识算法中,币龄是进行评判的重要标准,节点在区块生成时所使用的币龄越大就越容易生成区块,如点点(Peercoin),这可以在一定程度上制约短期投机行为。

2、共识流程

PoS共识算法在进行区块生成时,将同时考虑币龄与哈希计算难度,使得节点只需要消耗很少的计算资源就可以完成区块生成,流程如下。

与PoW共识算法类似的是,PoS共识算法同样需要生成随机数nonce,同当前区块数据datacurrent与上个区块的哈希值hprev进行多轮哈希计算,得到当前区块哈希值hcurrent,使计算的结果满足难度要求。

与PoW共识算法不同的是,PoS共识算法的难度要求加入币龄的影响,只要计算得到的结果满足如下条件,就可以完成区块生成

在这种情况下,节点更容易获得满足需求的哈希值,拥有币龄越高的节点越容易获得区块,从而节省这部分计算资源的支出。在区块生成时,这部分币龄对应的货币会随之广播到全网进行验证。在通过验证后,这部分货币将被赎回,同时对应的币龄归零,出块者也会获得一定的奖励。

3、与PoW共识算法相比的优势

PoW共识算法需要消耗大量的资源进行算力认证,以此来保证区块链系统的安全性,以太坊与比特币作为PoW共识算法最常见的应用,每天需要消耗大量电力用于完成共识,这部分资源除了完成共识任务,并没有其他贡献,无疑是巨大的资源浪费。而PoS共识算法的出块权取决于验证者节点拥有的股份,并不需要节点支付过多的算力,更加经济。

4、实际应用问题

Nothing at Stake

Nothing at Stake(无利害关系,[email protected])问题[17],本质为“无成本作恶”问题。在PoW共识算法中,节点需要花费算力来争取出块机会,如果产生了分叉,则无法分出多余的计算资源在多个链上出块,只能选择自己认可的链进行挖矿,也就能够在有限时间内决出最长链,从而达成区块链节点之间的共识。而在PoS共识算法中,如果产生了分叉,则节点可以在无任何损失的情况下同时为多条链出块,从而获得所有收益,整个系统可能无法达成共识。

由于无法对分叉进行有效制约,因此无利害关系问题会让双花攻击变得更加容易。在PoW共识算法中,节点需要获取51%及以上的算力才有可能对系统发起攻击。而在PoS共识算法中,攻击者只需要支付很少的算力就可以生成区块,轻易地对区块链进行分叉,并利用无利害关系问题达成双花攻击的目的。

Long Range Attack

Long Range Attack(长程攻击)指的是从创世区块开始,创建一条比当前主链还要长的区块链,并篡改交易历史,用它来代替当前主链。因此,长程攻击也被称为历史覆盖攻击。

新节点或长期离线的节点在同步新的区块数据时,并不能清楚地分辨出主链。而且在PoS共识算法中,区块的生成与计算资源关系不大,节点可以通过某种方式篡改历史区块,私自制作一条最长链。根据最长链原则,很有可能出现真正的主链被替代的情况,典型的长程攻击共有三种。

- 简单攻击(Simple Attack),指的是攻击者通过缩短区块生成时间,从而在单位时间内尽可能多地在分叉链上生成区块,以此超过原主链长度发起攻击。这种攻击行为相对简陋,可以通过查询异常时间戳进行过滤。

- 变节攻击(Posterior Corruption),指的是分叉链验证人通过获得旧验证人的私钥,在分叉链上加速完成超过主链长度的一种攻击方式。发展较长的区块链项目,可能已经更换了几轮验证人,旧验证人的私钥依旧可以签署以前的旧区块,分叉链验证人通过购买、行贿或破解的方式获得旧验证人的私钥,从而签署合理的区块,达到加速的目的。

- 权益流损(Stake Bleeding),指的是分叉链验证人通过延长在主链的区块生成时间,同时通过累计分叉链权益,以加快分叉链出块速度的攻击方式。一般分叉链上的验证人也是原主链上的验证人,当验证人在原主链上获得出块机会时,验证人会通过某种方式延迟出块或不出块,为分叉链争取出块时间,从而逐渐超过主链长度。

冷启动问题

由于PoS共识算法中币龄越大的节点越容易获得记账权,所以参与方节点更希望囤积更多的代币,而很少进行交易,这就造成了纯粹的PoS公有链系统无法进行冷启动。因此,在实际运行时,一般采用PoW共识算法启动整个区块链系统,再切换到PoW+PoS方式,最后才使用纯粹的PoS共识算法运行系统。

目前,以太坊正处于由PoW共识算法向PoS共识算法转型的阶段。

(3)DPoS共识算法

在委托权益证明(Delegated Proof of Stake,DPoS)共识算法中,持币者通过选举产生代表,由代表进行直接的区块生成,持币者通过选举代表间接行使竞争出块的权利。DPoS共识算法实际上通过一系列选拔规则对候选人进行制约,并制定一套投票规则。普通参与方节点通过投票的方式从候选人中选举见证人,并由见证人进行出块,不满足要求的见证人将被取消权限,并重新选举产生新的见证人。

DPoS共识算法保留了一定的中心化特性,因此能够保证高效率的交易吞吐,速率可以比肩常见的中心化机构,如Visa、Mastercard等。在该共识算法中,去中心化特性主要体现在对于生成区块的权利可控方面,即股东通过投票,选择自己信任的代表节点,并由代表节点进行区块链数据的维护。

1、基本概念

候选人

只要满足了基本条件,就可以成为候选人,

参与见证人竞选,申请成为候选人需要遵循一定的规则。在竞选见证人之前,候选人需要注册独有的身份,这个身份将被用于节点选举。在与身份信息相关的结构中,将保留个人的状态信息及详细介绍,以供投票人参考。

投票人

只要节点持有货币,就可以作为投票人。

根据自身设置的条件向自己认可的候选人投票。

见证人

见证人(Witness)为直接负责区块链维护的节点,通常具有以下特征:

- 能够直接生成和广播区块

- 能够收集网络中的交易并打包

- 能够对区块进行签名

见证人的位置由上个区块的最后部分随机指定。

受托人

在早期的DPoS项目BitShares中,还有受托人(Delegates),其主要功能为维护系统各项参数,如打包区块的时间间隔等。在后期的DPoS项目EOS.io中,只保留了能够生成区块的见证人。无论是见证人还是受托人,都是由投票人投票产生的,而系统的去中心化,也是由这种投票机制进行体现的。

2、共识流程

DPoS共识算法的共识流程,实际上就是选举出见证人,并由见证人轮流进行区块生成的循环流程。投票人可以适时更新自己的选票,然后在每轮循环中,区块链系统都会重新统计候选人得票,并选择出N个见证人。把见证人的排序打乱后,见证人轮流生成区块,在一个生产周期结束后,进入下一个生产周期,重新进行见证人选举。

候选人注册

候选人注册时,需要提供必要的信息标识。信息标识是否在线,如果已经下线,则不再计算票数,在这种状态下即使收到选票,在重新登入时也不会被统计在内;提供接口,使得外界可以获取到当前候选人的状态。其中,候选人需要提供个人介绍、网站等额外信息,以供投票人参考。

此外,候选人在注册时,需要支付一定的注册费用,一般这笔费用为生成单个区块平均奖励的上百倍。由于需要支付高额的注册费用,因此候选人在成为见证人后,通常需要生成上千个区块才能达到收支平衡,这防止候选人不认真履行维护区块链数据的责任。

投票

为了对候选人进行投票,每个投票人都会记录部分必要的信息,包括可信代表、非可信代表等。

- 可信代表(Trusted Delegates)用于记录投票人信任的代表节点

- 非可信代表(Distrusted Delegates)用于记录投票人不信任的代表节点

投票人在进行投票时,会从尚未成为见证人的可信代表中,选择最有可能成为见证人的投出支持票;或者从已经成为见证人的非可信代表中,选择其中一个进行反对。此外,投票人还会根据候选人成为见证人后的表现对其评分,维护可见代表(Observed Delegates)列表,统计分数进行排名。对于一个DPoS区块链系统,由系统负责记录当前见证人的顺序,后续每轮区块产生的顺序都与此相关。同时,社区会维护当前候选人的排名(Ranked Delegates),这个排名根据每个候选人收到的投票情况产生。

区块生成

区块链系统的所有参与方都可以查询到当前的见证人顺序,每当候选人的排名更新时,见证人列表也会随之更新,并在更新后进行乱序。根据当前的见证人顺序及当前时间,可以计算每个见证人生成下一个区块的时间表。当达到某个时刻时,对应的见证人进行区块签发,其他节点也可以根据这个时间表进行验证,区块生成时间的计算过程大致如下。

- 根据UTC时间与区块生成间隔,计算当前时间:

- 根据当前时间,计算当前轮次:

- 根据当前轮次、当前代表的位置(RANK)、区块生成间隔,计算区块生成时间:

- 如果计算得到的区块生成时间小于当前时间,那么通过再增加一轮时间间隔,计算区块生成时间:

- 当区块有效性验证通过后,该区块将加入区块链,代表节点将获取相应的手续费。

3、同PoW共识算法和PoS共识算法的关系

由于挖矿对于算力的要求,因此以PoW共识算法运行的系统,加入矿池才是普通用户参与挖矿最保险的方式。在这种运行方式中,散户矿工类似DPoS共识算法中的投票人,矿池的运营者类似见证人,通过这种方式组织起来的区块链维护模式,就是一种类似DPoW共识算法的共识形式。

在当前的运营模式下,如果存在系统的管理者,其更希望用户能够在矿池间切换以保证系统不过度中心化,这种方式类似选票的切换。然而,较大的矿池已经拥有了超过10%的算力,前五名的矿池已经控制了整个网络。如果其中任何一个矿池出现问题,区块生成效率就会瞬间下降,并且需要手动干预对其中的用户进行切换或恢复,系统维护相对困难。

而在PoS系统中,如果希望更高效率地进行区块维护,参与挖矿的节点可以选择委托制的方式,集合更多的股份来争取打包区块的机会,从而共同获取更多的手续费。

因此,DPoS共识算法的设计者认为,从规模化角度看,PoW共识算法与PoS共识算法都有走向委托制的倾向,存在中心化风险。因此,在系统建设初期就设计好如何进行权益分配与权利制约,有利于用户更好地控制系统,从而避免被动演化导致的不可预期的结果。

4、实际运行时的问题

采用DPoS共识算法的区块链系统,如EOS.io、BitShares,能够达到上千级甚至上万级的交易吞吐量,满足绝大部分日常应用的需求。但是,这种运行方式在诞生之初就在一定程度上削减了去中心化程度。在实际运行过程中,许多投票人并没有履行投票的职责,从而造成这种运行方式的中空。

(4)PBFT(实用性拜占庭容错,Practical Byzantine Fault Tolerance)共识算法

上述提到的共识算法大多用于公有链场景。例如,应用了PoW、PoS共识算法的系统,其由于交易吞吐量普遍较低及交易确认延迟较高等问题,无法在实时性要求较高的场景中使用。

在企业级场景下,节点数量不会非常多,但是对于交易吞吐量及最终确定性要求较高,因此常用联盟链来进行建设,从而满足企业级需求。

在实际应用场景中,根据不同的需要可以选择不同的共识模型。

- 在拜占庭的联盟链环境下,可以优先考虑使用PBFT共识算法及其变体

- 在信任程度比较高的环境下,如果不考虑拜占庭容错,则优先考虑RAFT、PBFT等确定性共识算法,其优势在于在算法层面保证了交易的最终确定性,即已经提交的交易不存在回退的可能。

- 此外,PBFT等确定性共识算法的交易交易吞吐量通常远高于证明类共识算法,因此非常符合联盟链高交易吞吐量、低延迟的需求。

实用性拜占庭容错(Practical Byzantine Fault Tolerance,PBFT)共识算法是一种在信道可靠的情况下解决拜占庭将军问题的实用算法。

拜占庭将军问题最早由Leslie Lamport等在1982年发表的论文中提出,论文中证明了在将军总数n大于3f,叛徒为f或更少时,忠诚的将军可以达成命令上的一致,即n≥3f+1,算法复杂度为O(nf+1)。随后,MiguelCastro和Barbara Liskov在1999年发表的论文中首次提出了PBFT共识算法,该共识算法的容错数量也满足n≥3f+1,算法复杂度降低至O(n2)。

1、基本概念

最大容错节点数

在前面的章节中,我们已经对拜占庭将军问题进行了讲解。PBFT共识算法同样需要遵循这个基本要求:在节点总数为n的集群中,为了保证在有最多f个拜占庭节点时共识算法的活性与安全性,需要满足关系n≥3f+1。在一轮共识过程中,可能会有f个拜占庭节点故意不响应,为了满足算法活性的要求,我们需要在收到最多来自n-f个节点的响应后做出判断。不过,当我们收到n-f条响应时,实际上无法判断其他f个节点是否为拜占庭节点,因此在收到的响应中,依然可能包含最多f个拜占庭节点的响应。为了满足算法安全性的要求,我们需要保证:在收到的响应中正确节点响应的数目应当高于拜占庭节点,即n-2f≥f。

综上所述,我们可以获得节点总数与拜占庭节点数目上限的关系:n>3f,即n≥3f+1。

quorum机制

在明确最大容错节点数与节点总数的关系后,我们需要关注PBFT共识算法中另外一个重要的概念——quorum机制。这是一种在分布式系统中常用的,用于保证数据冗余和最终一致性的投票机制,其主要数学思想源于鸽巢原理。

为了更好地理解quorum机制,我们先来了解一种与之类似,但是更加极端的投票机制——WARO(Write All Read One)机制。在使用WARO机制维护节点总数为n的集群时,节点执行写操作时的quorum值应当为n,而执行读操作时的quorum值可以设置为1。也就是说,在执行写操作时,需要保证全部节点完成写操作才可视该操作为完成,否则写入失败;相应地,在执行读操作时,只需要读取一个节点的状态,就可以对该系统状态进行确认。

我们可以看到,使用WARO机制的集群在执行写操作时非常脆弱:只要有一个节点写入失败,这次操作就无法完成。不过,WARO机制牺牲了写操作的可用性,使读操作变得简单。

quorum机制就是对读写操作的折中考虑。在有冗余数据的分布式存储系统中,冗余数据对象会在不同的机器之间存放多份副件。但是在同一时刻,一个冗余数据对象的多份副件只能用于读或写操作。quorum机制可以保证,同一份冗余数据对象的每份副件都不会被超过两个访问对象读写,具体读写策略如下。

分布式存储系统中的每份冗余副件都被赋予了一票,假设系统中有V票,也就意味着一个冗余数据对象有V份冗余副件,每个读操作获得的票数必须大于最小读票数Vr(readquorum)才可以成功读取,每个写操作获得的票数必须大于最小写票数Vw(writequorum)才可以成功写入。那么,最小读写票数应满足如下限制

- Vr+Vw>V保证了一个冗余数据不会被多个访问对象同时读或写。当一个写操作请求传入时,它必须获得Vw个冗余副件的许可,而剩下的数量是V-Vw,小于Vr,因此不会再处理读操作请求。同理,当读操作请求已经获得了Vr个冗余副件的许可时,写操作请求就无法获得许可了。

- Vw-V/2保证了数据的串行化修改,一份冗余副件不可能同时被两个写操作请求修改。

通过上面描述的两种最小票数关系,我们可以计算出系统正确完成某项工作时所需节点数目的最小值,也可以称为quorum值,从而让分布式存储系统能够正确运行。

那么,在PBFT这类拜占庭容错共识算法集群中,要怎样确定quorum值的大小呢?

PBFT共识算法所要做的就是在容纳一定拜占庭节点的同时,对分布式集群进行写操作,因此,这里主要考虑的是最小写票数的计算,PBFT共识算法中的quorum值通常也指最小写票数。

假设,集群中有n个节点,其中有f个错误节点,写票数设置为m。在进行共识时,我们能够保证,在全部节点中,一共有n-f个节点的行为正常;同样地,当节点收到m条响应时,我们只能够保证其中有m-f条响应来自正常节点。将前面最小写票数的限制Vw-V/2类比到PBFT共识算法集群中,为了保证正确节点的写操作串行,可以求出写票数的要求

在实际进行共识时,为了进一步提高共识效率,加快写操作执行速率,可以取用最小值 作为写票数,可以更快地完成写票数的共识。

作为写票数,可以更快地完成写票数的共识。

当然,为了集群不会因为节点拒绝响应而不能运行,保证系统的活性,写票数还需要满足一定的上限要求:m≤n-f。可以验证,当节点总数满足拜占庭容错的条件n≥3f+1时,最小写票数的取值也能满足这一上限要求。

在一些场景下,根据实际需要,我们也可以牺牲一些共识的性能,取其他满足上下限要求的数值作为写票数,如直接使用n-f。

为了表达简洁,后文将直接以节点总数为3f+1的场景对PBFT共识算法进行描述,在该场景下,quorum值取2f+1即可满足最小写票数的要求。

节点角色与视图

在PBFT共识算法中,主要存在两种节点角色,分别为主节点与从节点。在每轮共识过程中,主节点将起引导作用,并在从节点的共同参与下完成三阶段的共识流程。

主节点不是一成不变的,集群整体会在一系列的主从配置中进行连续切换,其中,每轮主从配置都被称为视图(view),并对应一个视图编号,通常记为v。

在PBFT共识算法中,每个节点都会被分配一个序号,如果系统一共由m个节点组成,系统整体从0开始编号,那么集群编号可以记为 。

。

当处于视图v时,主节点编号的计算方式为 。

。

例如,当前一共有4个节点,序号分别记为0、1、2、3,当视图v=31时,主节点序号为3,也就是第四个节点。

共识通信

在PBFT共识算法集群中,节点在发送消息时会附加自身的签名,保证该消息的来源可信。在进行点对点消息传递时,双方会进行会话密钥协商,保证点对点通信的安全性。

2、共识流程

PBFT共识算法的共识流程主要有以下三步。

- Step1:请求阶段。客户端发送请求到主节点,或者通过从节点转发到主节点。

- Step2:共识阶段。集群执行PBFT共识算法的核心共识流程。

- Step3:执行阶段。节点确认共识完成并执行请求,将执行结果反馈给客户端。

对客户端来说,在收到来自f+1个不同节点的相同执行结果后,确认共识已经正确完成,并将该执行结果确认为操作结果。

核心共识流程

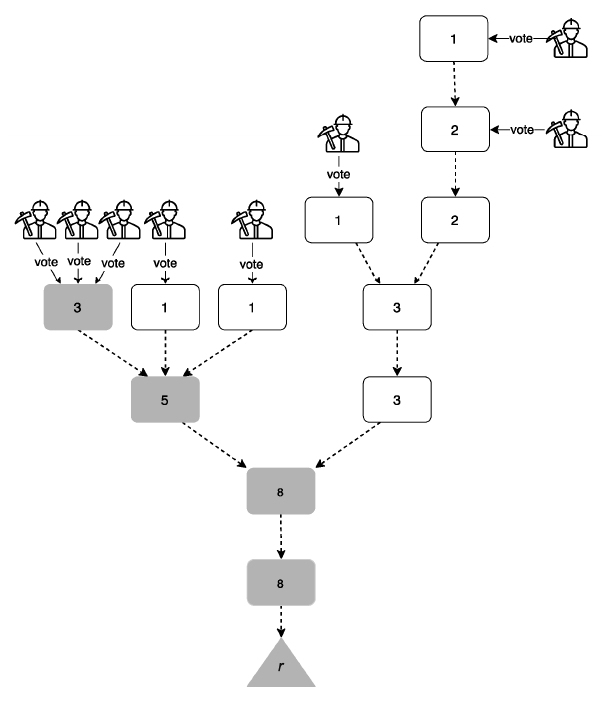

下面介绍PBFT共识算法的核心共识流程,如下图所示。

在请求阶段,客户端发起请求,主节点在收到客户端的请求后,触发核心共识流程。

PBFT共识算法的核心共识流程分为三个阶段:

- pre-prepare阶段

- prepare阶段

- commit阶段

其中,节点在prepare阶段和commit阶段各进行了一轮投票,分别对消息的合法性与待执行进行了确认。在上图中,c代表客户端,0、1、2、3代表节点的编号,在视图为0(v=0)的情况下,节点0是主节点,节点1、2、3为从节点。打叉的节点3代表拜占庭节点,这里表现的恶意行为就是对其他节点的请求无响应。

核心共识流程如下。

- pre-prepare阶段:

- 主节点在收到客户端的请求后,主动向其他节点广播pre-prepare消息,其中,v为当前视图编号,n为主节点分配的请求序号,D(m)为消息摘要,m为消息。在主节点完成pre-prepare消息的广播后,主节点对于该请求进入pre-prepared状态,表示该请求已经在主节点处通过合法性验证。

- 从节点在收到pre-prepare消息之后,对该消息进行合法性验证,若通过验证,则该节点对于该请求进入pre-prepared状态,表示该请求在从节点处通过合法性验证。否则,从节点拒绝该请求,并触发视图切换流程。一种典型的从节点拒绝的情况是,v和n曾经出现在之前收到的消息中,但是对应的消息摘要D(m)却和之前的不一致,或者请求编号不在高低水位之间,这时候从节点就会拒绝该请求。

- prepare阶段:当从节点对于该请求进入pre-prepared状态后,向其他节点广播prepare消息,其中,v为当前视图编号,n为主节点分配的请求序号,D(m)为消息摘要,i为当前节点的标识。如果节点对于该请求进入pre-prepared状态,并且收到2f条来自不同节点对应的prepare消息(包含自身发出的),那么该节点就对于该请求进入prepared状态。其中,pre-prepared状态对应的pre-prepare消息可以视为主节点对该请求的合法性验证,它与另外2f条prepare消息一同构成了大小为2f+1的合法性验证集合,表示该请求已经在全网通过合法性验证。

- commit阶段:实际上,如果不考虑视图变更的问题,当请求在全网通过合法性验证,即该节点对于该请求进入prepared状态后,该请求就在当前视图中确定了执行顺序,可以执行。但是,如果发生视图变更,则只通过pre-prepare、prepare阶段不足以对视图变更过程中的交易进行定序(在视图变更时,节点有可能会获取到来自不同视图但拥有相同序号的不同消息)。因此,PBFT共识算法中额外增加了commit阶段对请求的执行进行验证,确保已经执行的请求在发生视图变更时能够在新视图中被正确保留。在当前节点对于该请求进入prepared状态后,当前节点会向其他节点广播commit消息

,其中,v为当前视图编号,n为当前请求序号,i为当前节点标识。如果当前节点对于该请求进入prepared状态,并且收到2f+1条来自不同节点对应的commit消息(包含自身发出的),那么当前节点就会对于该请求进入committed状态,并执行。执行完毕后,节点会将执行结果反馈给客户端进行后续判断。

,其中,v为当前视图编号,n为当前请求序号,i为当前节点标识。如果当前节点对于该请求进入prepared状态,并且收到2f+1条来自不同节点对应的commit消息(包含自身发出的),那么当前节点就会对于该请求进入committed状态,并执行。执行完毕后,节点会将执行结果反馈给客户端进行后续判断。

上述就是PBFT共识算法的核心共识流程。

checkpoint机制

PBFT共识算法在运行过程中会产生大量的共识数据,因此需要执行合理的垃圾回收机制,及时清理多余的共识数据。为了达成这个目的,PBFT共识算法设计了checkpoint流程,用于进行垃圾回收。

checkpoint即检查点,是检查集群是否进入稳定状态的流程。在进行检查时,节点广播checkpoint消息,n为当前请求序号,d为消息执行后获得的摘要,i为当前节点标识。当节点收到来自不同节点的2f+1条有相同<n,d>的checkpoint消息时,认为当前系统对于序号n进入了稳定检查点(stable checkpoint)。此时,将不再需要stablecheckpoint之前的共识数据,可以对其进行清理。

不过,如果为了进行垃圾回收而频繁执行checkpoint,那么将会对系统运行带来明显负担。所以,PBFT共识算法为checkpoint流程设计了执行间隔,每执行K个请求,节点就主动发起一次checkpoint,来获取最新的stable checkpoint。

除此之外,PBFT共识算法引入了高低水位(High-Low Watermarks)的概念,用于辅助进行垃圾回收。在进行共识的过程中,由于节点之间的性能差距,可能会出现节点间运行速率差异过大的情况。部分节点执行的序号可能会领先其他节点,导致领先节点的共识数据长时间得不到清理,造成内存占用过大的问题,而高低水位的作用就是对集群整体的运行速率进行限制,从而限制节点的共识数据大小。

在高低水位系统中,低水位记为h,通常指的是最近一次的stable checkpoint对应的高度。高水位记为H,计算方式为H=h+L,其中,L代表共识缓存数据的最大限度,通常为checkpoint间隔K的整数倍。当节点产生的checkpoint进入stable checkpoint状态时,节点将更新h。当执行到H时,如果h没有被更新,则节点会暂停执行更大序号的请求,等待其他节点的执行,待h更新后重新开始执行更大序号的请求。

如下图所示,设置checkpoint间隔K为10,系统每执行10个请求,就进行一次checkpoint;设置L为30,即允许节点最多缓存30次请求的共识数据。节点1、2、3的当前请求编号是109,而节点0的当前请求编号为130。那么,此时系统的stable checkpoint为100,对应的h也为100。计算可得,H=h+L=130。此时,节点0已经执行到了最高水位130,那么它将暂停并等待其他节点执行。当其他节点执行完110号请求后,系统将进行一次checkpoint,从而将stable checkpoint更新到110,高/低水位随之更新为H=140/h=110。此时,110号请求之前的共识数据就可以回收了。

视图变更流程

当主节点超时无响应或从节点集体认为主节点是问题节点时,就会触发视图变更(view-change)。视图变更完成后,视图编号将加1,主节点也会切换到下一个节点。如下图所示,节点0发生异常,触发视图变更流程,变更完成后,节点1成为新的主节点